MLA 引入 RoPE

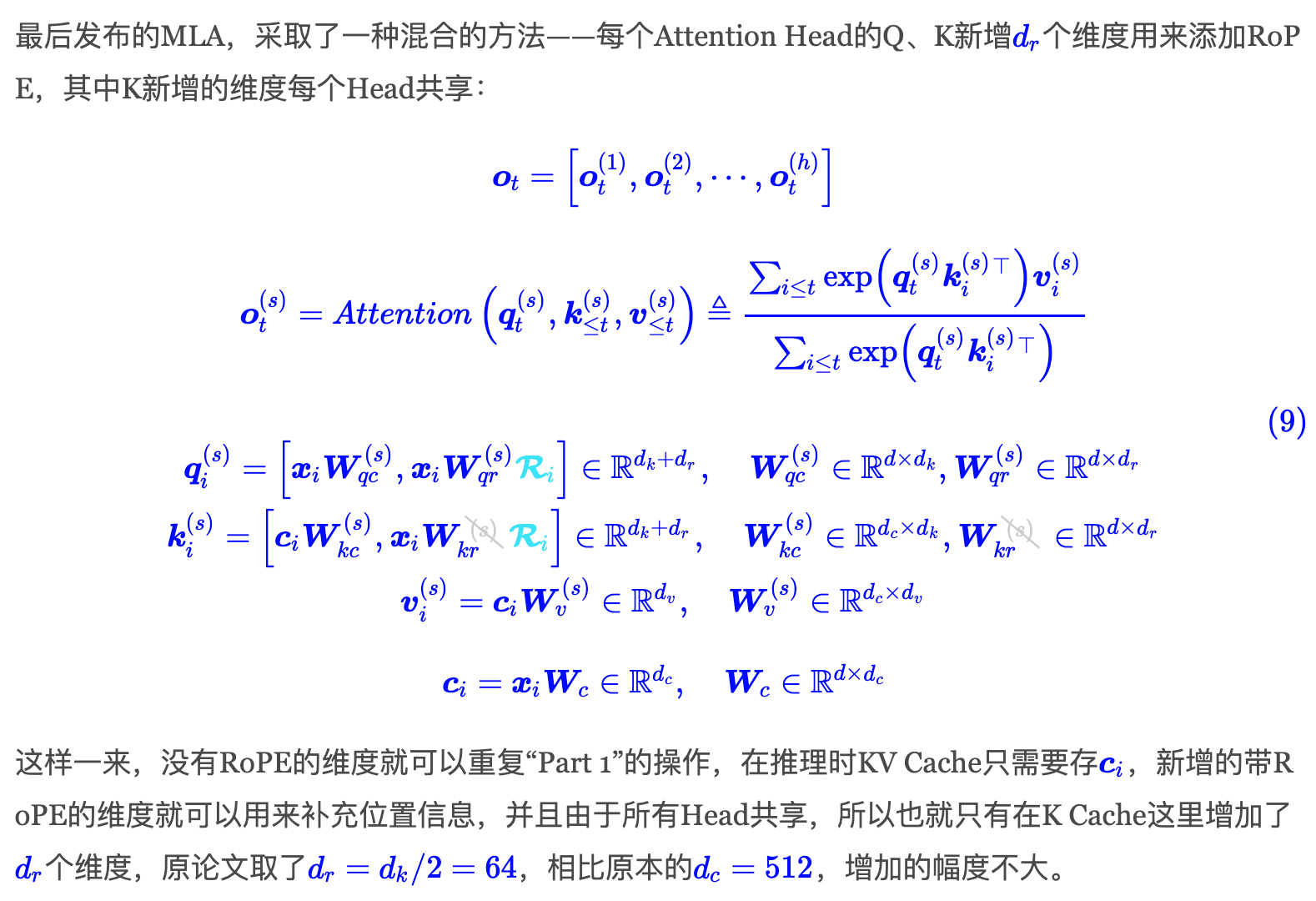

由于RoPE的存在导致前文所说的上投影矩阵不能直接合并成一个,中间隔着一个旋转编码矩阵:#card

DeepSeek的解决方法是,直接在原有 $q, k$ 后拼接 $d_h^R$ 维的位置向量,计算过程为:#card

前段时间,笔者也很荣幸跟DeepSeek团队讨论过这个问题,但这个问题可以说非常本质,所以当时笔者实际上也没能提出什么有效的建议。最简单的方式是放弃RoPE,换用其他基于Attention Bias的位置编码,如ALIBI,但DeepSeek的实验显示它明显不如RoPE(注意,MLA不是不能加RoPE,而是加了RoPE之后无法用恒等变换技巧来减少KV Cache),笔者也提议过换Sandwich,它不像ALIBI单调衰减到负无穷,估计效果会好些,但感觉是治标不治本。#card

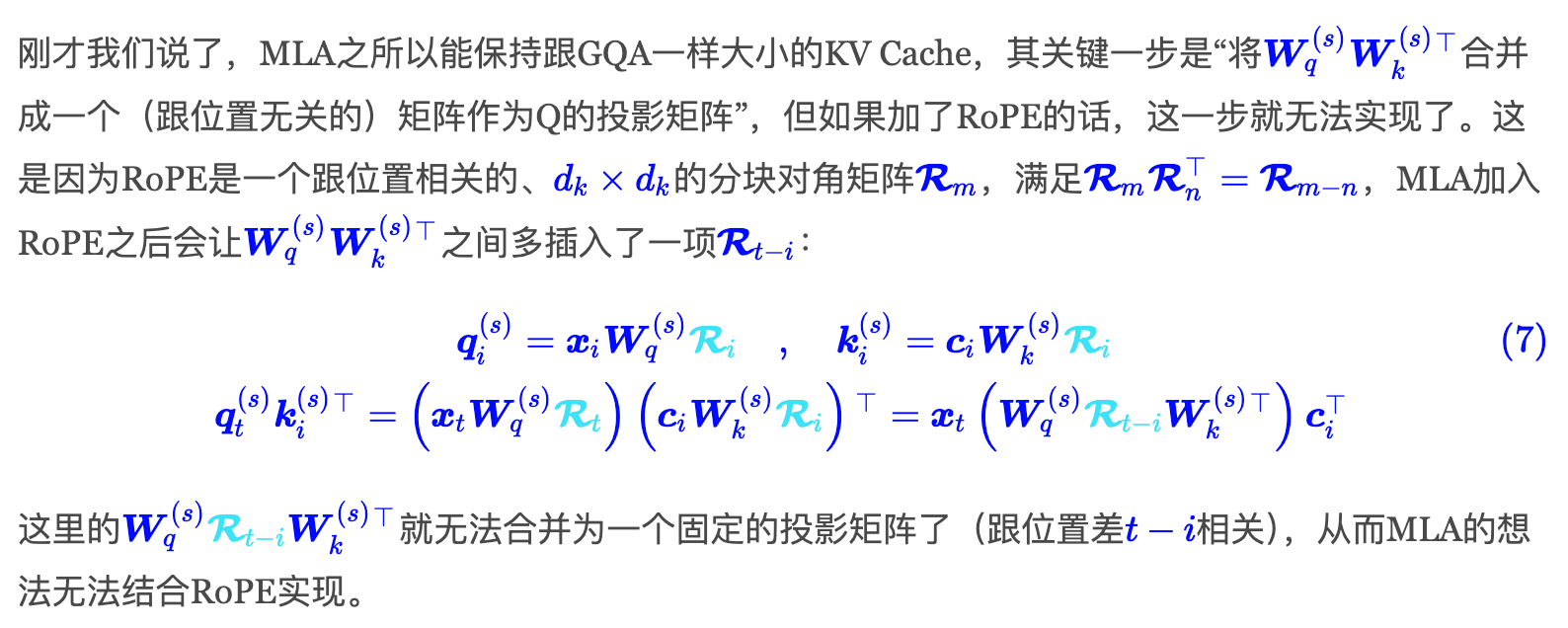

最后发布的MLA,采取了一种混合的方法——每个Attention Head的Q、K新增 #card