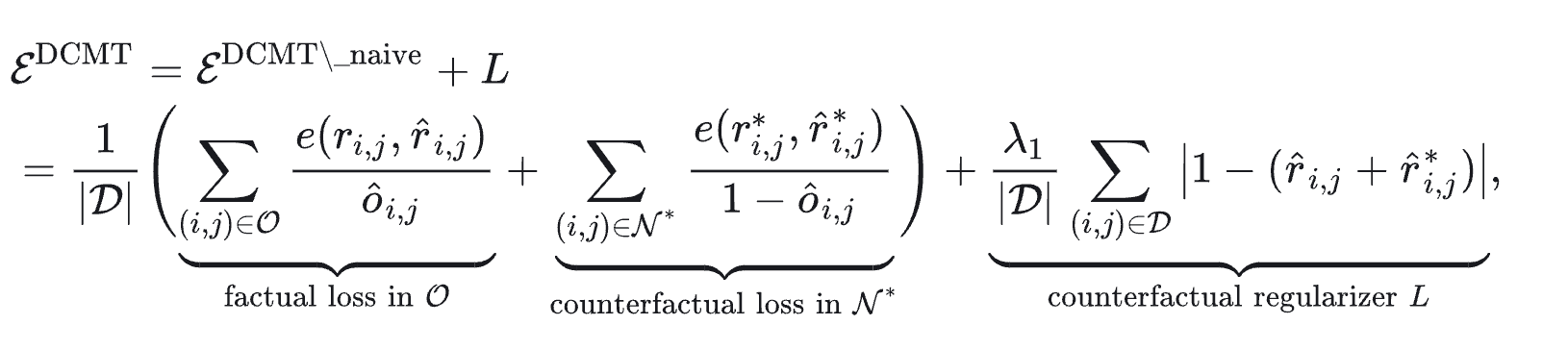

DCMT CVR Loss

第一块是factual loss :-> $\sum_{(i, j) \in \mathcal{O}} \frac{e\left(r_{i, j}, \hat{r}{i, j}\right)}{\hat{o}{i, j}}$ 是事实CVR预测值与事实点击空间样本 $\mathcal{O}$ 之间的误差。这边的误差函数是log loss。

第二块是counterfactual loss :-> $\sum_{(i, j) \in \mathcal{N}^} \frac{e\left(r_{i, j}^, \hat{r}{i, j}^*\right)}{1-\hat{o}{i, j}}$ ,是反事实CVR预测值与反事实点击空间 $\mathcal{N}^*$(事实未点击空间的镜像空间)样本之间的误差。

第三块是counterfactual regularizer :-> $\left|1-\left(\hat{r}{i, j}+\hat{r}{i, j}^\right)\right|$ ,即上面所述的软性约束 $\hat{r}{i, j}+\hat{r}{i, j}^ \approx 1$ 。

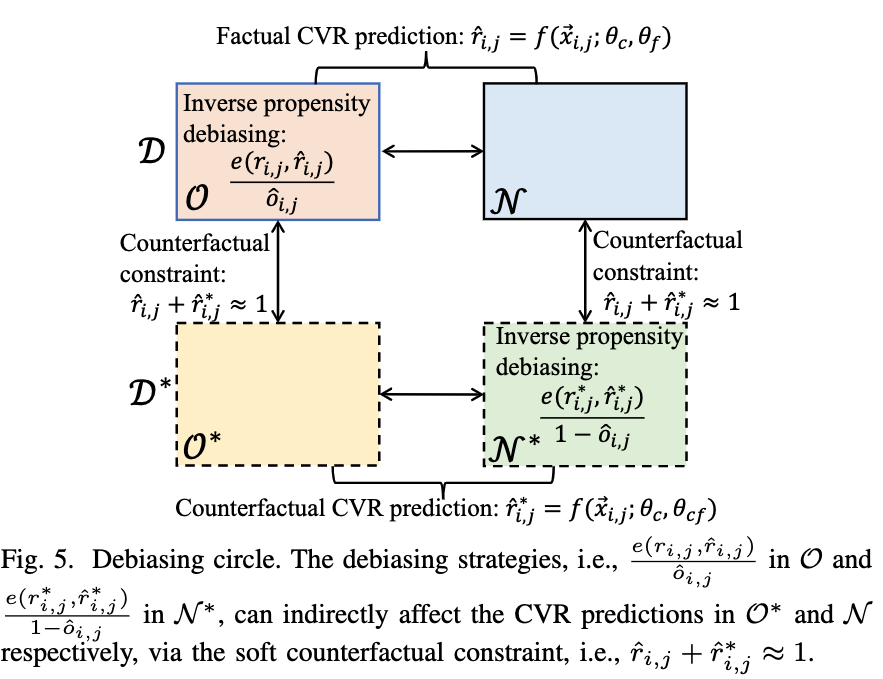

如图所示,我们的DCMT的CVR任务部分,形成了一个有效的纠偏链路。

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc0NDM4NDk4MjAyMV8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MzM4LjMzMTY4ODA2NTMwNzksInRvcCI6MzYuMjk5Mjc1NTE0NTI4Miwid2lkdGgiOjI0Mi4zNjQ0MDcxNjA1NDI4NywiaGVpZ2h0IjoyNS4xMjY2OTY2NzI3ODc4NCwiYW5nbGUiOjAsImNJZCI6MX0seyJsZWZ0IjoyNzcuMTU1Mzk5MTEyODUwMywidG9wIjo1MDguNzg5NzAxMzE3NzEzOCwid2lkdGgiOjIxNi4xNjg1MzEyODAyNTEsImhlaWdodCI6MzAuOTc1NzQ5NDM0NTE3ODYyLCJhbmdsZSI6MCwiY0lkIjoxfV19fQ==

+优点:

在全曝光空间做逆倾向加权,可以利用全曝光样本空间数据来训练我们的CVR任务,使得训练空间和推断空间对齐。也可以缓解选择偏差(或者NMAR问题)。#card

- 通过 $\mathcal{E}^{D C M T}$ 公式可知,我们直接在事实点击空间 $\mathcal{O}$ 进行逆倾向纠偏(这里的逆点击倾向权重是 $1 / \hat{o}_{i, j}$ )

- 我们直接在反事实的点击空间 $\mathcal{N}^*$(即事实的未点击空间的镜像)也进行了逆倾向纠偏(这里的反事实空间的逆点击倾向权重就是事实空间的逆不点击倾向权重 $1 /\left(1-\hat{o}_{i, j}\right)$ )。

(2)而软性约束的最大作用是可以缓解假负样本的问题。例如在事实未点击空间 $\mathcal{N}$ 有一个样本

如果这个样本是个假负样本,那么 $\left|1-\left(\hat{r}{i, j}+\hat{r}{i, j}^\right)\right|$ 值比较大,则说明对于这个样本而言,事实CVR预测值 $\hat{r}{i, j}$ 和反事实CVR预测值 $\hat{r}{i, j}^$ 之间存在矛盾(不符合先验知识)。

这是因为,这个假负样本本应该进入到事实点击转化空间的,然而却进入了事实未点击空间,所以事实CVR预测值 $\hat{r}_{i, j}$ 预测值会被拉低。

而它对应的反事实CVR预测值 $\hat{r}{i, j}^*$ 也不会太高,因为这个样本进入反事实点击转化空间的概率也不应该很高。所以 $\left|1-\left(\hat{r}{i, j}+\hat{r}_{i, j}^*\right)\right|$ 值会比较大。

DCMT通过最小化 $\left|1-\left(\hat{r}{i, j}+\hat{r}{i, j}^*\right)\right|$ 这个软性约束会去纠正假负样本对应的 $\hat{r}_{i, j}$ ,使得它更大,从而接近真实值。