ALiBi

思路:ALiBi(Attention with Linear Biases)#card

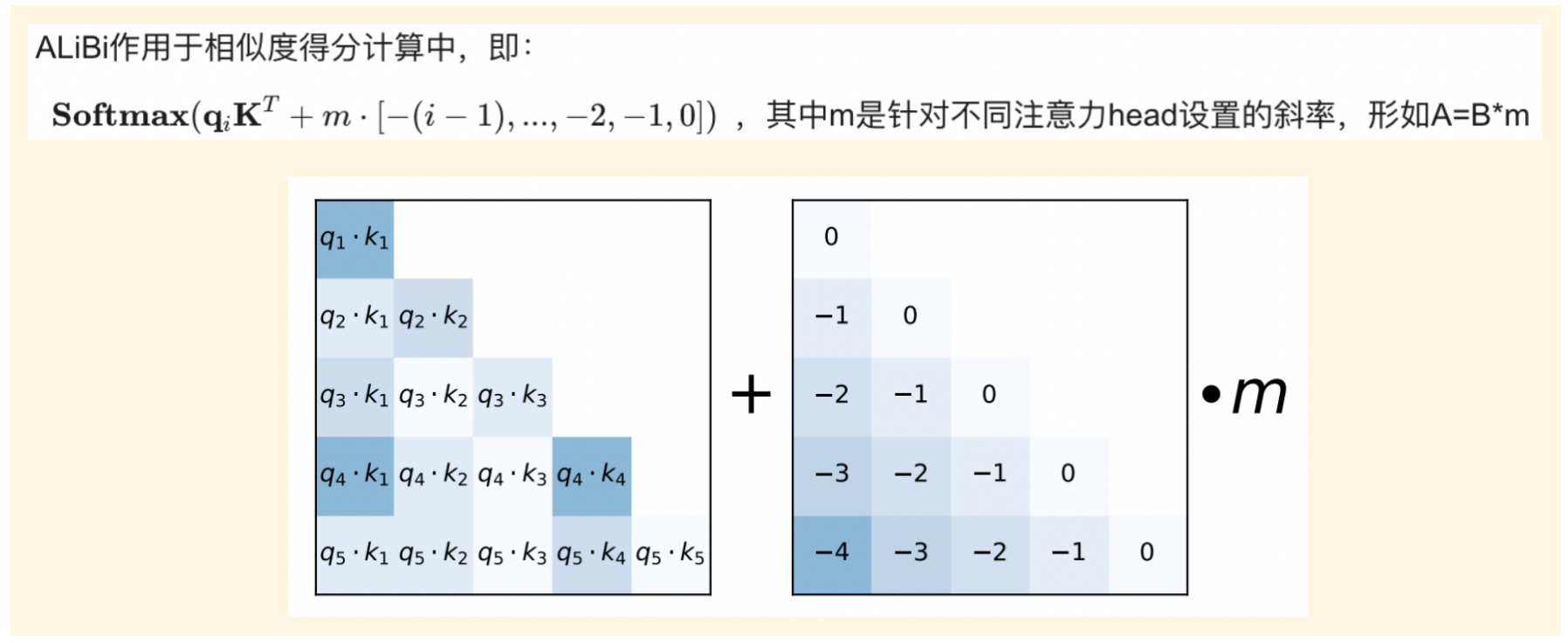

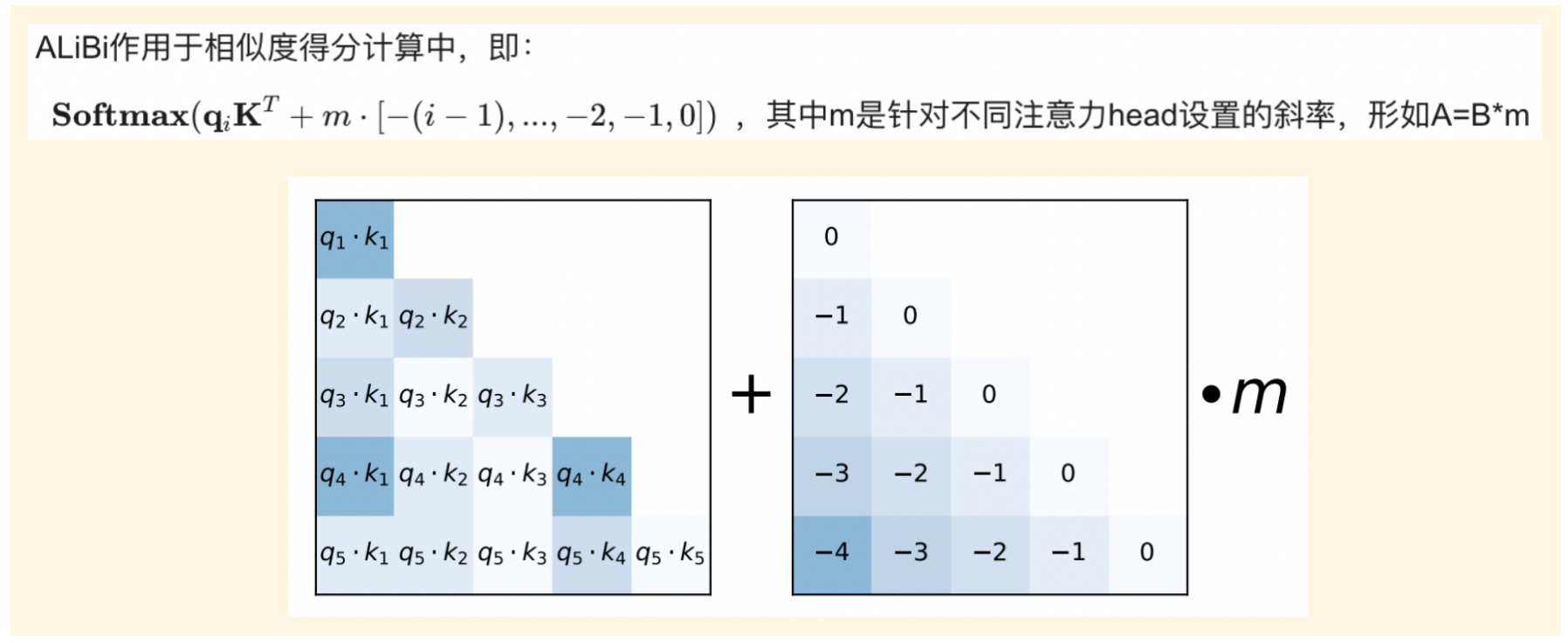

- 不向word embedding中添加positional embedding,而是”根据token之间的距离给 attention score 加上一个预设好的偏置矩阵”,即直接引入相对位置。

举例:两个token之间存在一个相对位置差1,就加上一个 -1 的偏置,如果token之间的距离越远则这个负数就越大,代表它们之间的相关性更低。#card

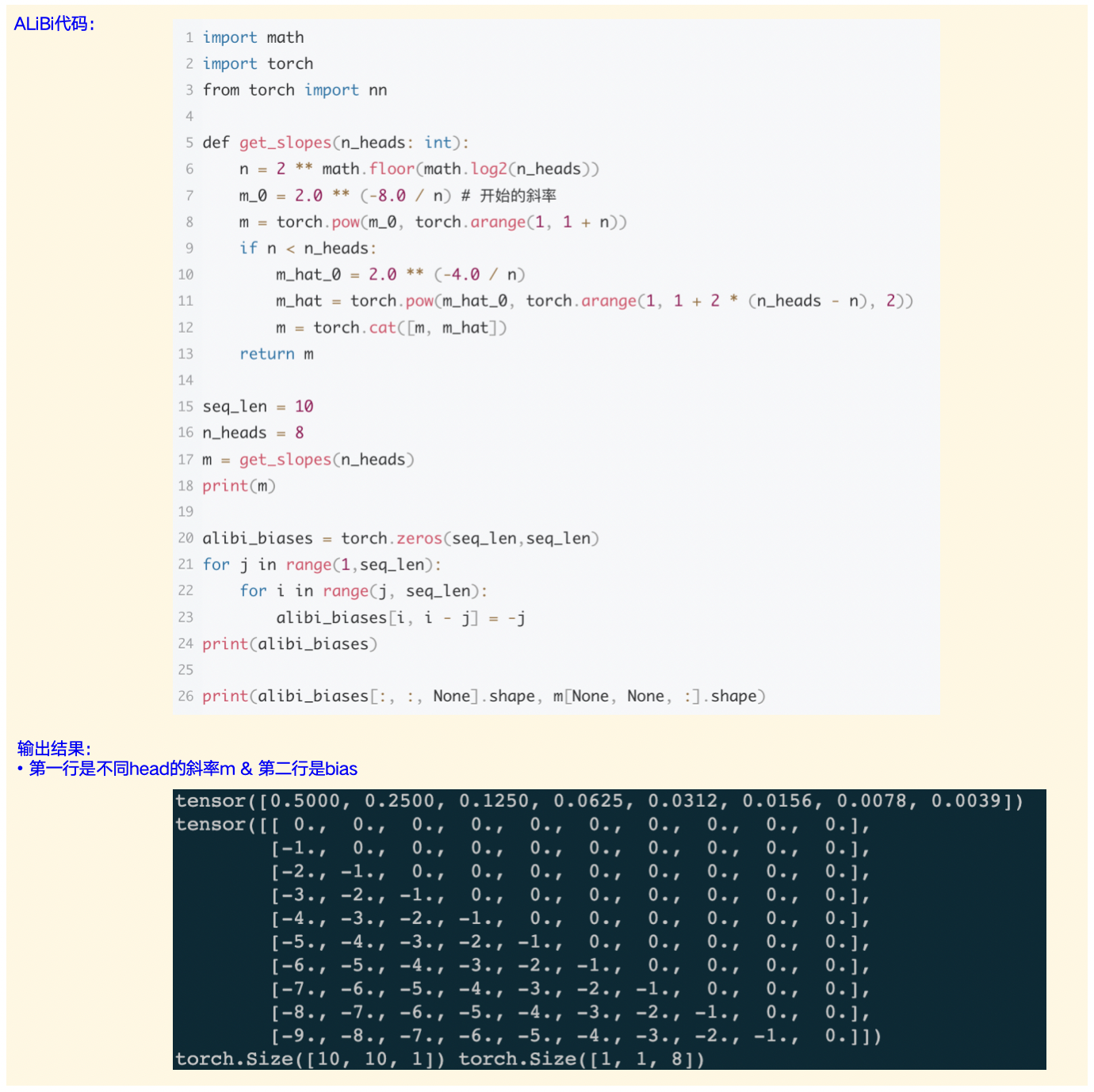

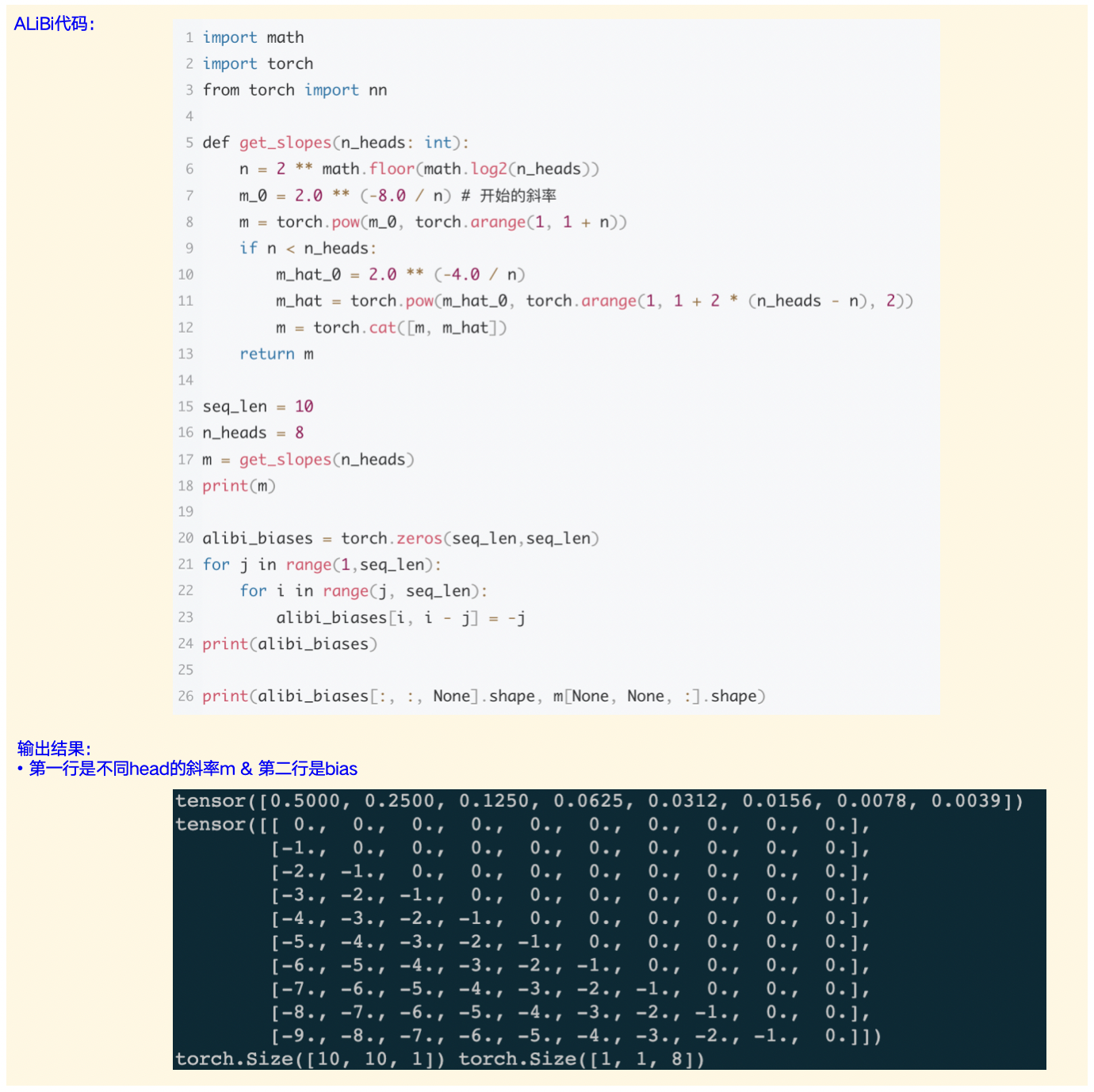

代码 #card

思路:ALiBi(Attention with Linear Biases)#card

举例:两个token之间存在一个相对位置差1,就加上一个 -1 的偏置,如果token之间的距离越远则这个负数就越大,代表它们之间的相关性更低。#card

代码 #card