Normalization

解决 [[Internal Covariance Shift]]

- 本质是平滑 Loss,保持在梯度下降过程中的稳定。

连续特征的值分布不统一,会导致训练波动,影响收敛速度。

归一化:对不同特征维度的伸缩变换的目的是使各个特征维度对目标函数的影响权重是一致的,即使得那些扁平分布的数据伸缩变换成类圆形。

[[归一化方法]]

减少人为参数选择

缓解过拟合

减少梯度消失,加快收敛速度,提高训练精度

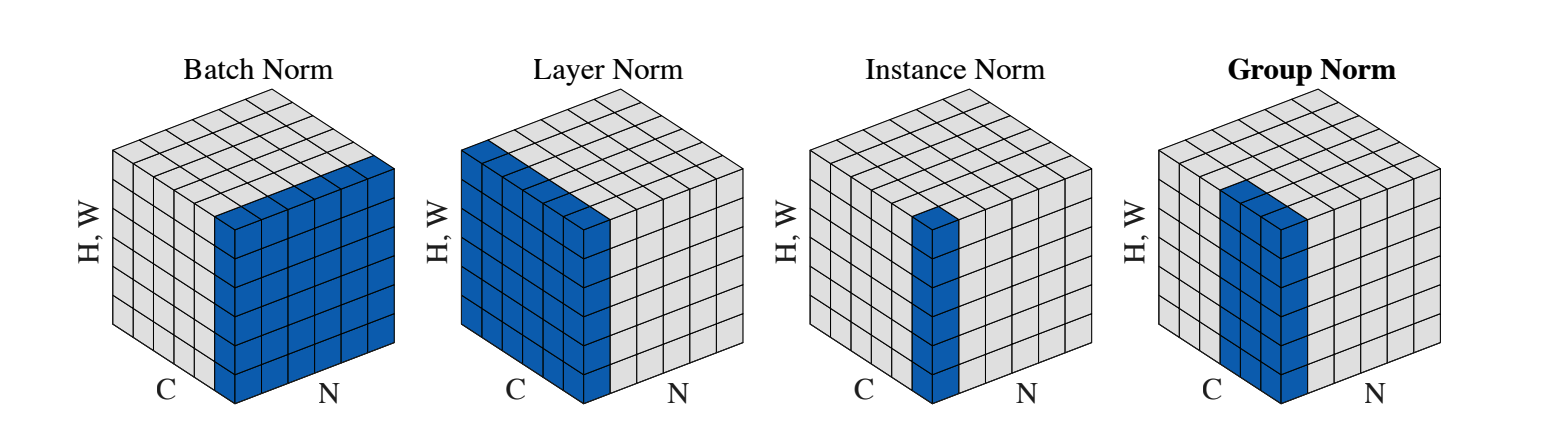

通过计算均值和方差的集合分成,输入 [N, C, H, W] 维度图片

- 不同方法的区别在于神经元集合 S 的范围如何确定

[[Group Normalization]]

[[Batch Normalization]] 神经网络中间层进行归一化

- C 维度上,计算

(N, H, W)的统计量

- C 维度上,计算

[[Layer Normalization]] RNN 等序列模型

[[Instance Normalization]]

与

LN相同对单个样本操作IN对同一层神经元中的同一个通道进行归一化

[[Weight Normalization]]