缩写 :-> PAD

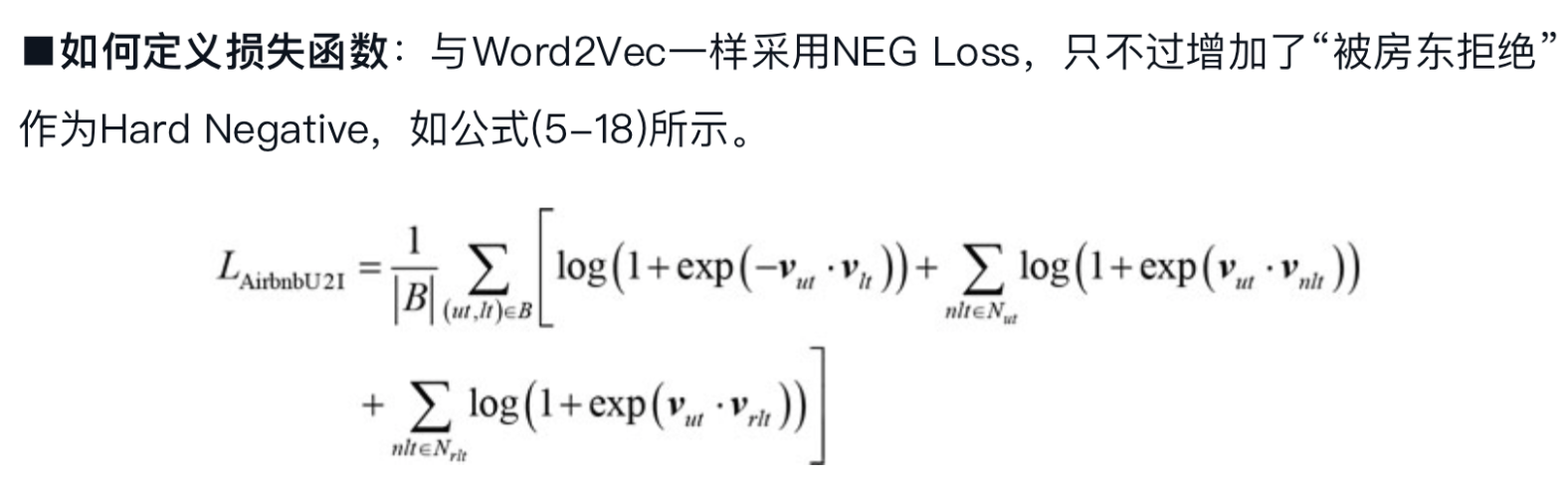

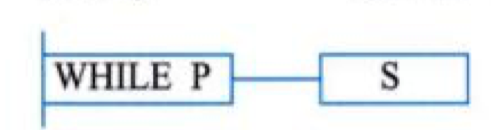

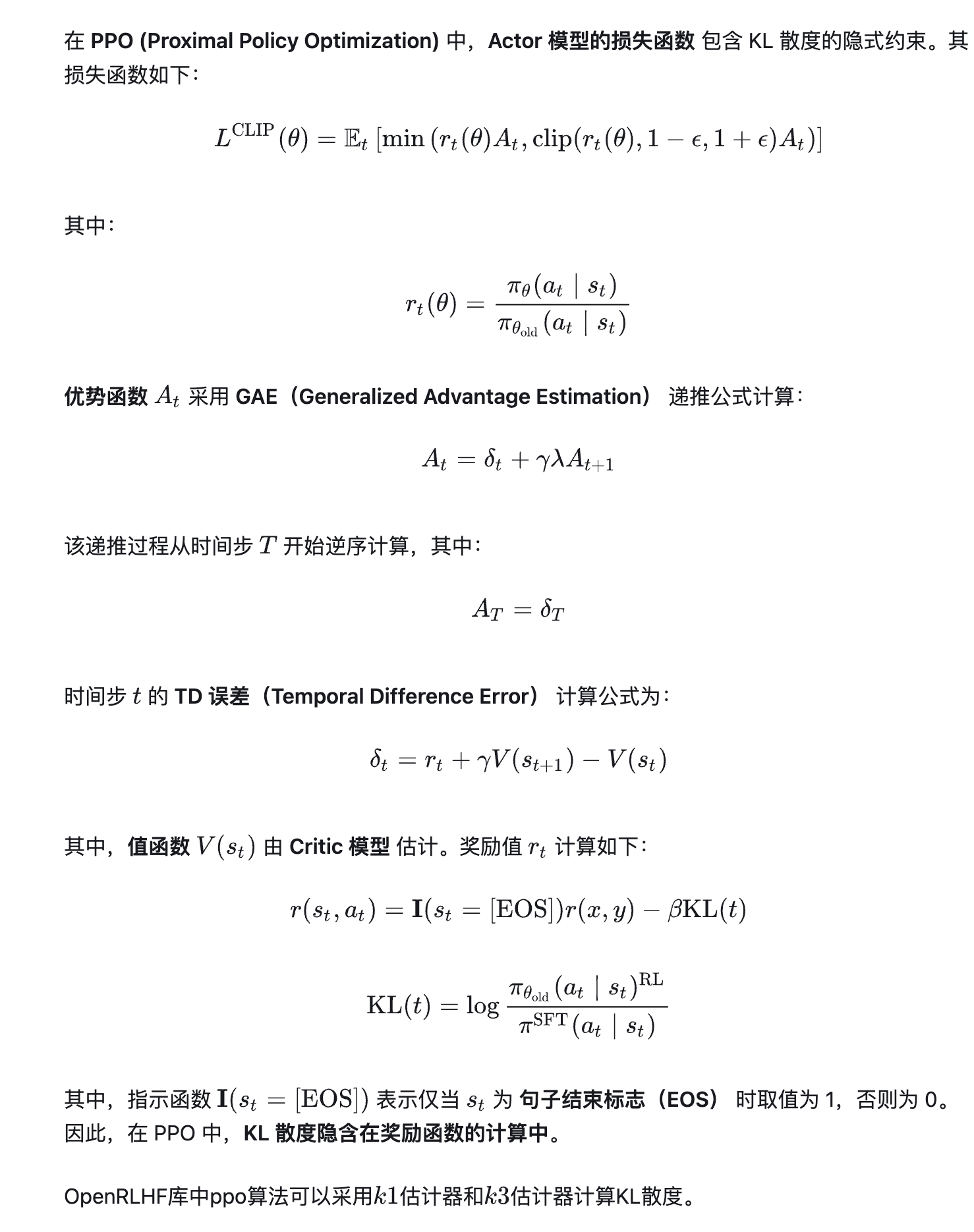

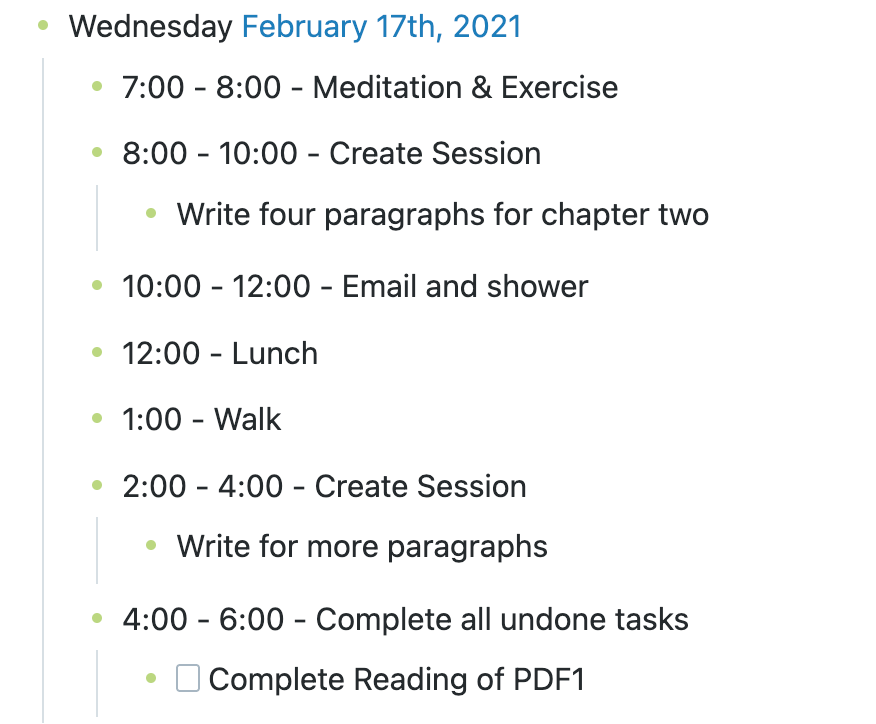

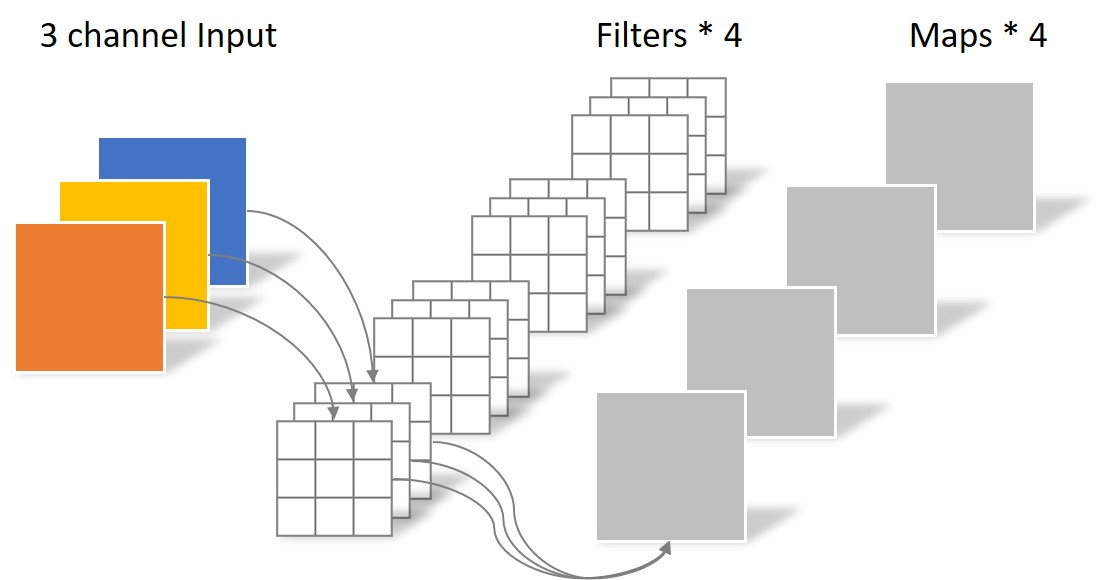

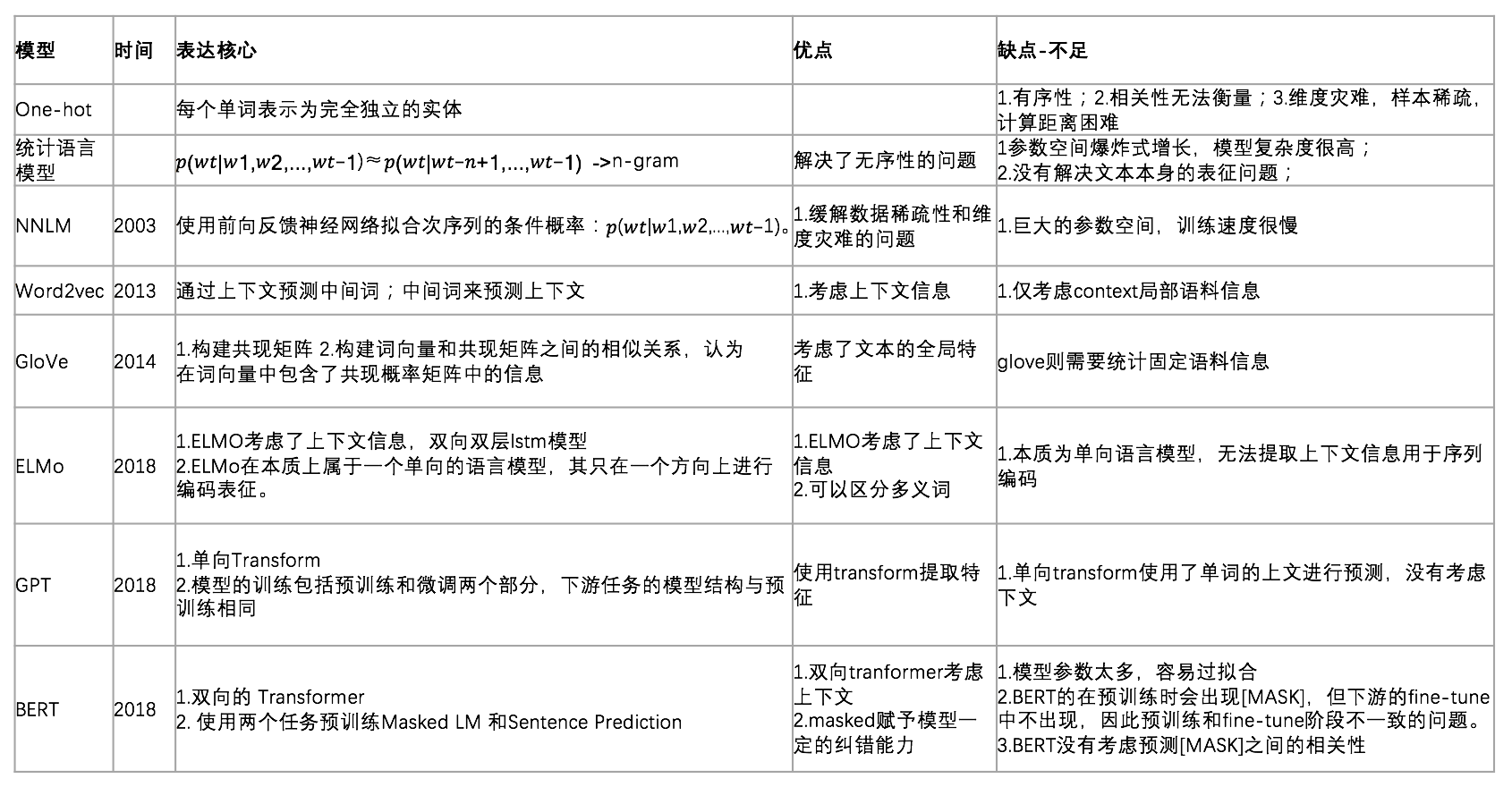

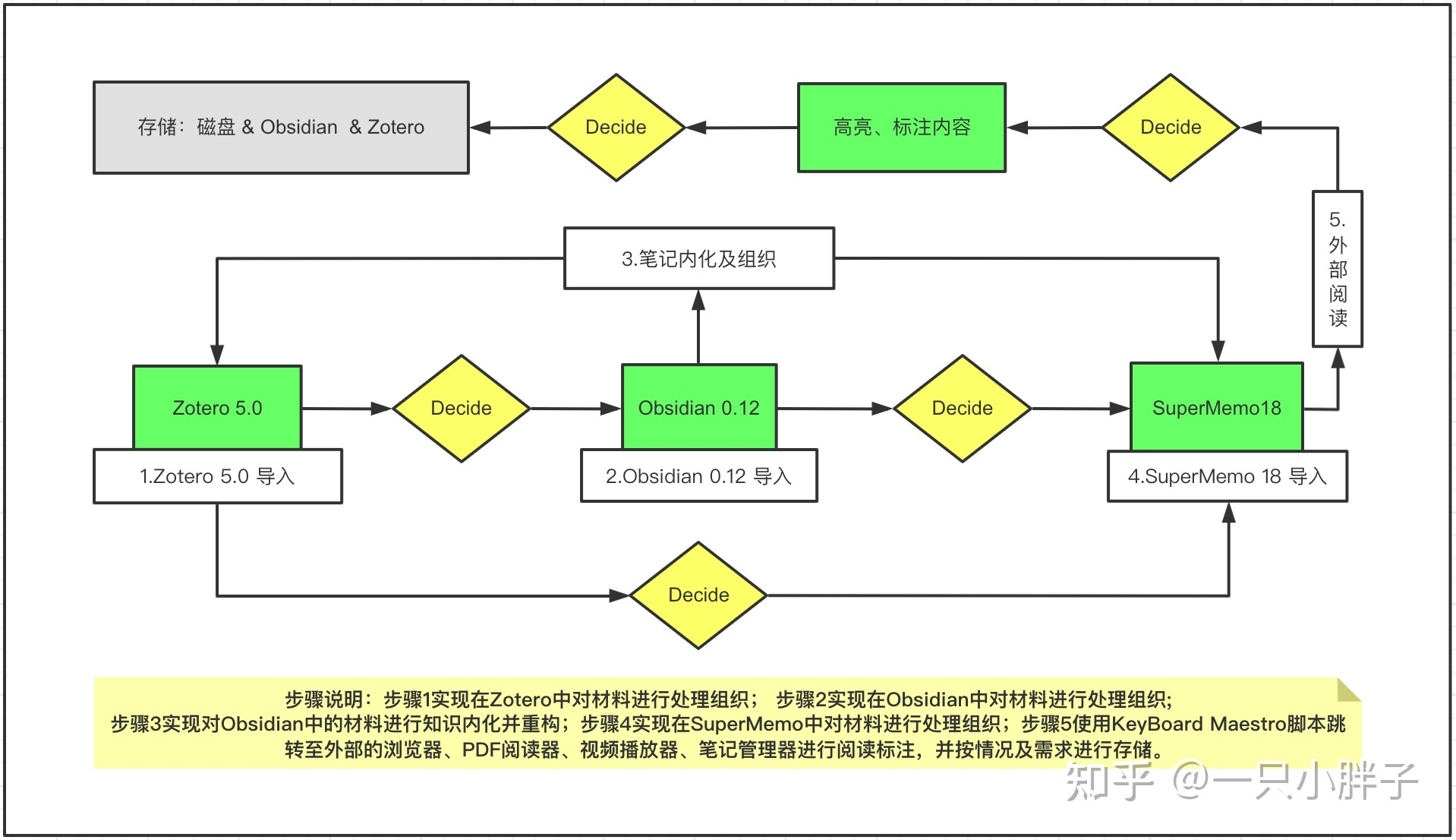

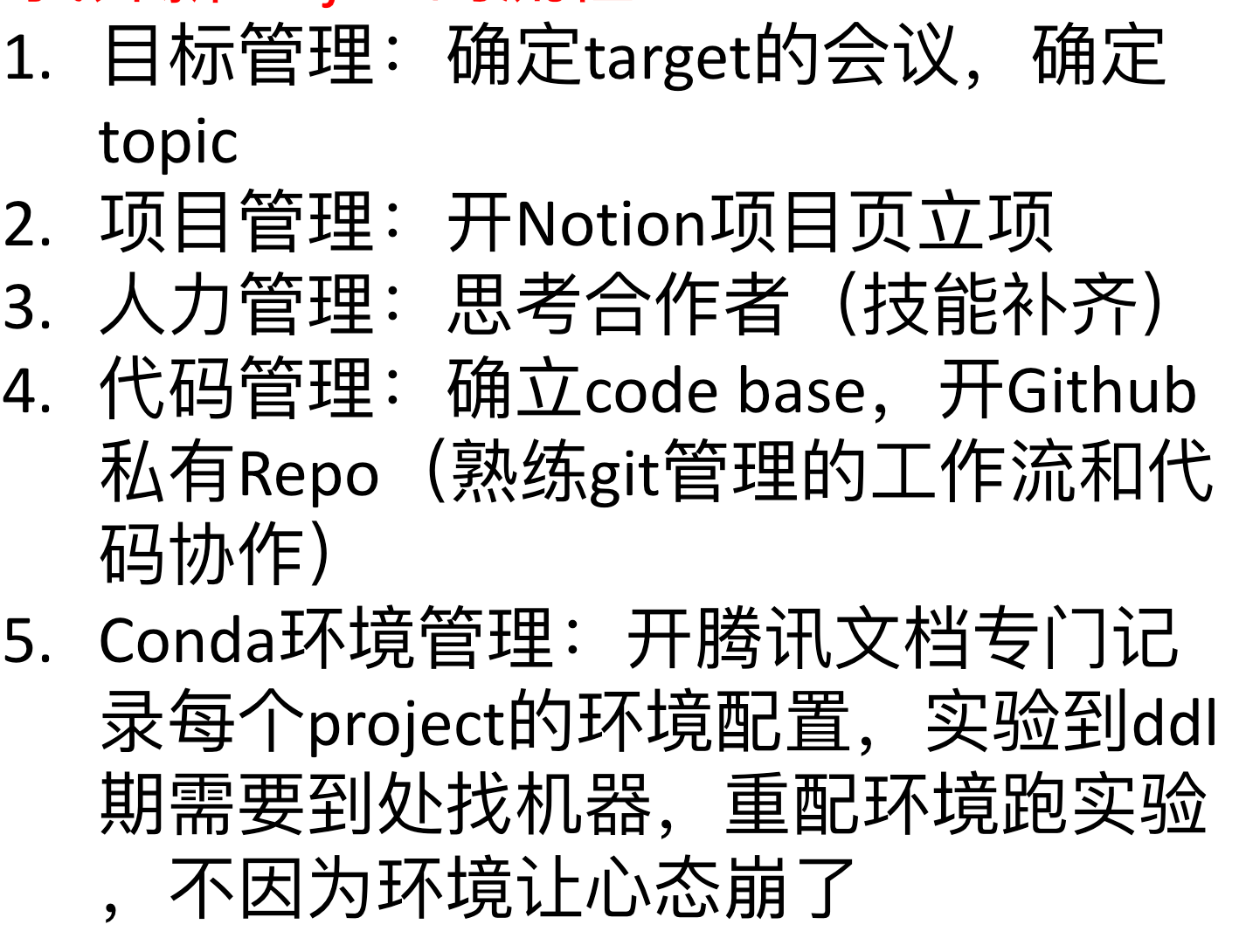

顺序图 #card

选择型 #card

多分支选择型 #card

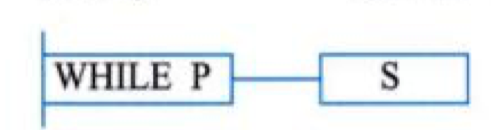

当型循环 #card

直到型循环 #card

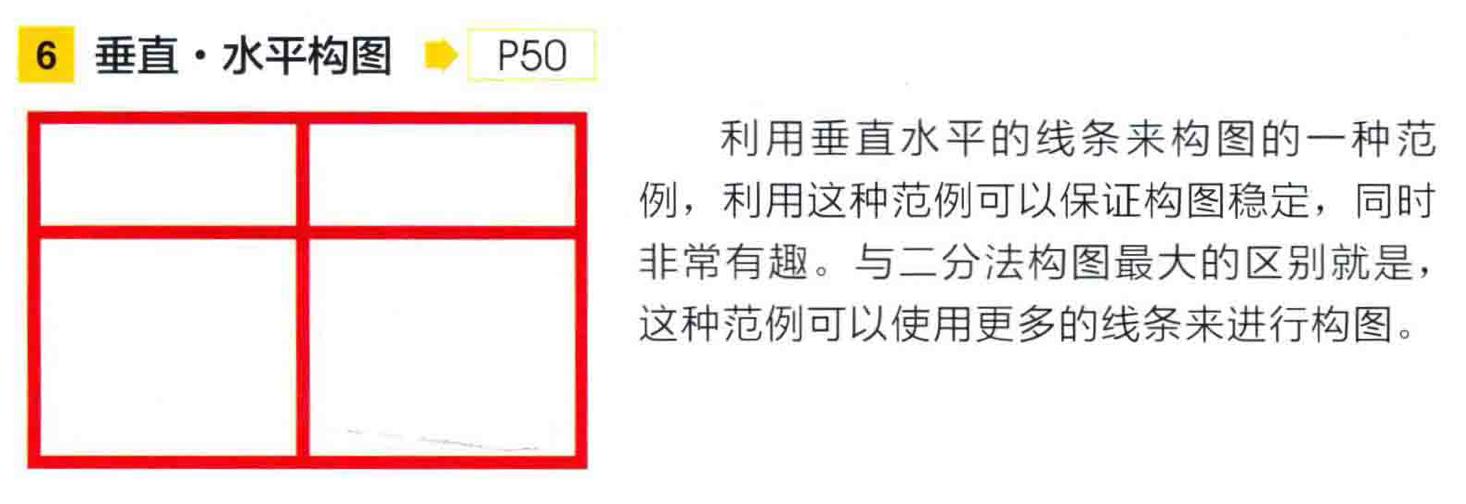

缩写 :-> PAD

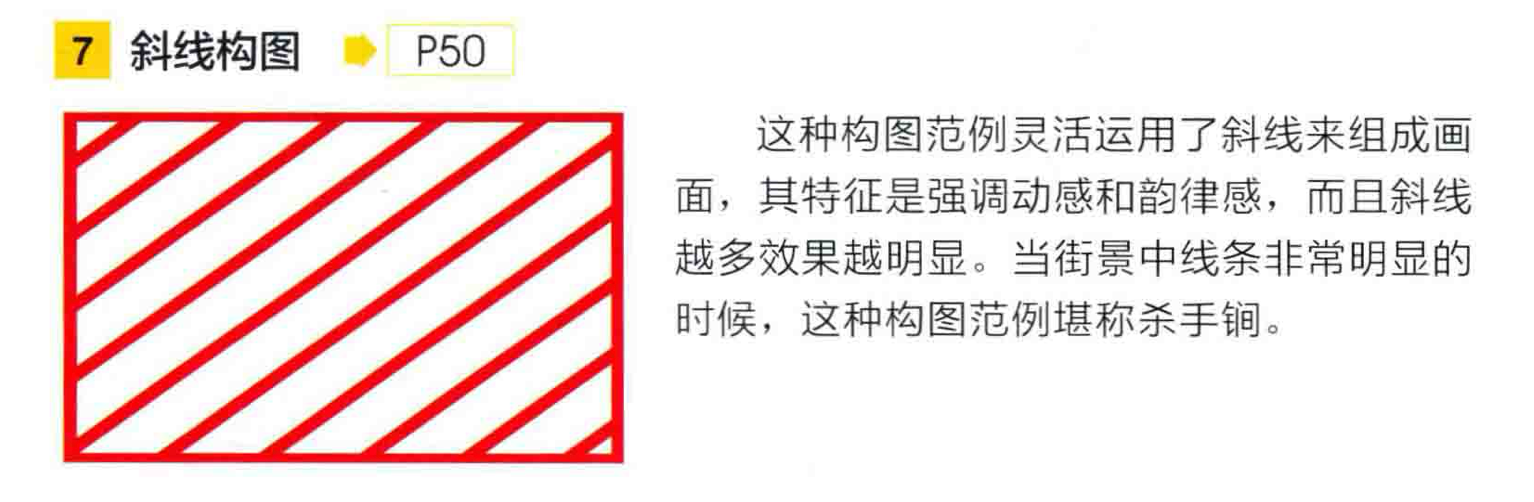

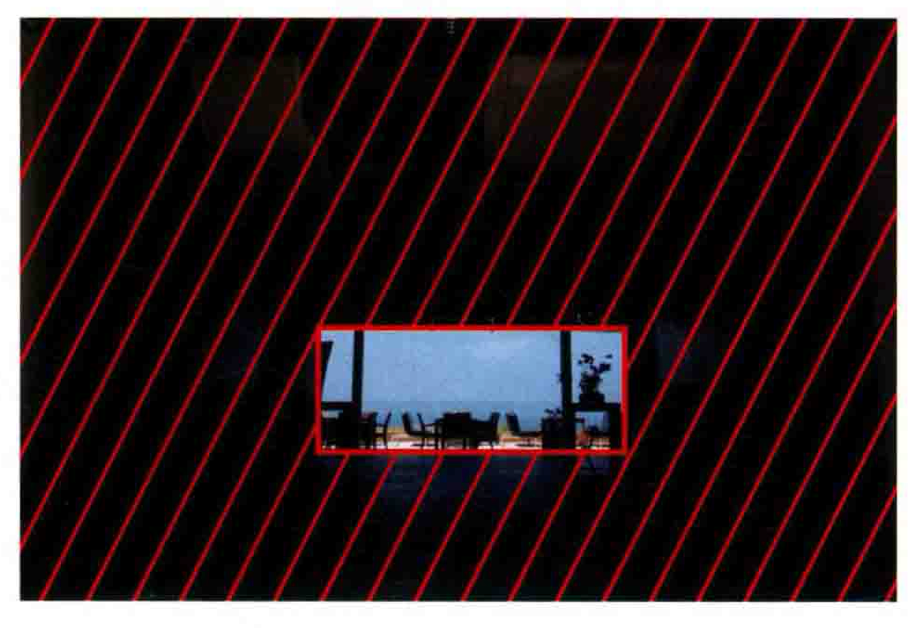

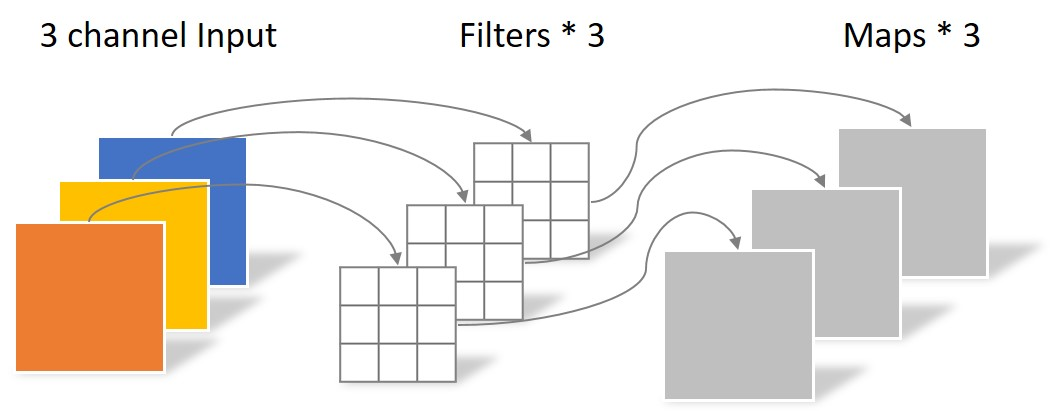

顺序图 #card

选择型 #card

多分支选择型 #card

当型循环 #card

直到型循环 #card

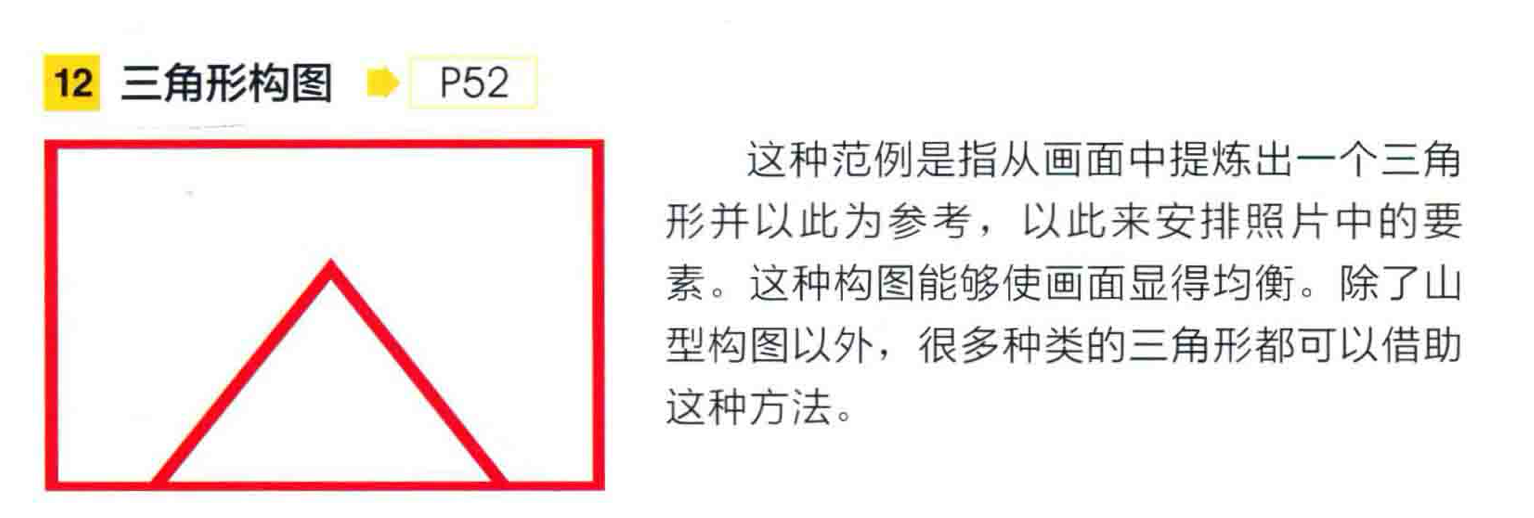

测试的技术依据是 :-> 软件概要设计文档

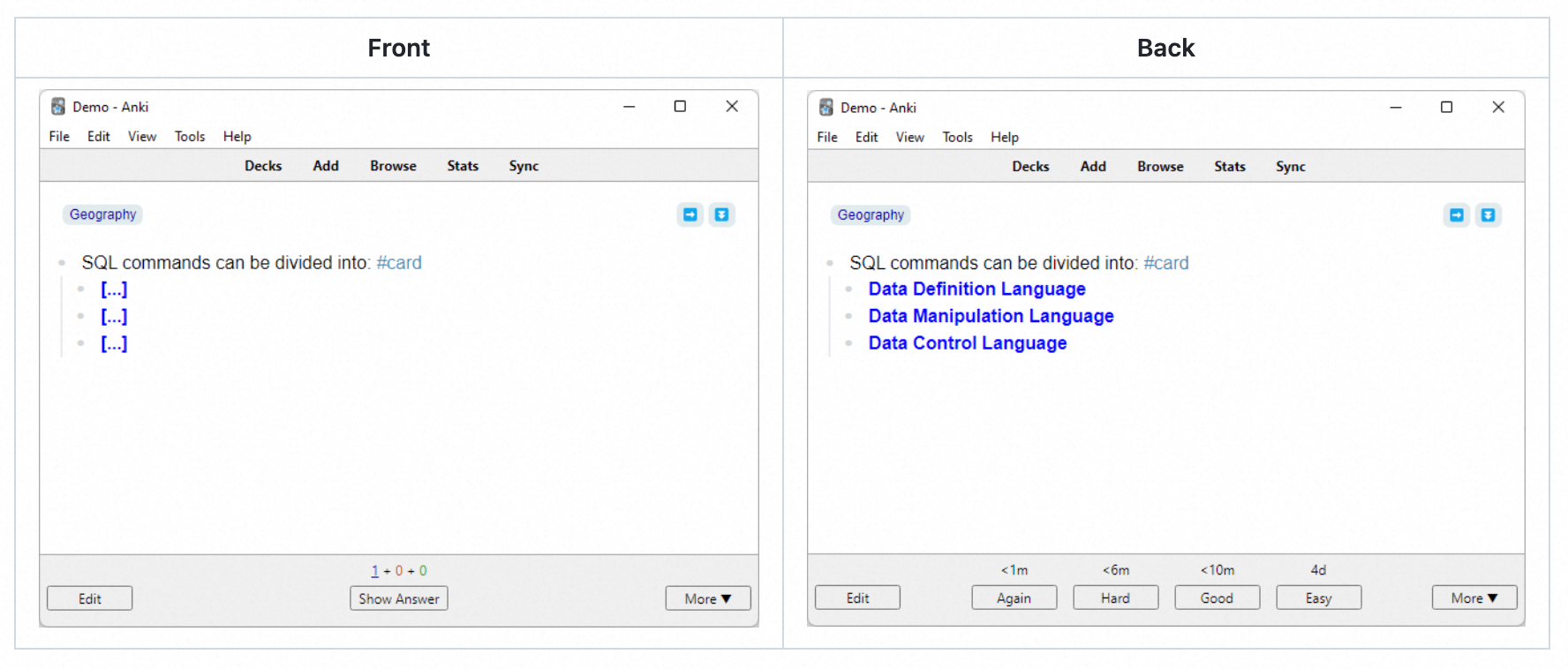

需求变更管理的过程主要包括 #card #incremental

问题分析和变更描述

变更分析和成本计算

变更实现

CCB :-> 变更控制委员会

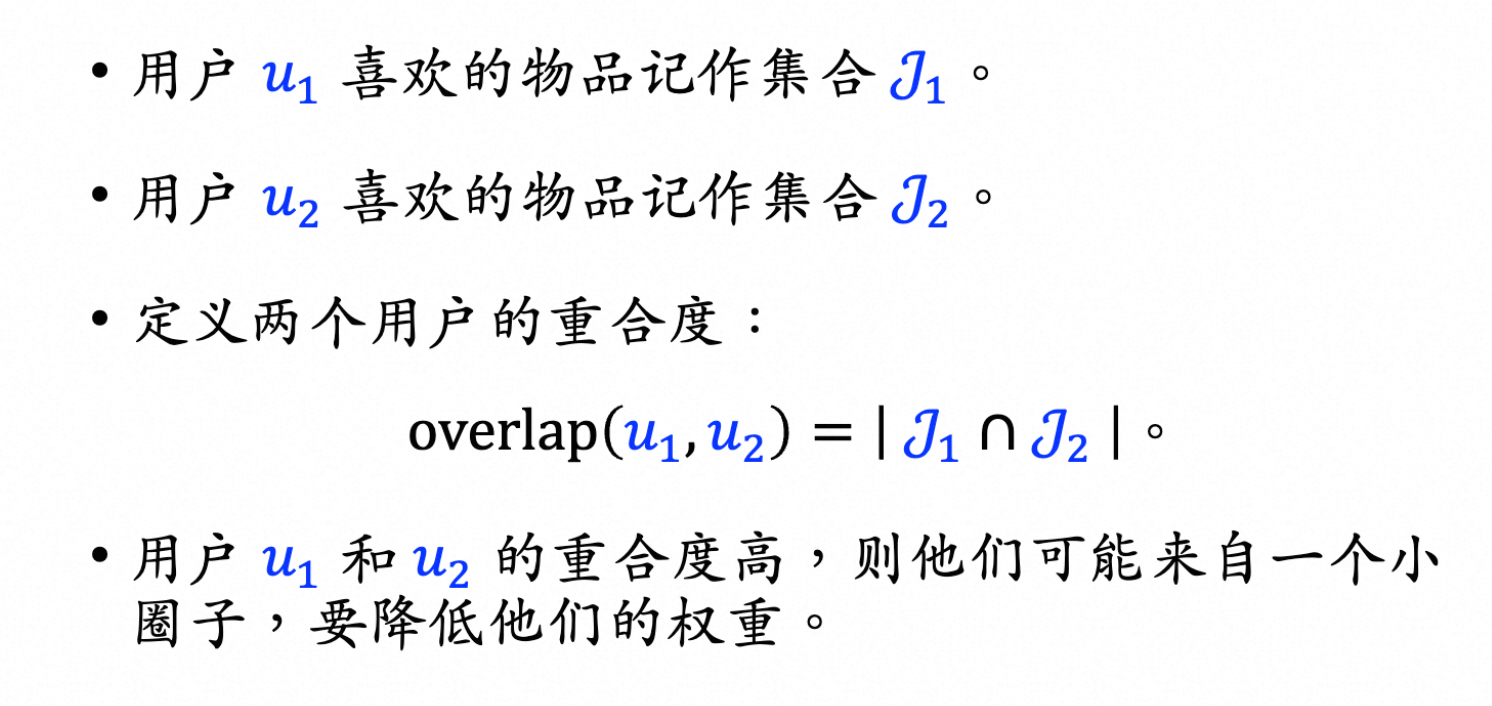

需求工程中需求管理的核心活动 #card #incremental

变更控制、

版本控制、

需求跟踪、

需求状态跟踪

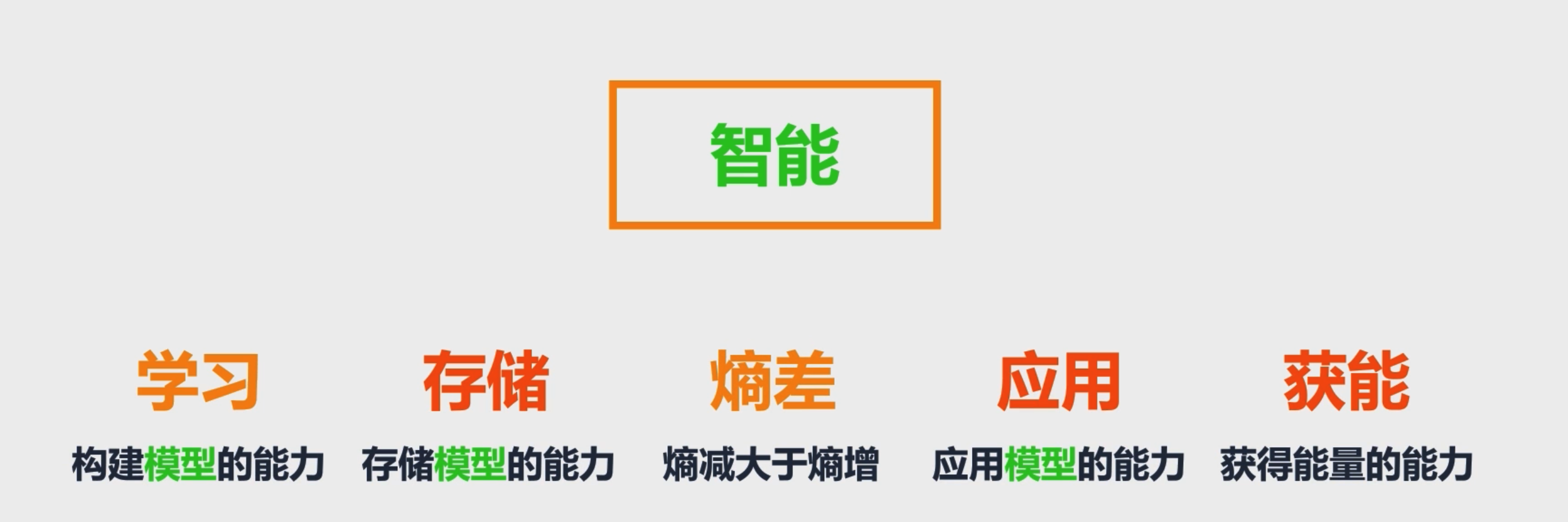

不同阶段的具体任务

需求抽取的目的是 :-> 理解利益相关者对系统的真实需求,并将这些需求清晰地记录下来。

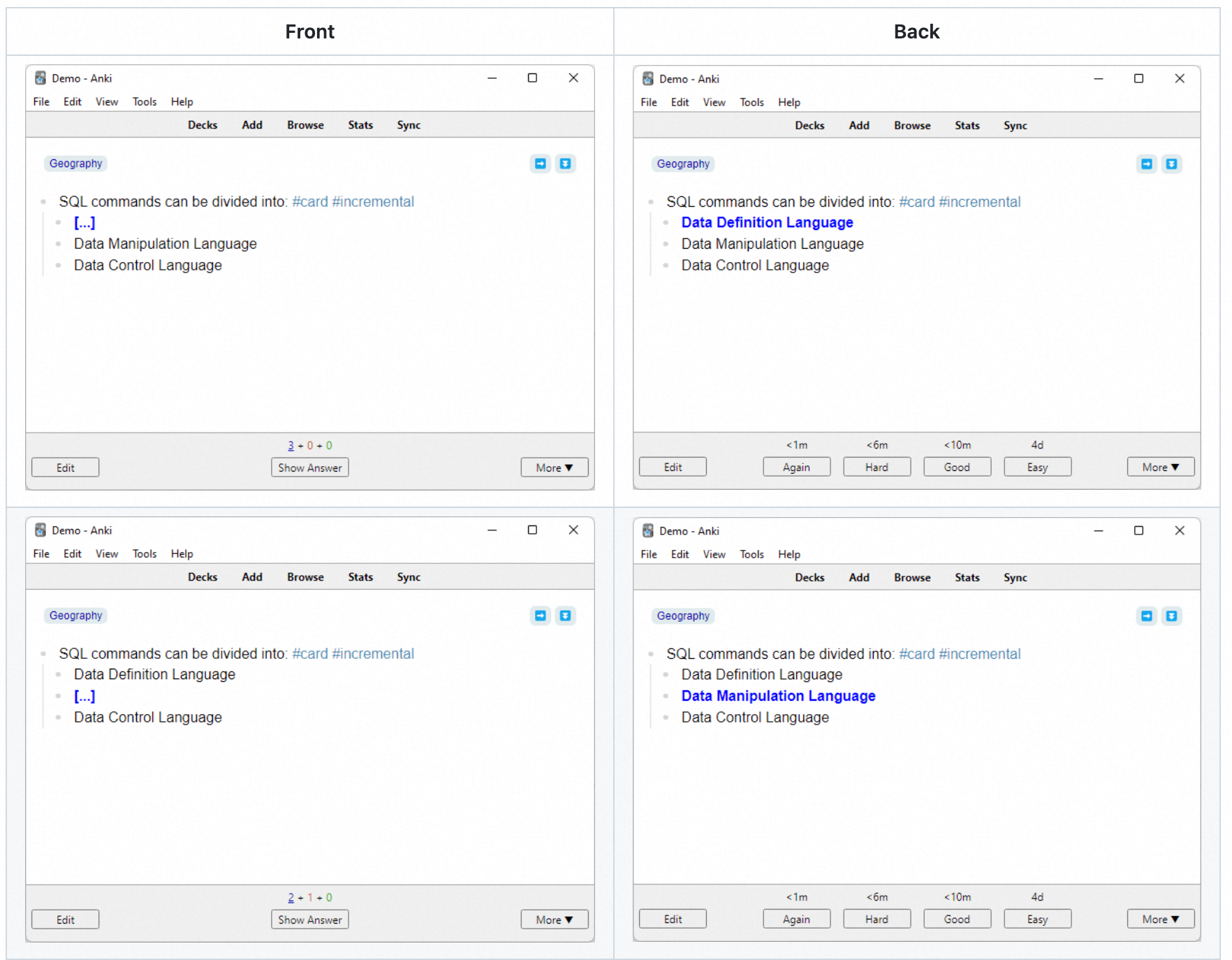

主要活动 #incremental #card

需求发现

需求分类和组织

需求协商

需求文档化

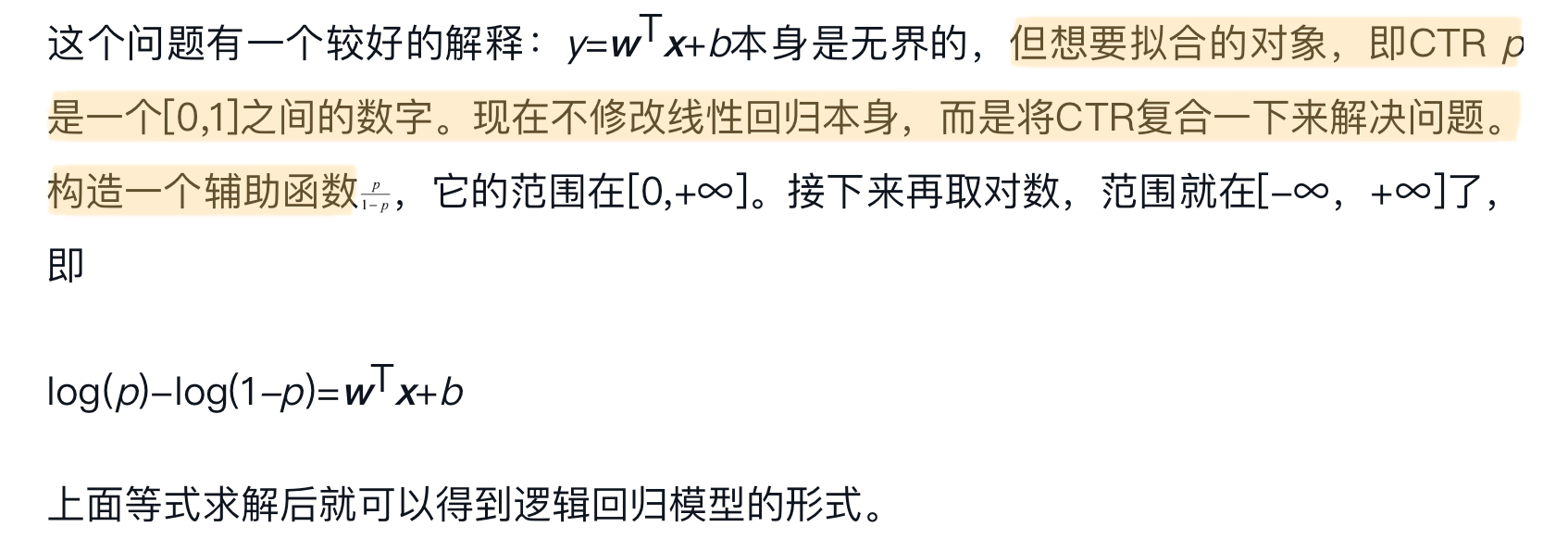

[[SASAM]] 全称 :-> Static Analysis of Software Architecture Model)是软件架构静态分析方法

取代继承 :<-> 子类继承父类的能力后,用自己的功能完全取代父类的实现,强调覆盖关系。

包含继承 :<-> 子类完整继承父类的全部特性和能力,并进一步从其他类继承了更多内容,使自身功能大于等于父类,实现了对父类的“包含”。

受限继承 :<-> 只继承父类部分能力或在继承时进行某些限制或裁剪。

特化继承 :<-> 子类对父类进行了扩展或细化,使其成为父类的“特例”,但不一定继承全部内容,更多强调概念上的子集与约束增强。

项目时间管理确实包括活动定义、活动排序、活动资源估算、活动历时估算、制定进度计划和进度控制

项目范围包括 :-> 为了交付这些产品或服务所必须完成的所有工作

主要任务 #card #incremental

体系结构设计 架构设计

接口设计

数据设计

过程设计

信息隐蔽(Information Hiding)是软件设计中重要的结构化原则,其核心思想是 :-> 将每个程序成分的内部细节限制在模块内部,不对外暴露实现细节,仅通过定义良好的接口进行交互。

主要活动 #incremental #card

软件描述

软件开发

软件有效性验证

软件进化

软件过程模型

运行期质量属性 #card

开发时期质量属性 #card

可用性 :-> 衡量系统在多长时间内能够正常运行

易用性 :-> 关注用户交互的便捷性

性能 :-> 响应时间相关

过程重用 :<-> 侧重于复用软件开发过程中形成的方法、流程、模板等,与具体软件元素(如算法、UI)无关,因此不符合题意。

横向重用 :<-> 是指在不同应用领域之间对通用软件元素(如数据结构、通用算法、人机界面组件等)进行复用。题干所列举的数据结构、分类算法、人机界面等,具有很强的通用性,广泛应用于多个不同行业与领域,因此属于横向重用,选项正确。

纵向重用 :<-> 指在同一应用领域的不同系统层级或生命周期阶段中对软件元素的重用,强调的是垂直方向的领域内复用,不符合“不同应用领域”这一条件。

交叉重用 :<-> 虽然是存在的一种重用类型,但通常用于更复杂的跨领域、跨方式的复用组合,题干并未体现这种复杂性,不适用。

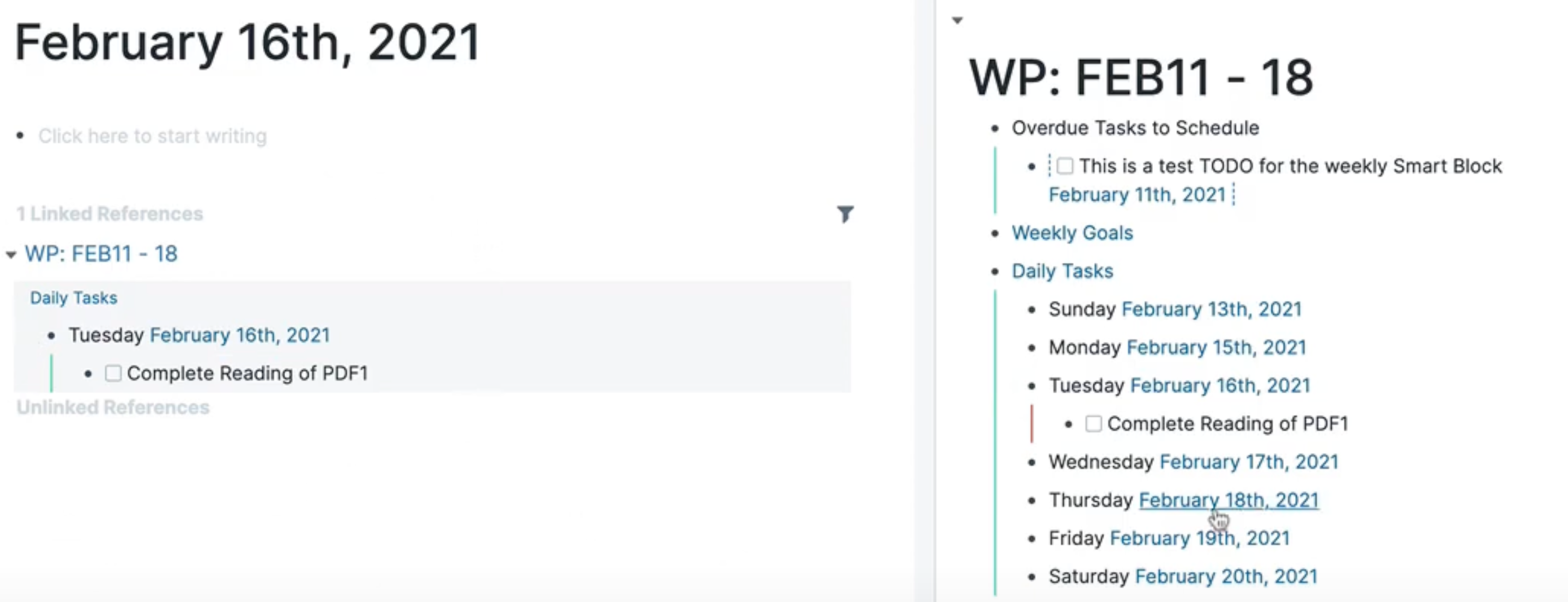

[[20250907]]

嵌入式实时操作系统 :<-> RTOS

NDB :<-> [[基于网络的数据库系统]]

[[原型模型]] :<-> Prototyping Model

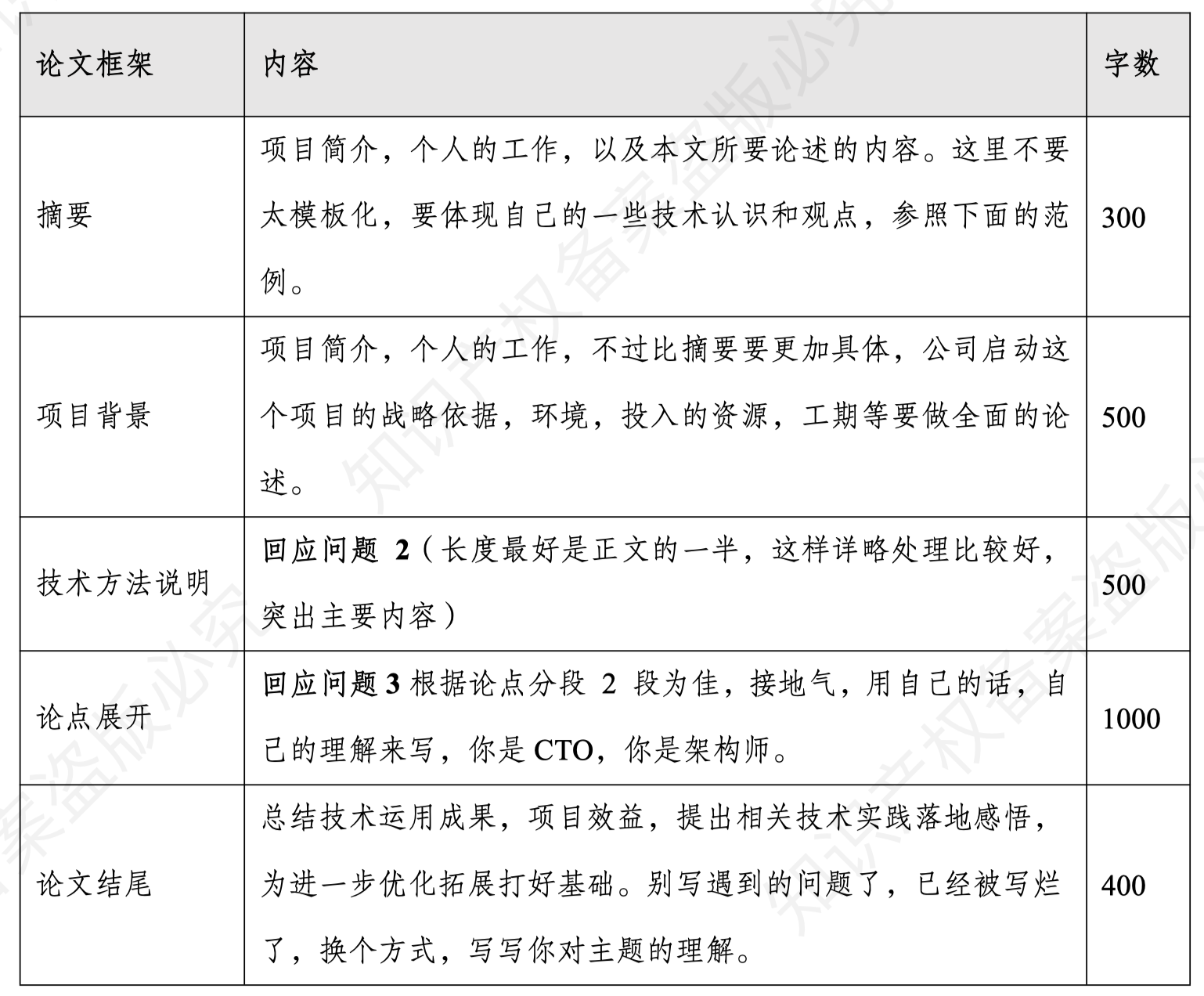

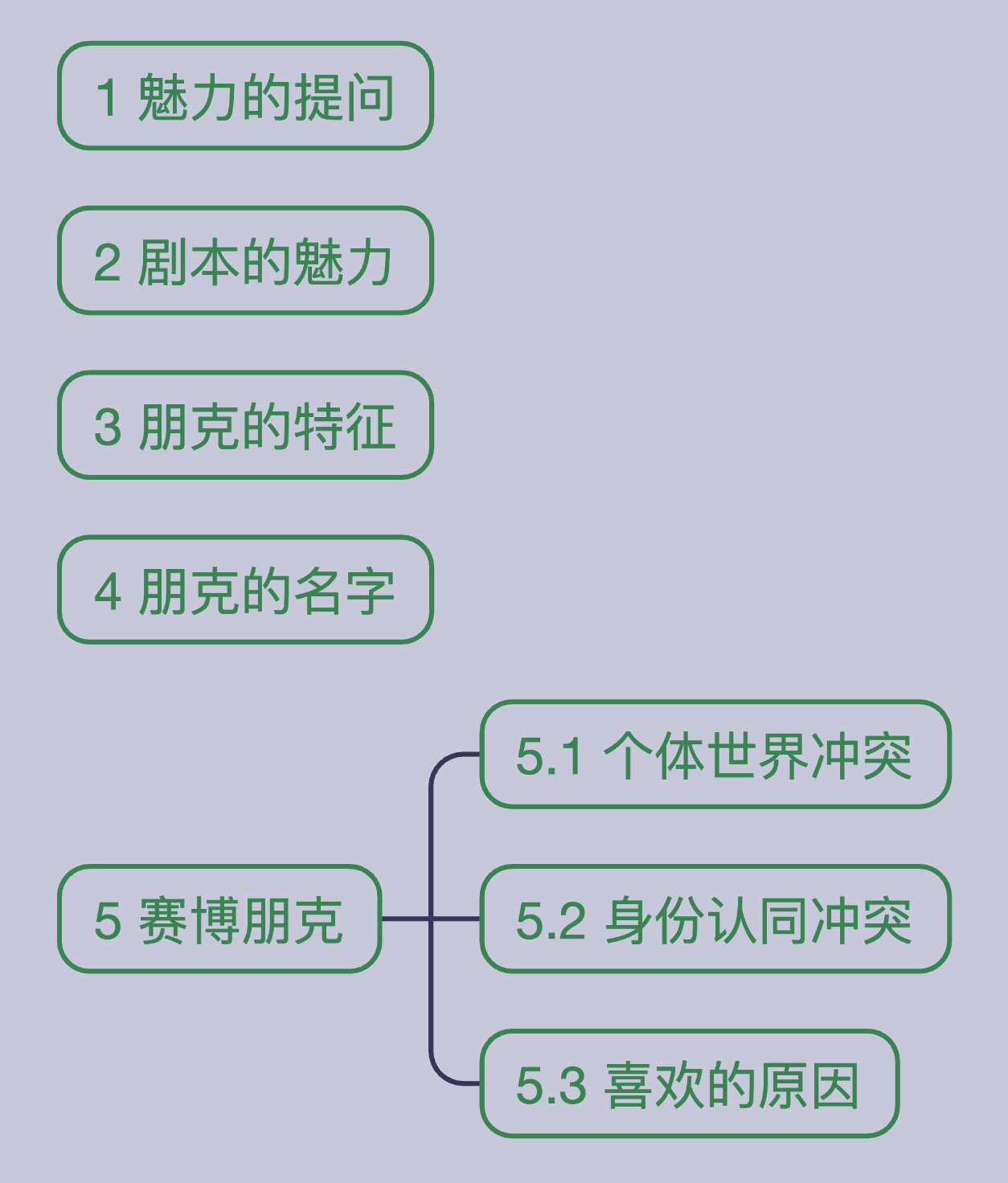

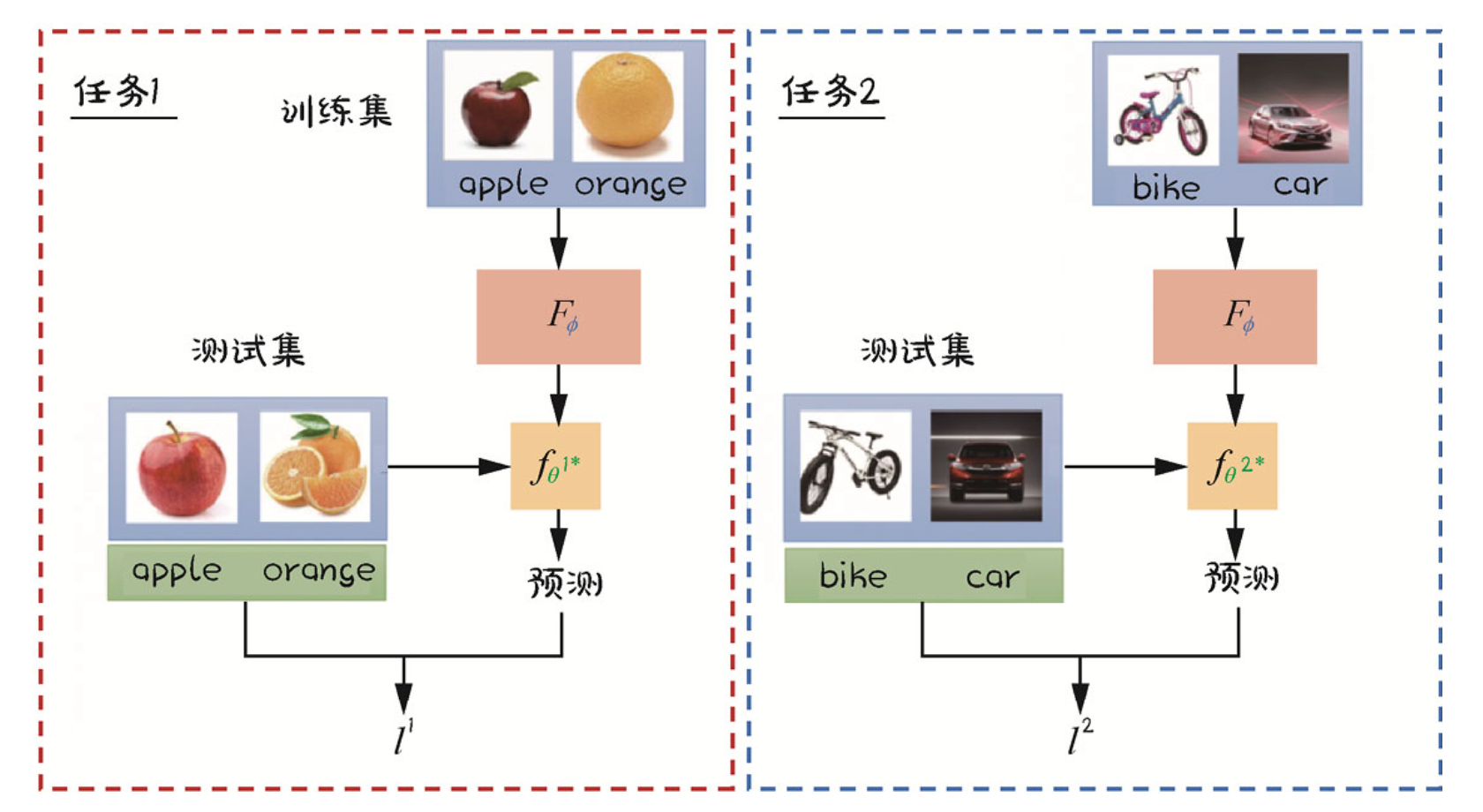

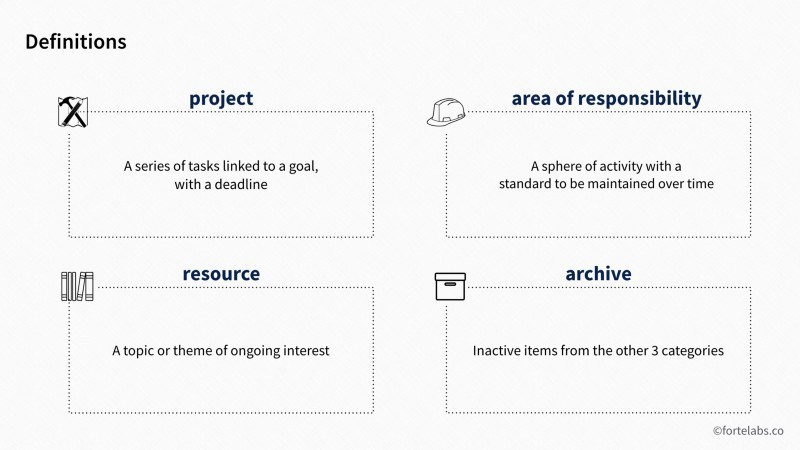

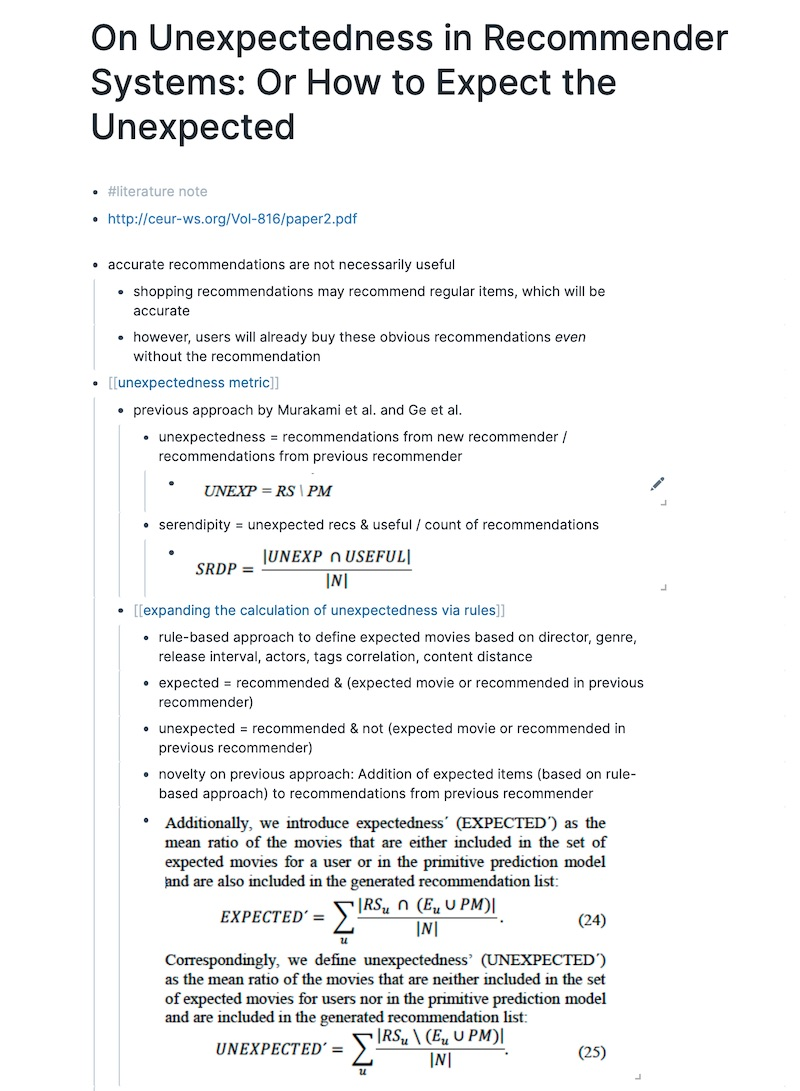

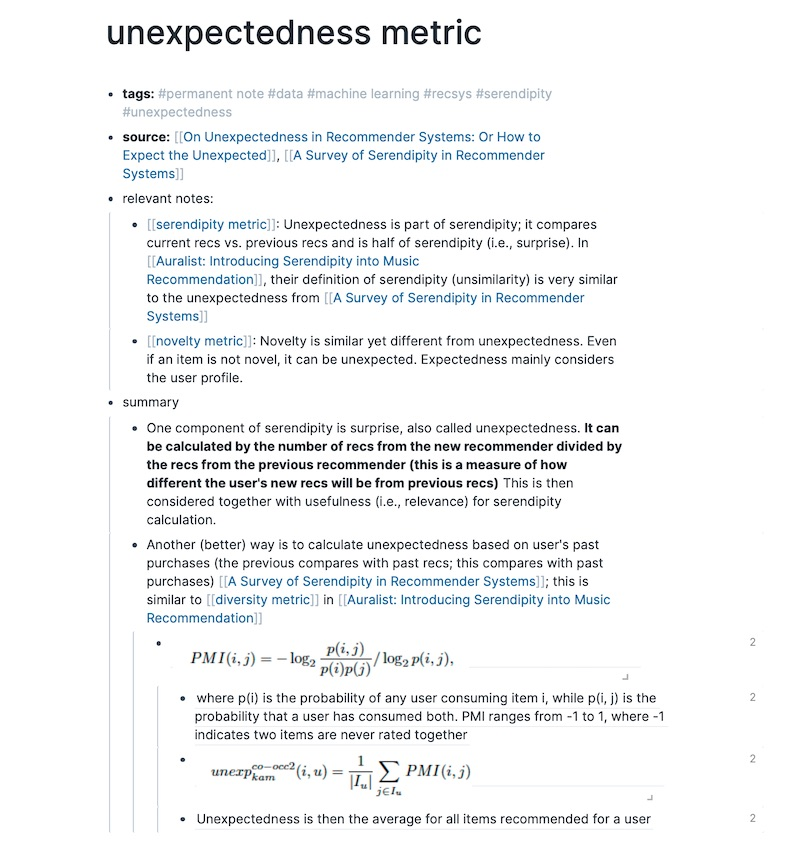

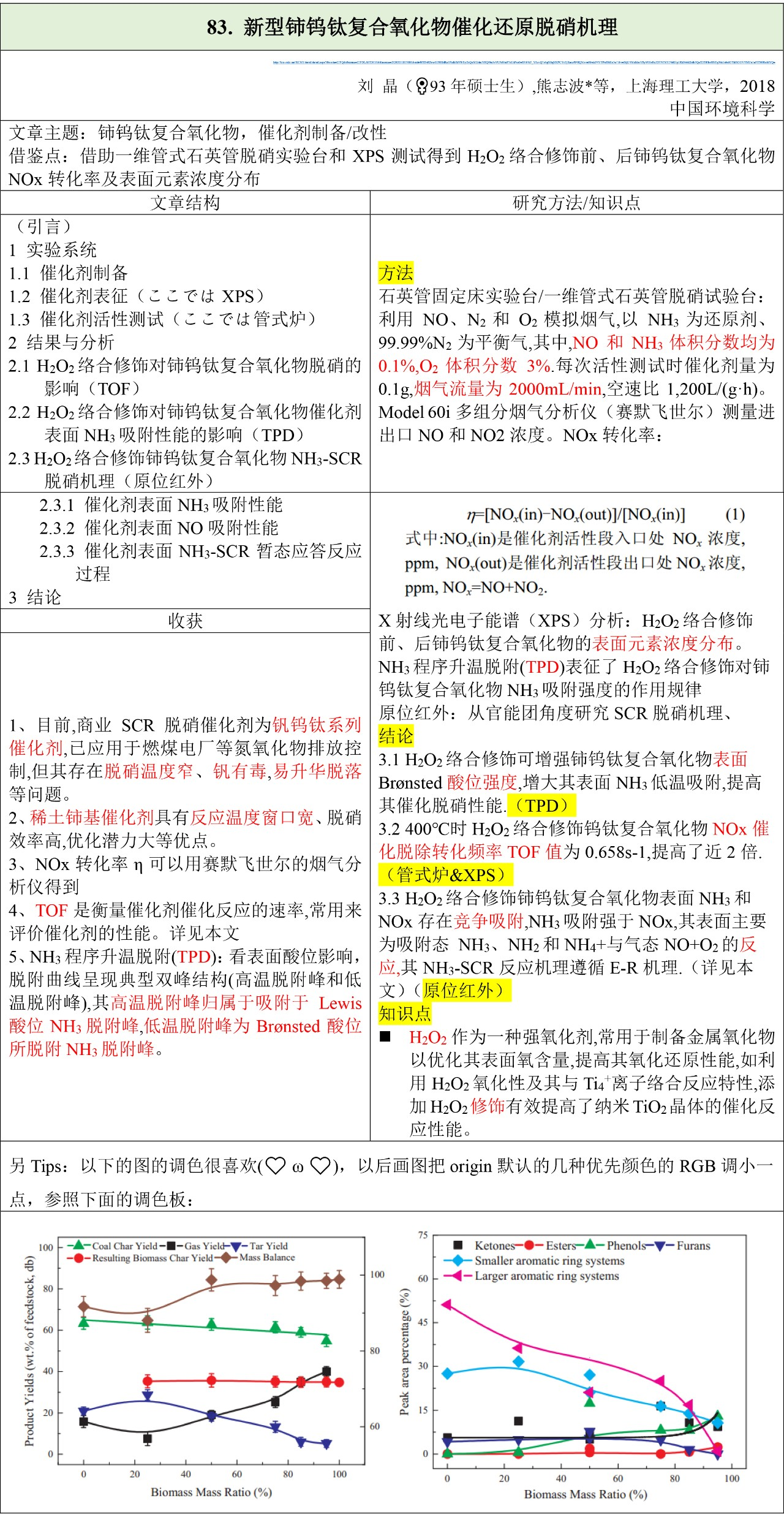

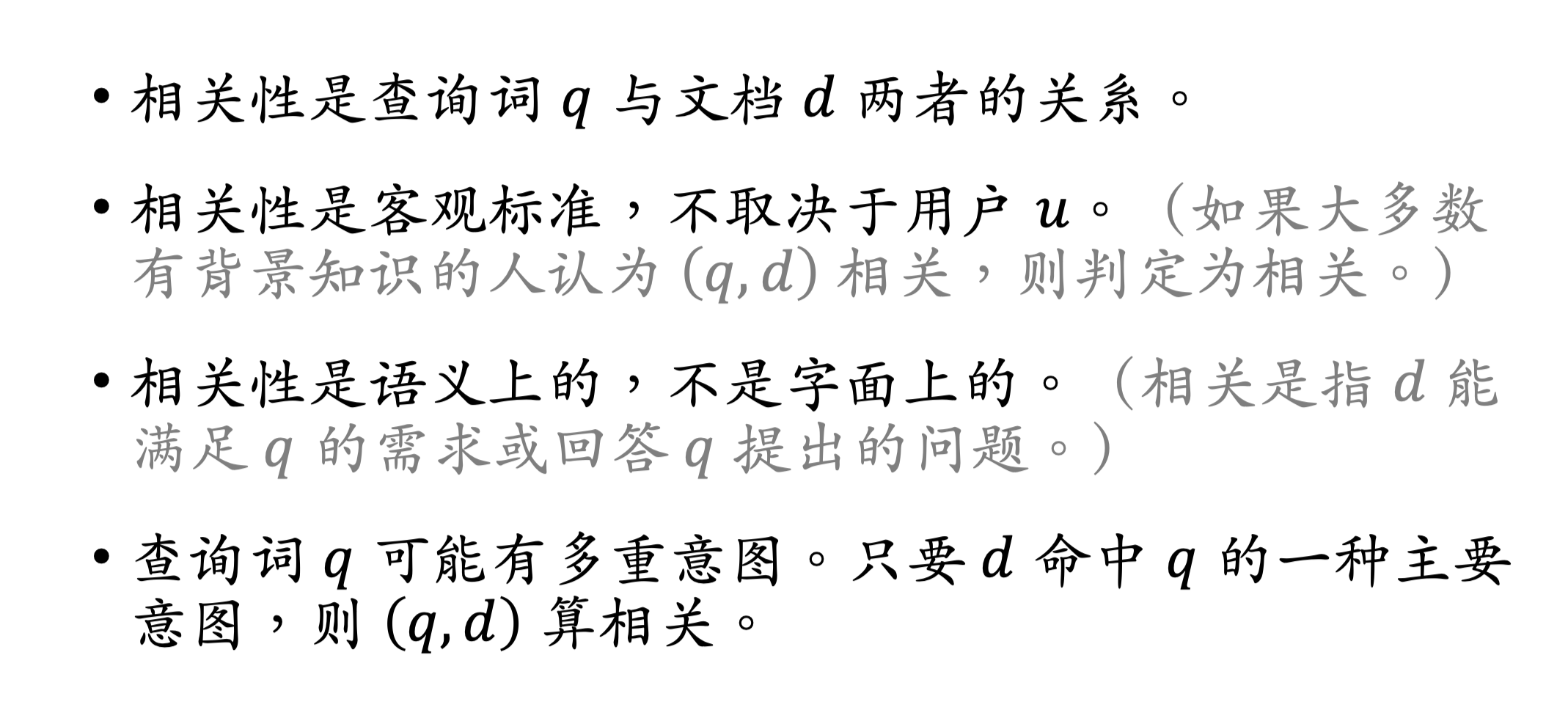

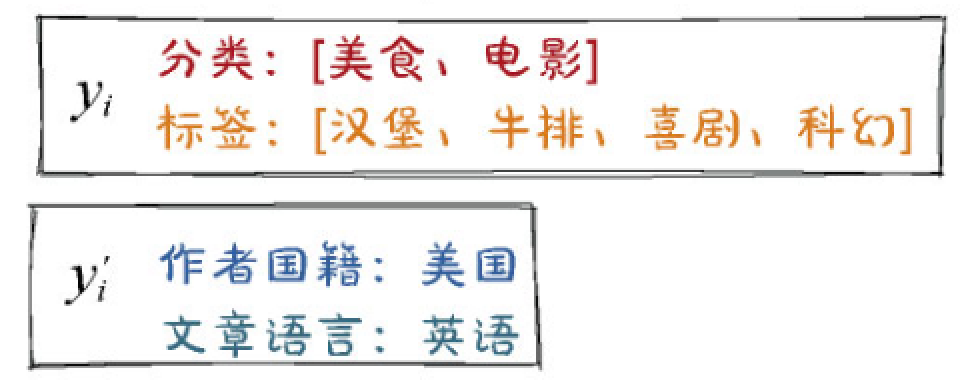

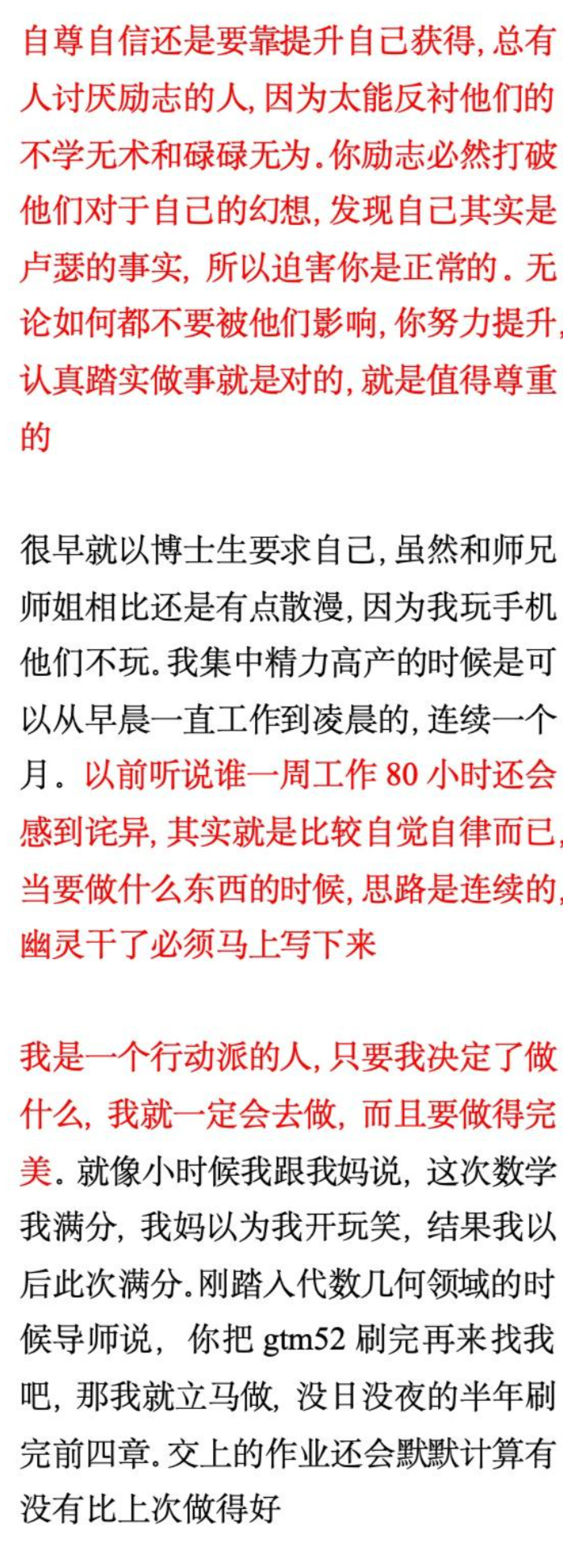

论文框架

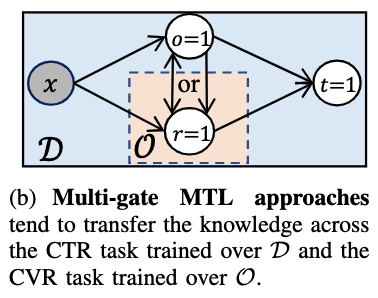

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDk3MzQzNTA0MF8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6ODQ5LjIzNDg3NjEyOTAwODYsInRvcCI6MjcwLjY4NTY1NzE3NTQ5MDg2LCJ3aWR0aCI6MTA1Mi44NzE4ODI3MjEzMzY1LCJoZWlnaHQiOjI0Mi4xMDE3Nzk2MTU3ODIyMiwiYW5nbGUiOjAsImNJZCI6MX0seyJsZWZ0Ijo4MzkuNjA1NDgzNDIwODQ5NiwidG9wIjo1MjQuMTkwNjkzOTA2OTIyNSwid2lkdGgiOjEwMjUuNTA0MjU2OTgwMTkzLCJoZWlnaHQiOjIxNC45NzA4MjQ1OTg1NjAyOCwiYW5nbGUiOjAsImNJZCI6Mn0seyJsZWZ0Ijo4MzkuNDMxNjI4MjcwMzk2NiwidG9wIjo3MzcuNjc5MzYxMjYxMjAxNCwid2lkdGgiOjEwMjUuODUxOTY3MjgxMDk5MiwiaGVpZ2h0IjoxNDcuOTAyODI4NzI0MjMzMjUsImFuZ2xlIjowLCJjSWQiOjN9LHsibGVmdCI6ODMyLjg0NzAxNjQ3NjA4LCJ0b3AiOjkxNy44NzMzNDUwMjQ5MjY3LCJ3aWR0aCI6MTAzOS4wMjExOTA4Njk3MzI0LCJoZWlnaHQiOjE0MC43NTkyMTIyNzQ4MjQzNCwiYW5nbGUiOjAsImNJZCI6NH0seyJsZWZ0Ijo4MzUuMDQyNDM3MDc3ODkyOCwidG9wIjoxMTEzLjUwODc0OTA3MDY3NDQsIndpZHRoIjoxMDI3Ljk2OTQzMzc4NjQ2OSwiaGVpZ2h0IjoyNDIuNjk3NDk4MTQxMzQ5MTIsImFuZ2xlIjowLCJjSWQiOjV9XX19

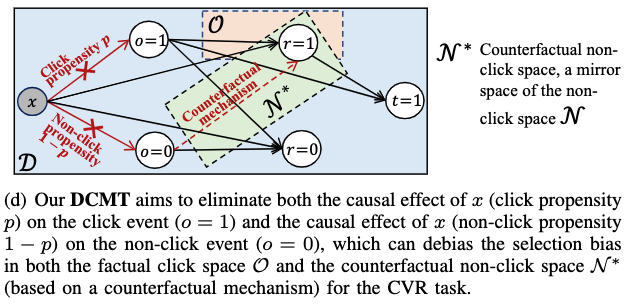

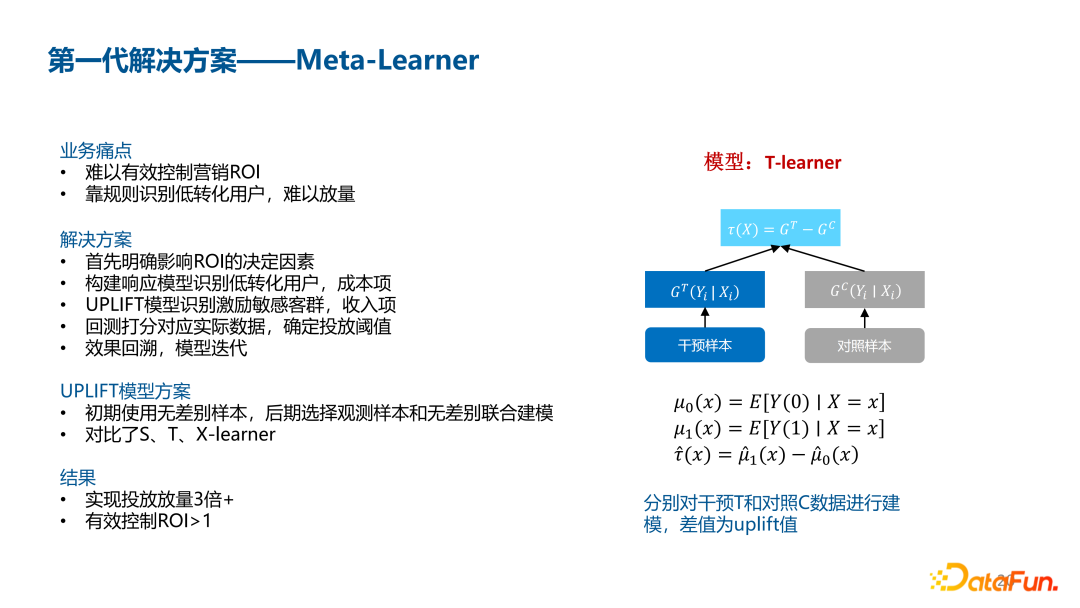

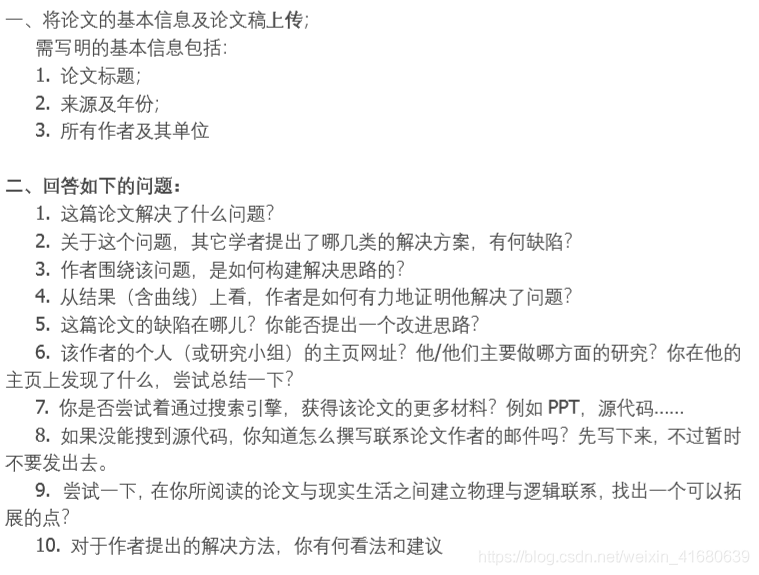

【摘要】

1交代项目背景、项目大致情况,在项目中自己是做什么的(一般是架构师)#card

我在这个项目里面,用到了哪些与题目相关的技术 #card

项目很成功,客户很开心,老板很开心,我也很开心 #card

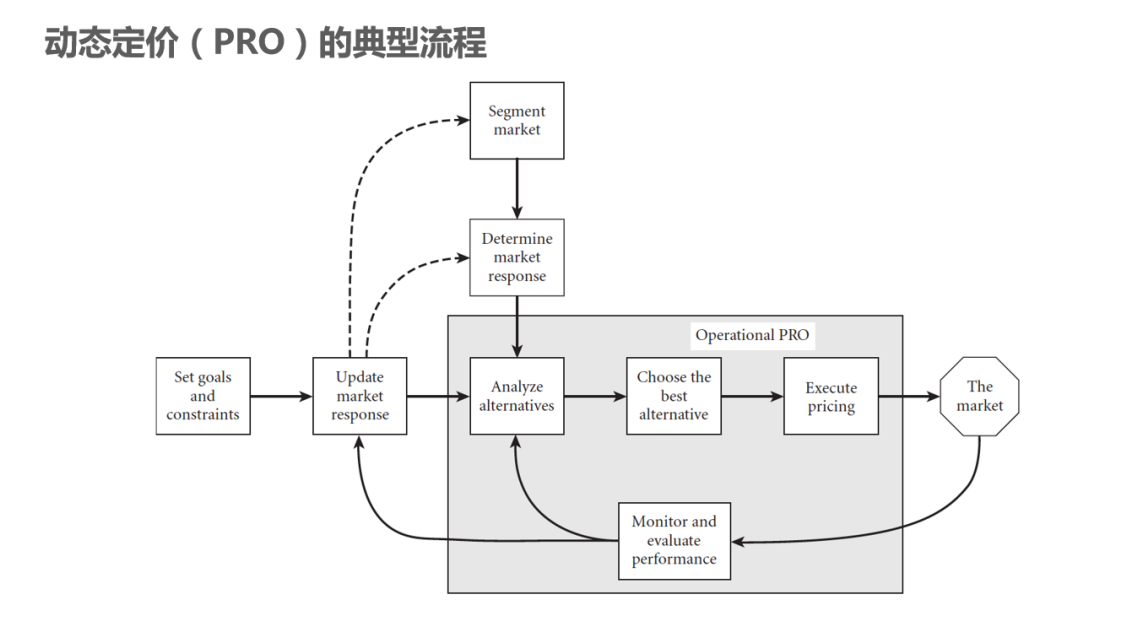

一、为什么要 xxx #card

我现在在哪里工作,职位是XX(100字左右,注意数据脱敏,不要透露完全真实的项目名称和个人、公司信息,用某某代替)

1 大势所趋

2 好处

3 不这么做的坏处

二、项目背景及现状

大趋势#card

我有幸参与了该项目的开发,并担任架构师职务,主要负责架构设计及主程序开发的工作。

我做了什么项目,业务背景和产品设计是怎么样的(300字左右,同样注意数据脱敏)

结合上述背景,该项目有以下难点:#card

1、______。

2、______。

3、______。

三、XXX 详细描述

基于上述存在的问题及现状,我们认为,平台的架构必须:#card

1、___;

2、___

3、___

说说题目里面的技术或概念是什么(作为论点,300字左右)

为了实现上述目的,经过研究和实践,我们采用了___架构,包含:、、、。#card

1 ___

2 ___

3 ___

4 ___

项目中是怎么体现题目中的技术的(作为论据,也是整片论文的主体部分,1000字左右,举2到4个例子)

四、优劣势分析及后续展望

该架构还有以下几个特点:#card

1、___;

2、___;

3、___;

项目取得了怎么样的结果,有哪些细小的可以改进的点(结论,400字左右)

不足:#card

1、___

2、___

五、结果#card

进程通信风格的构件 #card

连接件:是实现进程间通信的机制,即“消息传递(Message Passing)”。 #card

它支持进程之间通过发送和接收消息来实现数据交换与协同工作。

消息传递方式可以是同步或异步、点对点或广播,也可以是本地或远程的。

不同抽象层次 #card #incremental

实现级 :<-> 主要包括与代码直接对应的底层信息,如源代码、语句序列、数据结构

结构级 :<-> 包括反映程序各部分(如模块、子系统、类)之间相互依赖关系的信息,例如调用图、结构图等

功能级 :<-> 描述程序段的功能和功能之间的关系

领域级 :<-> 反映程序实体与业务领域概念的对应关系

逆向工程负责从 已有系统中提取高层次的抽象信息 ,而再工程则利用 这些信息对系统进行优化、修改或重构,生成新版本 。

在逆向工程中,使用用户指导下的搜索与变换方法,通常可以导出系统的哪两个层级信息 #card

实现级(Implementation level):即原始代码级别的信息,如函数、类、模块等。

结构级(Structural level):如系统组件之间的调用关系、模块划分、层次结构等架构信息。

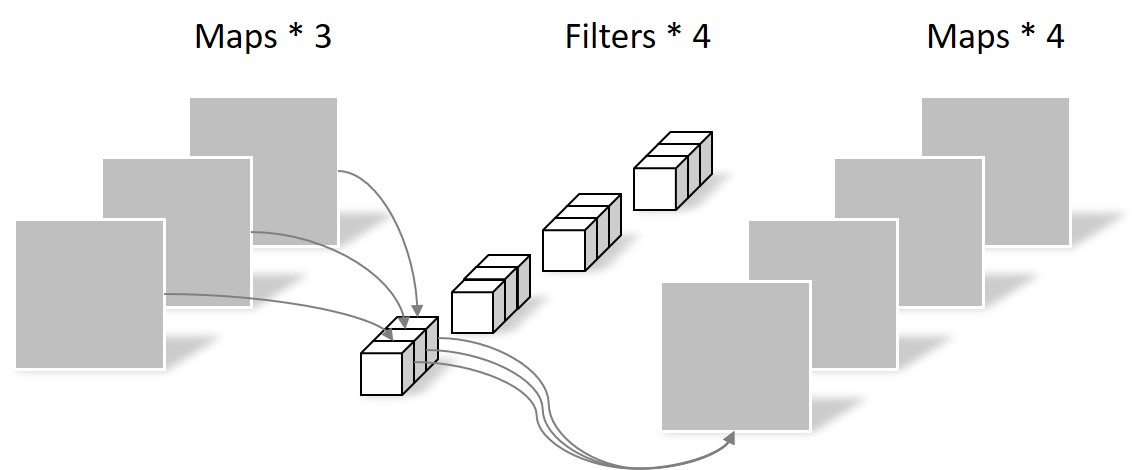

双生命周期模型指的是软件开发中复用技术所支持的两个开发生命周期 #card

组成部分

三个主要阶段 #incremental #card

软件架构设计的核心对于系统 结构 、 组件属性 及 组件间交互作用 的全面理解和描述

大多数嵌入式系统都具备实时特征,其典型架构可概括为(__)两种模型。#card

层次化模式架构:将系统按功能划分为多个层次,各层之间具有明确的依赖关系与调用关系。上层依赖下层服务,而下层对上层无感知,具有良好的可扩展性和可维护性。

递归模式架构:适用于嵌套性强、资源重复使用的系统结构,它强调组件之间的递归调用,通常用于操作系统内核、调度机制等设计中。

三个主要阶段 #incremental #card #depth-1

构造/获取可复用的软件资产 #card

管理可复用资产 #card

使用可复用资产 #card

复用包括 #incremental #card

软件概要设计将软件需求转化为软件设计的 数据结构 和软件的 系统结构 。

其核心任务是 #incremental #card

定义模块的结构、层次、功能

模块之间的接口和数据流向。

软件概要设计包括设计软件的结构、确定系统功能模块及其相互关系,主要采用描述程序的结构。#incremental #card

自底向上开发方法 :<-> 是根据系统功能要求,从具体的器件、逻辑部件或者相似系统开始,通过对其进行相互连接、修改和扩大,构成所要求的系统。

原型开发方法 :<-> 通过快速构建原型验证需求

螺旋模型 :<-> 把整个软件开发流程分成多个阶段, 每一个阶段都由目标设定、风险分析、开发和有效性验证以及评审构成。

软件测试技术是一种动态验证方法,主要通过 实际运行软件并观察输出结果 来发现问题,覆盖面广、实施灵活,适合各类开发场景。

测试包括单元测试、集成测试、系统测试等,支持自动化。

其缺点是无法穷尽所有路径、不能完全保证程序无错。

软件开发工具

软件维护工具

编码与排错工具

软件管理和软件支持工具

风险点:指 :-> 可能引发系统问题或导致质量目标无法实现的设计因素。

非风险点 :-> 指在当前条件下可接受且不会引发潜在问题的设计

敏感点是指 :-> 某个或某些构件的特性对某一质量属性的表现有显著影响,一旦该特性发生改变,质量属性的表现会有明显变化。

权衡点是指 :-> 影响多个质量属性的特性,并且这些质量属性之间可能存在冲突

“改变业务数据编码方式会对系统的性能和安全性产生影响”是对(问题1)的描述,#card

“假设用户请求的频率为每秒1个,业务处理时间小于30毫秒,则将请求响应时间设定为1秒钟是可以接受的”是对(问题2)的描述。#card

可用性度量指标 [[可靠性计算]]

可测试性度量指标

软件系统架构是关于 结构 、 行为 和 属性 的抽象

在描述阶段,主要描述直接构成系统的抽象组件以及各个组件之间的连接规则,特别是相对细致地描述组件的 交互关系 。

在实现阶段,这些抽象组件被细化为实际的组件,比如具体类或者对象。

软件系统架构不仅指定了软件系统的组织和 **拓扑 ** 结构,而且显示了系统需求和组件之间的对应关系,包括设计决策的基本方法和基本原理。

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDI4NDIzNDAwNl8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6NDc0Ljk5MjM0ODA1NDM5LCJ0b3AiOjI2MC4wOTMxOTU2NzU1NzA0LCJ3aWR0aCI6NDU4LjczNjQ2Mjg1NzMwNjQsImhlaWdodCI6MTcwLjUyMDIxMTE1ODcyMzU4LCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjk4My42MzIwMjk2MjY4NDY1LCJ0b3AiOjI2OC43MTE3MjMzMzM2OTE5LCJ3aWR0aCI6NTAwLjg4Mjc1NzU1NzIxMTEsImhlaWdodCI6MTU5Ljk0NzA3MTcwODY1OTIsImFuZ2xlIjowLCJjSWQiOjJ9LHsibGVmdCI6MTUxNS4wOTUxMTA5NDE5MDIsInRvcCI6MjY2LjQyOTI3OTgwOTM5Miwid2lkdGgiOjUwNC4wNDUzMDcyMjM3NzI0LCJoZWlnaHQiOjE2NC41MTE5NTg3NTcyNTg4NywiYW5nbGUiOjAsImNJZCI6M31dfX0=

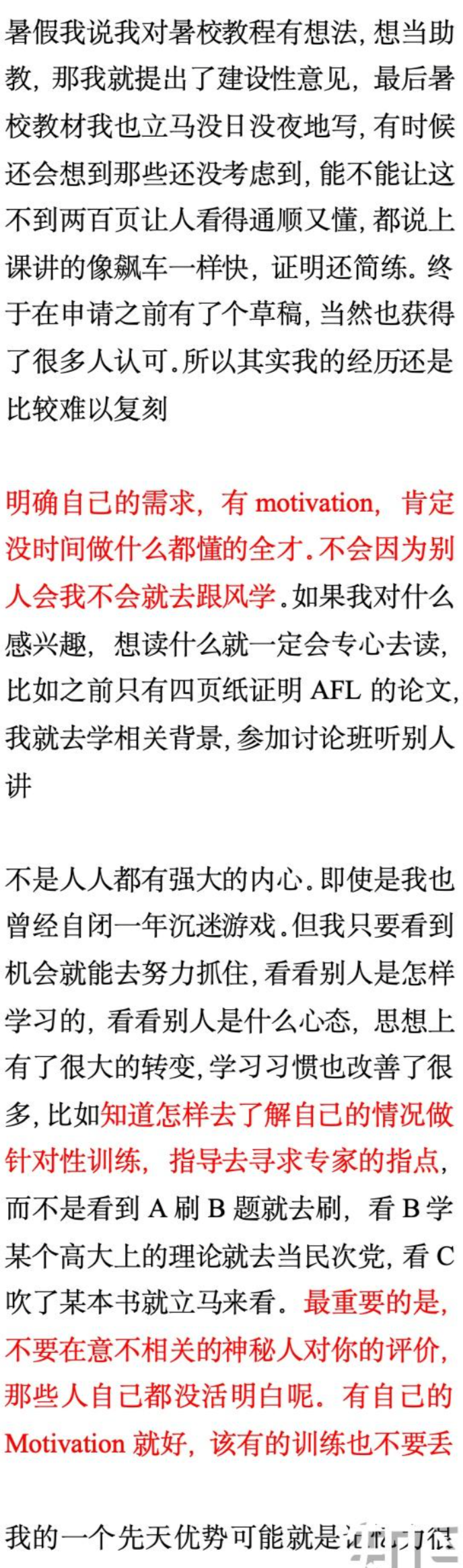

摘要

我所在的单位是国内某互联网科技公司,2021年,我司决定开发一站式数据研发平台,我荣幸的担任本次系统开发的系统架构师,主要负责整个系统架构设计工作。该系统既要满足于数据仓库建设和管理,又要满足于数据处理和数据分析、数据挖掘、数据可视化、实时数据流计算等工作。本文以一站式数据研发平台的建设为例,先介绍几种常见的软件开发模型的特点及其适用场景,然后介绍选择螺旋模型作为软件开发模型的原因,并且详细介绍螺旋模型在本项目中各阶段所做的工作。实践证明,这种软件开发模型的选择降低了复杂项目的开发成本和项目风险,显著提高看团队的开发效率。目前系统已经成功运行了一年多,为公司带来了巨大的业务价值。

2021年3月,我荣幸的担任我司一站式数据研发平台的系统架构师,主要负责该项目的需求分析和整个系统架构设计工作。该系统主要用于公司的大数据研发的工作,为公司的业务系统、决策支持系统以及算法模型提供高质量的数据支撑,其主要功能包括数据仓库建设和管理、数据处理和数据分析平台、数据挖掘、数据可视化、实时数据流计算等。本文以一站式数据研发平台为例,介绍项目的软件开发模型的选择及运用。在介绍之前,先介绍一下主流的软件开发模型。

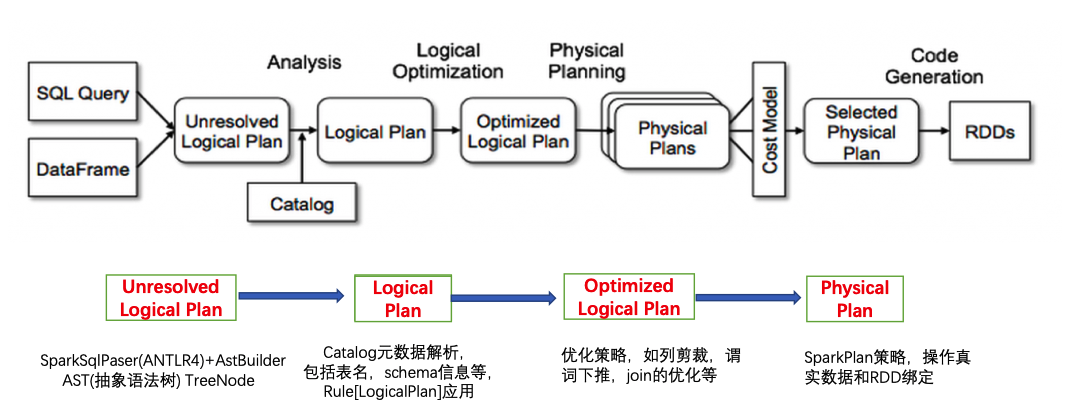

当前主流的软件开发模型有,瀑布模型、演化模型、螺旋模型、V模型、敏捷开发模型等。瀑布模型是一种严格按照软件生命周期的固定顺序进行软件开发的模型,上一个阶段完成了才能进入下一个阶段,瀑布模型适用于需求明确且很少有变更的项目。演化模型是先开发一个较小的需求原型,然后逐步演化成最终的软件产品。演化模型适用于需求不是很明确的项目,且项目的完善周期较长。螺旋模型是软件工程中一种迭代式和循序渐进的开发模型,它结合了瀑布模型的线性流程和原型模型的灵活性,通过不断迭代的方式逐步完善软件系统,并且在软件生命周期中加入了风险分析,适用于项目规格庞大、复杂以及高风险的项目。V模型,V模型区别于其他模型是将测试过程提前了,便于在开发的过程中测试发现问题,使得开发过程更加可控和可预测,尽早发现问题并解决问题。V模型适用于需要高质量和高可靠性的项目。敏捷方法是一种以人为核心、迭代、循序渐进的开发方法,适用于小规模软件和小团队开发。由于本项目的功能需求众多且需求相对明确,项目比较复杂且项目的规模较大,并且存在系统风险、数据风险、权限风险等,故选择螺旋模型作为软件开发模型。

螺旋模型的基本原理是通过多个迭代的循环来开发软件系统,每个迭代周期包括四个主要阶段:1、目标设定:确定项目目标、约束条件和风险,制定开发计划。在这个阶段,定义关键需求、资源分配和开发时间表。2、风险分析:评估和分析项目中可能出现的风险和问题。在这个阶段,识别潜在的问题,进行风险管理和可行性分析。3、开发和有效性验证:在这个阶段,进行软件系统的设计、编码和测试。采用迭代的方式,每个迭代周期内集中于某个特定的功能或模块,并进行详细设计、编码和单元测试。4、评审:在每个迭代周期结束后,进行评估和回顾。包括对软件系统的功能、质量、进度和成本进行评估,并确定下一个迭代周期的计划。以下为螺旋模型的四个阶段在项目中的运用。

目标设定,在目标设定阶段,需要获取到公司对于数据研发的需求并确定目标,通过和数据研发同事及领导们的充分沟通,明确项目的目标及风险,将需求按照功能模块和优先级进行划分,制定完善的开发计划以及迭代周期。由于项目中的各个功能模块相对独立,在架构风格选择上选择独立构件的架构风格,将一站式数据研发平台分为以下几个子模块,每个模块对应一个构件,分别是数仓管理模块、ETL模块(数据抽取加载转换模块)、数据研发模块、大数据流计算模块、数据可视化模块。数仓管理模块主要是对各种不同形式的数据以及权限进行管理,包括结构化数据存储的Hive表、HBASE表等,以及文件服务器中的二进制文件进行管理等。ETL模块主要是将不同数据来源的数据同步到数据仓库中,支持MySQL、Oracle、mongoDB等主流的数据库的数据同步。数据研发模块主要是使用HiveSQL对数据表的相关操作,包括数据清洗、数据分析、数据挖掘等。大数据流计算模块是以Flink为流计算引擎开发的流计算模块。数据可视化模块是以开源的DataEase框架搭建的企业数据可视化平台。

风险分析,在风险分析阶段,主要是对系统可能存在的风险进行分析,其中包括系统风险分析、物理资源风险分析、数据安全分析、权限安全分析。系统风险分析是分析系统可能存在的安全漏洞,例如依赖了含有安全隐患的jar包、SQL注入攻击等。物理资源风险分析是对物理服务器进行评估分析,由于数据研发平台是需要海量的存储资源和计算资源的平台,公司现有服务器资源是否能够支撑起平台的建设和运行。数据安全分析是为了防止数据泄露、数据篡改、数据一致性、敏感数据数据脱敏等安全风险分析。权限安全分析是对数据进行访问控制,公司机密数据/用户敏感数据只针对有权限的人开放,数据使用方需要申请数据表权限并且会对其进行数据查看审计,避免出现数据泄露以及侵犯用户数据隐私的情况。

开发和有效性验证,在开发和有效性验证阶段进行系统的设计、编码和测试。由于系统的各个模块相对独立,因此在开发过程中采用多个小组每个小组3-5人并行开发的方式,以模块为维度建立螺旋模型开发,即单个模块为一整个螺旋模型开发模式,开发小组仅对当前负责的模块内的功能进行详细的设计和开发,提高开发效率的同时,也降低了协作开发带来的风险,这种开发模式在整个项目的推进过程中取得了非常不错的效果。同时,软件测试也是不可忽略的一环,我们在测试环节也做了充分的工作,在开发过程中需要写单元测试进行代码行覆盖和代码分支覆盖,在单元测试和集成测试通过率都为100%才交付给质量同学进行功能测试。除此之外功能上线后还会对功能进行压力测试和性能测试等。

评审,在评审阶段,每个模块的迭代周期结束后,项目经理、产品经理以及开发、质量会对整个迭代周期进行评估和回顾以及整个项目的功能、项目进度、项目成本进行评估。以及确定下一个迭代周期的计划等。

整个项目耗时1年完成,于2022年3月投入生产,稳定运行至今,实践证明,这种软件开发模型的选择降低了复杂项目的开发成本和项目风险,显著提高看团队的开发效率。该系统获得了数据研发、算法同事的一致好评,并且基于业务增长的数据可视化报表等数据和以数据支撑的决策支持系统为公司高管的企业决策起到了关键的作用。但同时系统也存在一定的不足。例如在数据研发阶段,有大量的定时数据任务产生数据报表等,这些数据任务比较耗费计算资源,偶尔会发生大的数据任务占用资源导致其他数据任务因获取不到资源延迟执行或者机器宕机的情况,因此需要对数据任务的资源占用进行约束,并且实现资源弹性扩缩容,减少此类情况的发生。

Mediator :<-> 中介者

Adapter :<-> 适配器

Bridge :<-> 桥接

Decorator :<-> 装饰模式

Facade :<-> 外观模式

Flyweight :<-> 享元

Proxy :<-> 代理模式

Memento :<-> 备忘录模式

Observer :<-> 观察者模式

Builder :<-> 建造者

质量属性场景是一种结构化的描述方式

清晰地界定了一个质量属性在什么环境下、在什么刺激下、对哪个系统或构件、会做出怎样的 响应 ,以及如何对这个响应进行 度量 ,是精确描述质量属性的标准手段

六个组成部分 #card #incremental

刺激源

刺激

环境

制品

响应

响应度量

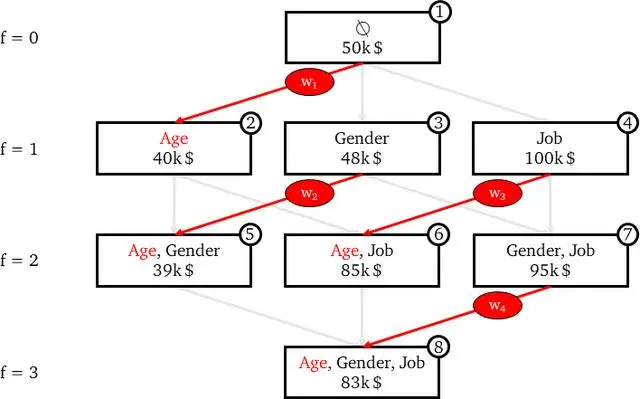

效用树是软件架构评估方法(如ATAM)中用于 识别和优先排序质量属性场景 的工具。

效用树沿着两个维度进行优先顺序:#card

每个场景对系统成功的重要性

对此场景实现(从架构师的角度来看)所带来的难易程度的估计

某广告公司的宣传产品有宣传册、文章、传单等多种形式,宣传产品的出版方式包括纸质方式、CD、DVD、在线发布等。现要求为该广告公司设计一个管理这些宣传产品的应用,

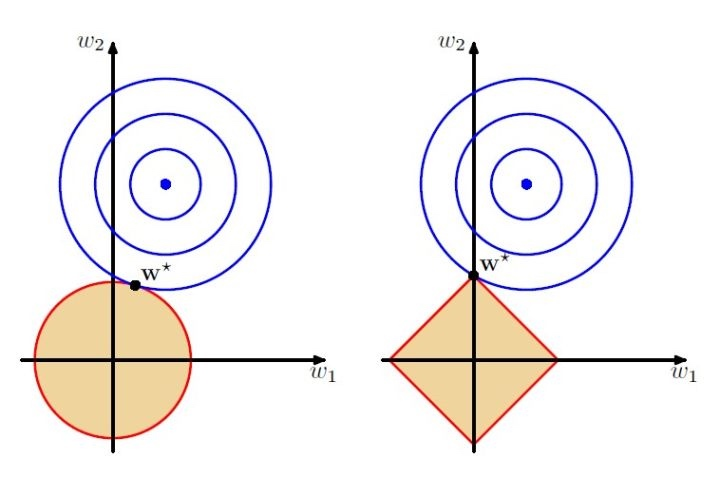

桥接模式(Bridge) 的核心思想是将抽象部分与它的实现部分分离,使它们可以独立地变化。

在这个问题中,宣传品的形式(如宣传册、文章等)和发布方式(如纸质、CD、DVD、在线等)是两个变化的维度。

桥接模式能够很好地将这两个维度分离,使得它们可以独立变化。

调用/返回风格 :-> 通过模块之间的调用关系组织系统 #card

主程序-子程序(如传统结构化程序设计)

面向对象(对象间方法调用)

层次结构(如 OSI 七层协议栈)

客户端-服务器(Client/Server 模式)

以数据为中心风格:以数据结构为核心,多个模块围绕数据协作。主要包括:#card

[[仓库风格]](Repository)

黑板(Blackboard)

数据流风格:#card

虚拟机风格:#card

独立构件风格

包括 事件驱动系统、进程通信 等。

批处理风格

每个处理步骤是一个单独的程序,每一步必须在前一步结束后才能开始,并且数据必须是完整的,以 整体 的方式传递

基于规则的系统包括规则集、规则解释器、规则/数据选择器及 解释引擎

**环路数 ** 可以反映 :-> 原代码结构的复杂度。

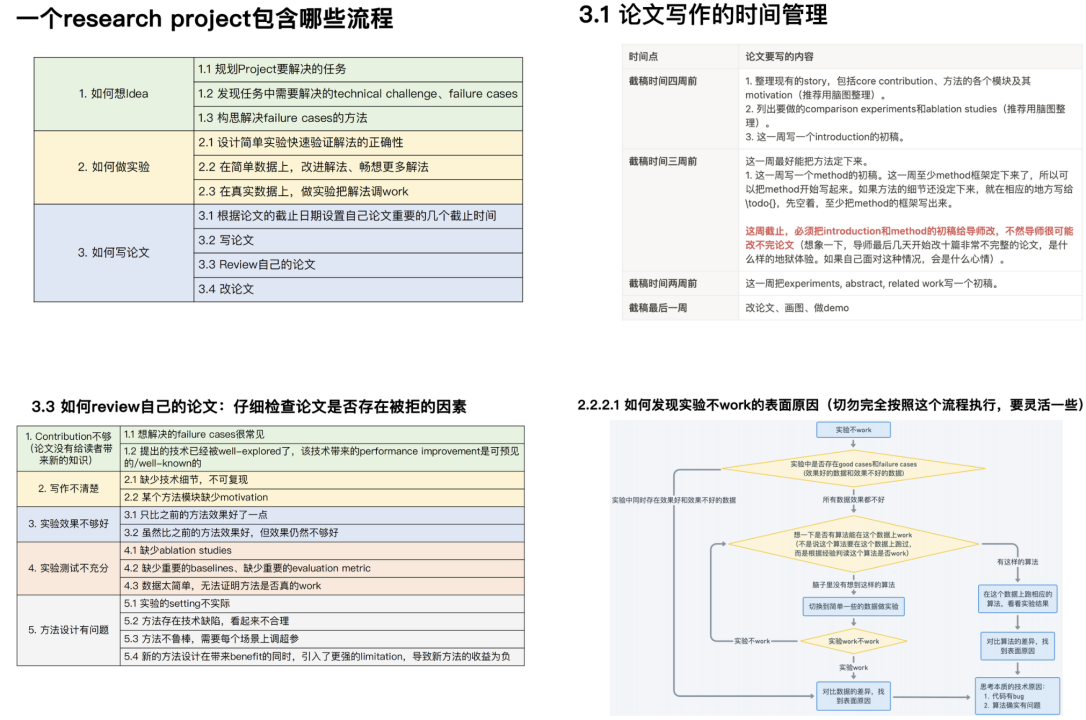

三层分层模型

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDE0MjcwMzAxNF8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MzczLjk1MDQxODkxOTg3MTE0LCJ0b3AiOjQxMy4wMzM4OTUyNDY1NDg0LCJ3aWR0aCI6MjU5Ljc0NDMzNjY1OTY0NzgsImhlaWdodCI6NDQ4LjUzMzM3NTQzNzY4NjYzLCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjY5NS43MTQxNzE4ODY4MjE1LCJ0b3AiOjQxNS41ODI5OTY1OTcyODgyMywid2lkdGgiOjMyOS40ODc3OTY3MzU5MTQsImhlaWdodCI6MzU2LjgyOTI5ODIxODA3NTEsImFuZ2xlIjowLCJjSWQiOjJ9LHsibGVmdCI6OTk5LjM5MTQwMzExMTczNTQsInRvcCI6NDI2LjIzNzk3MjQ2NjE1OTcsIndpZHRoIjoxNjguNzYwOTQ4NTE2NzUxOCwiaGVpZ2h0IjoxMTUuNjczNjY1MDExMjI4NiwiYW5nbGUiOjAsImNJZCI6M30seyJsZWZ0IjoxMjE2LjM4MzUzNDMzNzMxNjksInRvcCI6NDE3LjcwNDY1MzY5MjQ0MzQ2LCJ3aWR0aCI6MTY4LjA3MjEzMjcwNzI3OTI1LCJoZWlnaHQiOjE0Ni4wNjQyODMyNTM3NTgyOCwiYW5nbGUiOjAsImNJZCI6NH1dfX0=

逻辑设计产出 #card

逻辑网络设计图

ip地址方案

软硬件、广域网连接和基本服务

网络设计产出 #card

设备清单

布线方案

安装日程

测试计划

用户培训计划

浏览器访问 Web 页面时, #card #incremental

会先进行域名解析(查询本机缓存或向 DNS 服务器请求),

接着在本地网络中可能会通过 ARP 获取网关 MAC 地址,

然后建立 TCP 连接,

最后才会发出 HTTP 请求报文。

模块的耦合类型通常分为 7 种,你只要记住 非直接 耦合是 最低 的耦合, 内容 耦合是 最高 的耦合即可。

耦合表示模块之间联系的程度。紧密耦合表示模块之间联系非常强,松散耦合表示模块之间联 系比较弱,非耦合则表示模块之间无任何联系,是完全独立的。

耦合类型

一个模块直接访问另一个模块的内部数据

一个模块不通过正常入口转到另一个模块的内部

两个模块有一部分程序代码重叠

一个模块有多个入口

民用级(Commercial Grade) :<-> 工作温度范围为 0°C 至 70°C,适用于普通消费电子产品。

主程序-子程序

管道-过滤器 #card

关联关系

依赖关系

泛化关系

聚合关系

组合关系

实现关系

系统应用集成构建统一标准的基础平台,在各个应用系统的接口之间共享数据和功能,基本原则是保证应用程序的 :-> 独立性

4 个层次服务 #card #incremental

流程控制

信息传递与转化

应用连接

通信

SoC(System on Chip)是一种 面向特定应用 的集成电路,

[[SAAM]] 关注于可修改性,使用 场景技术 ,但不使用效用树。

C选项CBAM:#card

D选项SAEM:#card

在架构评估中,基于度量的方法强调通过客观的量化数据对系统进行评价。其核心步骤包括: #card #incremental #depth-1

建立映射关系 #card

提取度量信息 #card

推导质量属性水平 #card

准则

(1)子图与父图之间的平衡

个数一致:两层数据流图中的数据流个数一致。

方向一致:两层数据流图中的数据流方向一致。

(2)子图内部平衡要求 :-> 子图内部加工的输入和输出需保持平衡。

常见错误

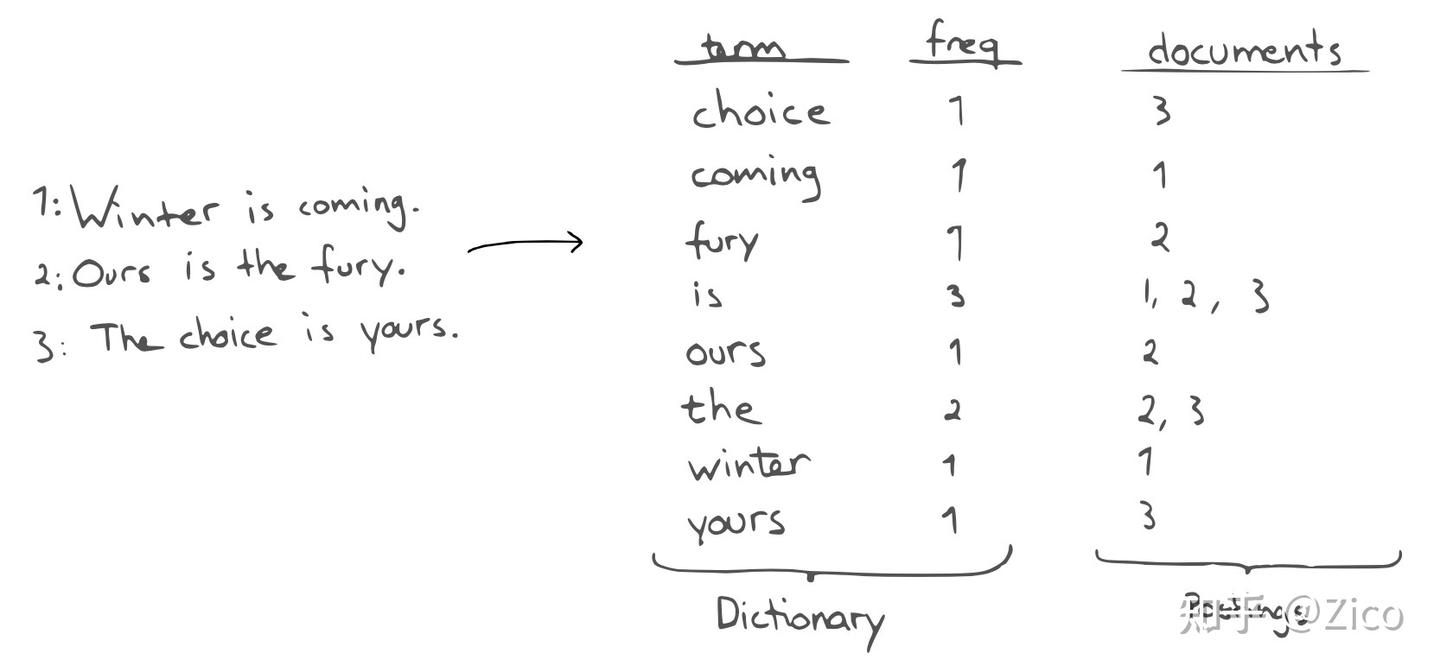

结构化分析方法主要通过 功能模型 和 行为模型 来表示系统的需求。

ER图 主要用于表示 数据模型,描述数据实体及其之间 的关系。

用例图 属于面向对象分析方法,主要描述 :-> 系统的外部行为和用户的需求

数据流图(DFD,Data Flow Diagram)是结构化分析中用于表示功能模型的重要工具,描述 :-> 系统中的数据流、处理过程和存储数据。它用来表示系统的功能需求,是功能模型的典型表现方式。

对象图用于面向对象方法中,主要用于描述 :-> 系统的静态结构

状态图,在结构化分析方法中用来描述 系统或对象的行为随事件变化而发生的状态变更 ,是行为模型的重要组成部分。

结构化分析强调 自顶向下 的系统分解

四个阶段 #card #incremental

数据设计

软件结构设计

人机界面设计

过程设计

软件设计包括了四个既独立又相互联系的活动:

子系统 #card #incremental

概念

派生属性处理方式

最大吞吐率计算 #card

加速比计算 #card

不使用流水线的执行时间(顺序执行10条指令):

总时间 = 10 × 9Δt = 90Δt

使用流水线的执行时间(n条指令公式):

= 9Δt + (10 - 1) × 3Δt

= 9Δt + 27Δt

= 36Δt

消息中间件主要解决 **应用系统之间的异步通信和解耦 ** 问题,

混成系统结合了 离散事件系统与连续动态系统 的特性,

主要概念 #incremental #card

状态、初态、终态

事件、转移、动作。

并发状态机

表格

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDA1Nzk5OTY5NV8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6NTc3LjA1MjIyMzIxMTIzNDMsInRvcCI6MTMxLjEyMTg5ODQ1MDY2NDQsIndpZHRoIjoxNjUuNDYwMTAzMTE1NTk3NiwiaGVpZ2h0Ijo4Ni4xNDYwMzgyMjY2MjM0MiwiYW5nbGUiOjAsImNJZCI6MX0seyJsZWZ0IjoxMjkxLjQ5NTA1NDQ1MjIxMjgsInRvcCI6MTg1LjIzOTY3Njc2NjgzMTYyLCJ3aWR0aCI6MjI2LjI0Mzg4ODgwNjAzOTQsImhlaWdodCI6MTk0LjUwNzQ4MTQ3MDE1NTA4LCJhbmdsZSI6MCwiY0lkIjoyfSx7ImxlZnQiOjIxNy40NDk5MjczMjQxNTU3NywidG9wIjoyODcuNjQzMzQzODM3MjQ5ODYsIndpZHRoIjozOTEuMDY1ODU4MTc0MzQ0MywiaGVpZ2h0IjozOTEuNzU1NzAyMzk2MjM3MiwiYW5nbGUiOjAsImNJZCI6M30seyJsZWZ0Ijo5MjkuNjA0NTAzOTE0MDM3LCJ0b3AiOjI4NS43NzE0NTk1OTI2NTE0Nywid2lkdGgiOjMzNC44MDY4NDc2MjE1NzksImhlaWdodCI6MzcyLjY1NDc0MTgyODI1MzgsImFuZ2xlIjowLCJjSWQiOjR9LHsibGVmdCI6NjAxLjU4MjM5MjA3ODYyNzcsInRvcCI6MjM1LjA3ODE2NjQzOTkyMDIsIndpZHRoIjoyMzkuNzA1NzM3NjAwODk3NDYsImhlaWdodCI6OTQuODMwNTAyMTIzOTc3OTEsImFuZ2xlIjowLCJjSWQiOjV9LHsibGVmdCI6NTc1LjQwMDAxMTI1OTA4MjksInRvcCI6MzM4LjM3NTA1ODY4MjY4MDksIndpZHRoIjoyOTUuNDAzMDkzMDgzNzczLCJoZWlnaHQiOjEwNC44MzM3MTc1MTQzMjI0NywiYW5nbGUiOjAsImNJZCI6Nn0seyJsZWZ0Ijo1NzguMjIwNDAzNTI1MzQwMiwidG9wIjo0NDcuMTU5MDg5MzY0MDYzMSwid2lkdGgiOjMxMy4wOTA0NjU0NTc3NjE0LCJoZWlnaHQiOjEwMC41MzAzOTQ0OTA4NzI0MiwiYW5nbGUiOjAsImNJZCI6N30seyJsZWZ0IjoxMjg1LjI4NzM5MDE5MzI5NTYsInRvcCI6MzkzLjg0NDUxMjQ3NDQwNjc3LCJ3aWR0aCI6MjU4LjY1NDc4MDM4NjU5MSwiaGVpZ2h0IjoxNzcuMTY5MTk0NDQxMjE4OTYsImFuZ2xlIjowLCJjSWQiOjh9XX19

结构化分析步骤 #incremental #card

识别参与者

细化用例描述

合并需求获得用例和调整用例模型

元素

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDA1ODM5ODMwMV8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MTg3Ljc5NzYyNDk5MTc0MTc0LCJ0b3AiOjI4Ni42MDg0MjM1NTAxNDAwNiwid2lkdGgiOjMyNi41ODAzOTY3NTA2MDk4LCJoZWlnaHQiOjM5MC43Nzg2MDYxOTUzMTEyLCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjQ5MC42MDEzNTUyNTM2ODUxNCwidG9wIjoyODMuMzUzODg3NzU1NzczMzcsIndpZHRoIjoxOTIuMzQ1OTA0NjM4MjA5NzMsImhlaWdodCI6NDE0LjQxNzgyNDM3NTI5NzM2LCJhbmdsZSI6MCwiY0lkIjoyfSx7ImxlZnQiOjc2Ni4yOTQ5MTYyMDcwNTc3LCJ0b3AiOjMxOS4zNDY0NzMyNjczMzcyLCJ3aWR0aCI6MjgzLjc0MDEwMzI5MjU4MzUsImhlaWdodCI6NDQ4LjA2ODU1NzMzMTU2MDMsImFuZ2xlIjowLCJjSWQiOjN9LHsibGVmdCI6MTA1OC4xNDcyNzU5ODQyNzY4LCJ0b3AiOjMxNy44MzM4MjE4MTQ5NTgzNiwid2lkdGgiOjE5MS40MDU5OTMyMzM3NTU0OCwiaGVpZ2h0Ijo0MzkuNjczNzYyNTA4ODE2MjUsImFuZ2xlIjowLCJjSWQiOjR9XX19

识别参与者

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDE0MjM2Nzc0OF8wLnBuZyI6eyJjb25maWciOnsiaGlkZUFsbFRlc3RPbmUiOnRydWV9LCJlbGVtZW50cyI6W3sibGVmdCI6NjUxLjQzNzE5NDAwODI4NDUsInRvcCI6MTg5LjI1MDI4NjkwMjczOTgsIndpZHRoIjo3MjIuMjA2OTk4OTUyMDA2OSwiaGVpZ2h0IjoxMDMuMDI2NzA4MTY4MzY5NTEsImFuZ2xlIjowLCJjSWQiOjF9LHsibGVmdCI6NjU1LjYwMzI3ODg4NjY0NjQsInRvcCI6MzA0Ljg1ODU0ODk2ODMwNTYsIndpZHRoIjo3MjAuNTQxNTA2MTgxOTE5NCwiaGVpZ2h0IjoxMDEuNTA3MTYxMjU3MjE5MDgsImFuZ2xlIjowLCJjSWQiOjJ9LHsibGVmdCI6NjQ5LjYwMjgyOTk2Nzk1NDQsInRvcCI6NDIwLjk3MTI0ODU4MjIyMTg1LCJ3aWR0aCI6NzE1Ljg3NTcxMTU1MjcxMjEsImhlaWdodCI6OTguOTc4NzM5MjQ5MzY3OTUsImFuZ2xlIjowLCJjSWQiOjN9XX19

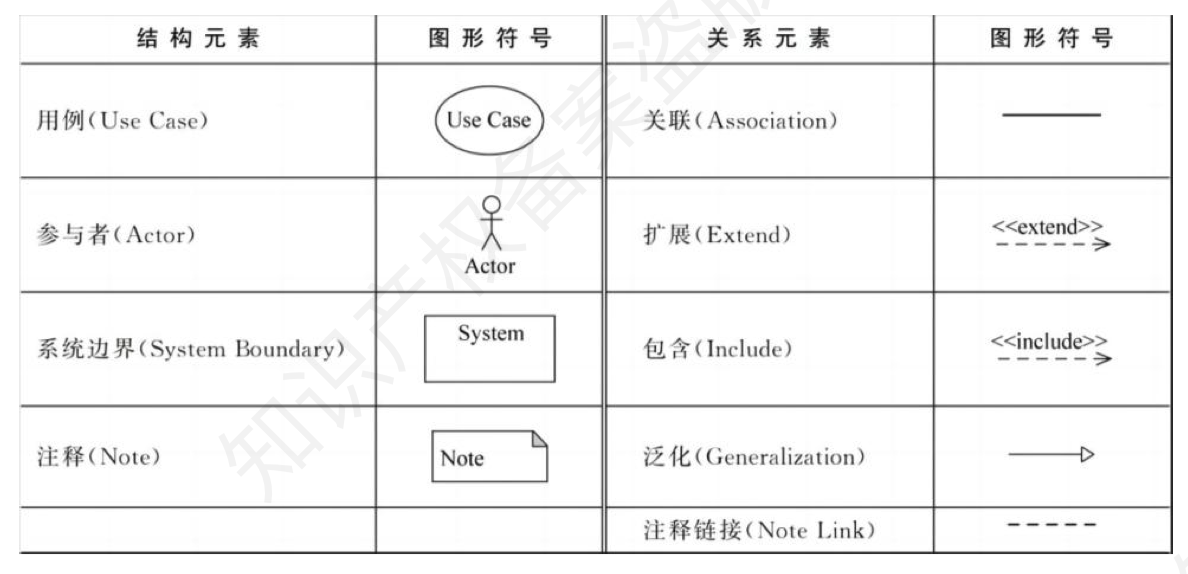

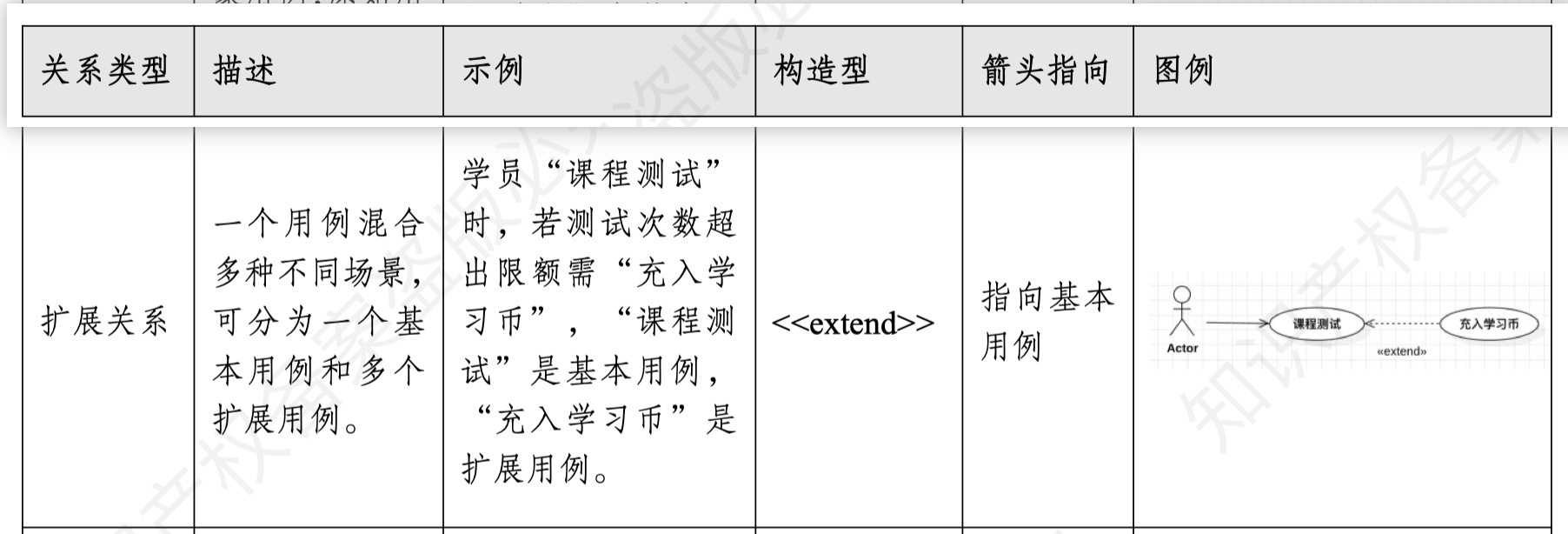

用例图之间的常见关系 #incremental #card

smtp :-> 专门用于邮件发送,客户端通过与 SMTP 服务器建立 TCP 连接将邮件投递到邮件服务器

pop3 :-> 用于从服务器接收邮件

imap :-> (Internet Message Access Protocol)用于邮件的在线访问与管理

MIME :<-> 多用途互联网邮件扩展标准,用于支持电子邮件中的非 ASCII 文本、附件、多部分消息等功能,与安全无关。

PGP Pretty Good Privacy :<-> 一套用于加密与数字签名的应用,可用于加密电子邮件内容

DMA 是一种 绕过 CPU、直接在 内存和外设 之间进行数据成块传输的技术

看门狗定时器超时 #Card

当系统在设定时间内未执行喂狗操作,

说明程序可能出现卡死或跑飞,定时器溢出就会触发看门狗中断,

最终导致系统复位,以保证系统的可靠性。

**系统总线 ** 是 **连接计算机内部各个部件(如CPU、内存、I/O设备等) ** 的传输通道

**存储器 ** 是用来存储数据和程序的部件

**通道 ** 是一种 **用于管理输入/输出(I/O)操作的控制器 **

用图框表示各种操作,独立于任何程 序设计语言,直观且易于掌握,但符 号不规范、随意转移控制的问题需要 改进。

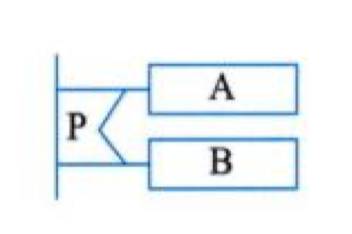

顺序型 #card

选择型 #card

多分支选择型 #card

do-while型 #card

do-until型 #card

TCP 端口号的作用是 :-> 应用层进程的寻址:端口号的核心作用就是用于标识主机上的具体应用进程,传输层协议通过端口号将接收到的数据交付给对应的应用程序

25 :<-> SMTP,邮件传输协议

23 :<-> Telnet 服务端口

110 :<-> pop3接受邮件端口

143 :<-> imap 接收邮件的端口

主要阶段

动态全局转储 :<-> 在转储期间允许用户事务并发运行,并对整个数据库进行转储,能够满足在有运行事务的情况下完成全部数据库备份的需求。

项静态增量转储 :<-> 同样在转储期间禁止访问数据库,并且只保存部分变化数据

动态增量转储 :<-> 允许转储和事务并发执行,但只转储自上次转储以来发生变化的数据

静态全局转储 :<-> 在转储期间不允许对数据库进行任何存取或修改操作,必须等待所有事务完成后才能进行

数据流图

[[数据流图]] 和 [[系统流程图]] 区别

数据流图展现全局的处理过程,过 程之间遵循不同的计时标准;

系统流程图中处理过程遵循一致的计时标准

计时标准是指 :-> 约定图中的处理时长,处理频率等

4 种基本构建 #incremental #card

[[DAO]] 模式主要是为了 :-> 把底层的数据访问操作和高层的业务逻辑隔离开。

为了对图书数据进行操作,我们可以创建一个 BookDAO 接口,定义 addBook、 deleteBook、getBookById 等方法。

然后创建一个 BookDAOImpl 类来实现这个接口,

在这个类 中使用 JDBC(JavaDatabaseConnectivity)或者其他数据库访问技术来完成具体的数据库操作。

DTO 是一种 用于在不同进程或者网络之间传输数据的对象容器 ,它里面只包含数据,不 包含任何业务逻辑。

比如,前端页面需要显示商品的信息。

后端从数据库中查询 出商品的详细信息后, 可能包含很多不需要传递给前端的字段。

这时, 我们可以创建一个 ProductDTO 类,只包含前端需要的字段,如商品名称、价格、图片地址等,然后把这些数据 封装到 ProductDTO 对象中传递给前端。

常用模式

在线访问模式

DAO(数据访问对象)

DTO(数据传输对象)

离线数据模式

对象/关系映射(ORM)

核心状态机

智能合约是一种运行在区块链上的自动化程序,用于在满足预设条件时自动执行合同条款。#card

智能合约主要包含以下三方面内容:

核心思想是 :-> 每次选择距离当前磁头所在柱面最近的请求进行服务,以此最小化寻道时间。

服务端构件模型的典型解决方案分为两类:

基于构件的软件工程

构件是软件系统中的 基础单元 ,它可以通过不同的方式来处理与系统其他部分的兼容性。

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc1NzQyOTQxNDY4MV8wLnBuZyI6eyJjb25maWciOnsiaGlkZUFsbFRlc3RPbmUiOnRydWV9LCJlbGVtZW50cyI6W3sibGVmdCI6MTc3LjA4NTI1NDU1ODgwNTkzLCJ0b3AiOjE1NS42NDU0NzgyNTI5NDksIndpZHRoIjoyODIuOTU1MjQzOTQwNzQ3LCJoZWlnaHQiOjEwNS42NTg1MjY3MjI3Mjk4LCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjE3My4xNzM1NTc4ODM5MjI3NCwidG9wIjozMDAuNzk2MDM2MjkxNDE1LCJ3aWR0aCI6MjYyLjIwOTY2MzIyODcxMjAzLCJoZWlnaHQiOjEyMC45MTI5NTYxNDAzNDYxNywiYW5nbGUiOjAsImNJZCI6Mn0seyJsZWZ0IjoxNzYuOTIzMjUyMjQwODU1MjUsInRvcCI6NDQ4LjA5MTk4MjU2ODUxOTEsIndpZHRoIjoyODYuMTM2MTQ1OTgyODI4NTcsImhlaWdodCI6MTI5LjAyMDk0OTc3Njk5OTE1LCJhbmdsZSI6MCwiY0lkIjozfSx7ImxlZnQiOjE3OC45NjkyMTI5MzM2Mjc4NiwidG9wIjo1ODcuMjkyOTE2MzAxNzA1Mywid2lkdGgiOjI3My40NzM1MzIzNzg3NDI5NiwiaGVpZ2h0Ijo5Ni4yMDU3ODI0Mjc3NDA1OSwiYW5nbGUiOjAsImNJZCI6NH0seyJsZWZ0IjoxNzIuMTQ2ODg0NDYyNDQ4MzYsInRvcCI6NzE5LjYzNzc1Njk3NDM1MjksIndpZHRoIjoyNDkuOTc4NTIzMDQwNzYwNDIsImhlaWdodCI6MTE3LjA4MjAzMTQ1MTE4MjE2LCJhbmdsZSI6MCwiY0lkIjo1fV19fQ==

特性 #incremental #card #depth-1

可组装性是构件的一个关键特性 [[构件组装技术]]

可部署性是 :-> 指构件应能够独立运行并作为一个自包含的实体存在

独立性指 :-> 构件应当能够单独工作

构件分类方法

关键字分类法 :<-> 将应用领域的概念按照从抽象到具体的顺序逐次分解为树形或有向无回路图结构,每个概念用一个描述性的关键字表示

刻面分类法 :<-> 定义若干“面”,每个面包含若干概念,用于刻画构件执行的功能、被操作的数据、应用语境

超文本组织法 :<-> 基于文档跳转的浏览式检索

原子构件的归属是 :-> 唯一的,它只能属于一个构件家族

[[构件组装技术]]

分类 #incremental #card

基于功能 :-> 通过构件提供的功能接口进行组装,强调功能匹配

基于数据 :-> 通过共享数据结构或数据格式实现构件之间的连接与通信

面向对象 :-> :利用面向对象的封装、继承、多态等特性,将构件作为对象进行组装

层次划分

定制(Customization)指 :<-> 对构件进行参数设置、接口适配等操作以满足特定需求

集成(Integration)是 :<-> 将多个构件组合为可运行系统;

扩展(Extension)是 :<-> 通过增加新构件或功能来增强系统

核心构成 #card #incremental

组件(Component)

接口(Interface)

连接件(Connector) :-> 用于定义组件之间的交互机制和通信方式

配置(Configuration)

模块接口是模块与外部进行交互的部分,属于模块的 外部 特性

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDE0MjY1MDg1N18wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MzcxLjg1MzAxNjkwMDMyNDUsInRvcCI6MzgwLjM4Njc2Njc4MDYyNzksIndpZHRoIjoyNzguMzIyMjIzMTQ5ODE3MiwiaGVpZ2h0IjozMjMuNTUxNjQyOTQyNjEwOSwiYW5nbGUiOjAsImNJZCI6MX0seyJsZWZ0Ijo2OTUuNjI3ODcwNDE0NjA0MiwidG9wIjozNzguNzEzODA4OTkyOTcwOCwid2lkdGgiOjMzMC41MTM5NzM3NjMzMzU1NywiaGVpZ2h0Ijo0MDYuODExMjgwMjg3MTk4NzcsImFuZ2xlIjowLCJjSWQiOjJ9LHsibGVmdCI6OTg1LjE1MDc5OTg0MTgwNzMsInRvcCI6Mzg0LjQzNzk5NDQ4MDEyMTcsIndpZHRoIjoyMDQuNjM0MDExMjg2NjU2MjMsImhlaWdodCI6ODIuMzY3NDk5MDQ5OTA4NDIsImFuZ2xlIjowLCJjSWQiOjN9LHsibGVmdCI6MTIwNS41NjQ5MjY4NDQzNTQsInRvcCI6Mzc5LjcyNzI4OTk2NjUyMTgsIndpZHRoIjoxODYuOTgyNzM0MDQ2MDU2OTUsImhlaWdodCI6MTQxLjczNDk4NDE4MjkwNDIsImFuZ2xlIjowLCJjSWQiOjR9XX19

用户态的应用程序无法直接执行特权指令(如I/O操作、访问硬件资源等),必须通过 系统调用 来请求操作系统内核的服务。

水晶系列:适合 :-> 面对面沟通的小团队

FDD:将开发人员分为 :-> 首席程序员和类程序员,

敏捷方法是适应型、可预测型 错误点 #card

敏捷方法的核心是适应性(adaptive),并非“可预测型(predictive)”。

与传统计划驱动方法不同,敏捷方法不追求事先详尽计划,而是欢迎需求变化,通过快速反馈和持续改进来适应变化。

数据互动层: :<-> 主要负责数据采集、传输与处理,是实现数字孪生动态性的关键支撑

共性应用层: :<-> 面向描述、诊断、预测和决策等核心应用需求的层面

4 大特点

数据分区的底层逻辑是 :-> 将一张表的数据按某种规则(如范围、哈希或复合条件)划分为多个逻辑子集,称为分区。

分区的好处

查询性能角度 :-> 按特定规则分区,查询时仅访问相关分区数据,减少 I/O 操作,加快查询速度

管理角度 :-> 把大表拆分为小且易管理的块,方便数据的维护、备份、恢复等操作

数据隔离角度 :-> 可将不同类型或不同时间范围的数据分隔,简化数据管理流程,也利于权限控制等

数据分区算法

范围分区

列表分区

哈希分区

复合分区

分片(Shard)是 :-> 把数据库横向扩展(ScaleOut)到多个物理节点上的一种有效的方式

其主要目的是 :-> 为突破单节点数据库服务器的 I/O 能力限制,解决数据库扩展性问题。

分片分类

水平分片 #card

水平分片将一个全局关系中的元组分裂成多个子集,每个子集为一个片段。

分片条件由关系 中的属性值表示。

对于水平分片,重构全局关系可通过关系的并操作实现。

垂直分片 #card

垂直分片将一个全局关系按属性分裂成多个子集,满足不相交性。

对于垂直分片,重构全局 关系可通过连接运算实现。

导出分片 #card

导出分片又称为导出水平分片,即水平分片的条件不是本关系属性的条件,而是其他关系属 性的条件。

像关系 SC,是一个学生选修课表(学号,课程号,成绩)。

而是根据学号关联 学生表(学号,性别),然后用学生的性别来分片。

混合分片 #card

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MTE4MDk0Nzg5Ml8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6ODEyLjczNjQ0MjA2Njc4NTUsInRvcCI6MTY1LjYzMDIzNzQzNzY1MzUzLCJ3aWR0aCI6OTU1LjQ3NTY2NzUwMTI3OTgsImhlaWdodCI6NzEuMjYwODUwMzU5MzY1NjYsImFuZ2xlIjowLCJjSWQiOjF9LHsibGVmdCI6ODk3LjczNjc5NTk1MjEwODUsInRvcCI6MjYyLjYzMDE4MDA3MjAzMzQ1LCJ3aWR0aCI6MTE0NS40NzU2NzU0NTM3NTg5LCJoZWlnaHQiOjc3LjI2MjAwODEwMTg3OTcyLCJhbmdsZSI6MCwiY0lkIjoyfSx7ImxlZnQiOjgzOS43MzY5ODY4MTE2MDg1LCJ0b3AiOjM2MC4xMzE1OTMzNTIzMDk3LCJ3aWR0aCI6MTAzNy40NzQ4NDgzOTU5MjUyLCJoZWlnaHQiOjc4LjI2MDIwMzY5MjM3NTc0LCJhbmdsZSI6MCwiY0lkIjozfSx7ImxlZnQiOjkwMS43MzY0NzM4NzY3MDIzLCJ0b3AiOjQ1My4xMzA5NjIzMzA0ODg5Niwid2lkdGgiOjExNjEuNDc2MzY3MzE5NDQ2MSwiaGVpZ2h0Ijo2OC4yNjIzODM1ODU5MzgzMiwiYW5nbGUiOjAsImNJZCI6NH0seyJsZWZ0Ijo5MTUuNzM2ODMzNzI2Mzg0NywidG9wIjo1NDYuMjYyNDYxODExNzgzNywid2lkdGgiOjExNjkuNDc1NzE5MTkyMzk0LCJoZWlnaHQiOjcwLjAwMDM2NTA1Mzk0NjMzLCJhbmdsZSI6MCwiY0lkIjo1fV19fQ==

数据字典在分析与设计阶段的作用为: 是所有人员工作的 依据,统 一的标准。

它可以确保数据在系统中的 :-> 完整性和一致性。

具体作用包括:

按各种要求列表、相互参照、由描述内容检索名称、 一致性 检验和 完整性 检验。

[[嵌入式数据库]]

数据库性能优化

外模式,也称为子模式或用户模式 :<-> 是用户看到并使用的数据库视图,是数据库与用户之间的接口

模式 :<-> 是数据库的逻辑结构,是数据库中所有数据的逻辑视图和整体结构的描述,包括各个数据项之间的逻辑关系。

内模式 :<-> 数据在物理层的存储方式,包括文件的组织方式、索引结构(如聚簇索引和非聚簇索引)、数据的压缩方式等。

如果对一个表创建聚簇索引,那么改变的是数据库的(__) #card

描述的是数据在物理层的存储方式,包括文件的组织方式、索引结构(如聚簇索引和非聚簇索引)、数据的压缩方式等。

聚簇索引属于数据的物理组织结构,因此修改聚簇索引改变的是数据库的内模式,这是正确答案。

概念模式 描述了数据库中数据的类型、结构、记录之间的联系、操作及数据完整性和安全性等内容

数据库里数据越来越多会导致的现象

第一,资源报警。#card

第二,查询变慢。#card

第三,热点集中。#card

分库分表的目的其实就是

分 库 :-> 解决单机承载能力有限的问题,把请求分散到多台服务器上。

分表 :-> 解决单表数据量过大 的问题,把数据拆开,让查询在更小的范围内完成。

方案

水平分表

垂直分表

水平分库

垂直分库

分库分表和分片分区的区别 #card

分库分表是一种物理实现方式,分片是抽象概念。

你可以 说“我的系统做了分片”,而实现手段就是“分库+分表”。

为什么要引入范式 #card

关系型数据库减少数据冗余,

避免数据异常的规范化规则

1NF :<-> 每列原子性,所有字段都是单一值

2NF :<-> 所有非主属性必须完全依赖主键,消除了非主属性对码的部分依赖

3nf :<-> 所有非主属性必须直接依赖于主键

bcnf :<-> 所有决定因素(左侧)必须是候选键(超键)

4NF :<-> 去除多值依赖

表:订单(订单ID, 产品ID, 产品名称, 数量),主键是复合键(订单ID, 产品ID)。2nf 问题在哪里? #card

表 学生(学号, 姓名, 学院, 学院地址),其中学院地址依赖学院,而学院依赖学号。如何符合 3nf #card

表 课程(学生, 教师, 课程),假设一个教师只教一门课,但一门课有多个教师。如何实现 bcnf #card

如果函数依赖A->B,B->C,则属于哪一范式 #card

传递依赖

2NF

安全性需求的核心目标是 :-> 防止系统在运行中出现危及人员安全、设备安全或环境安全的情况

完整性约束是指数据库中确保 数据的准确性和一致性 的一种规则。

不同类型

**实体完整性 ** 是指数据库中的每个实体(即表的每一行)必须是唯一的,通常涉及主键的设置,确保每条记录的唯一性。

**参照完整性 ** 是指一个表中的外键值必须对应另一个表的主键值。它用于保持表与表之间的数据一致性。

**用户定义完整性 ** 是指数据库中可以由用户根据实际业务需求定义的特定规则或约束。

定义 #card

一种将应用及其依赖项打包成独立单元 的技术,可在不同环境中运行,共享宿主 机内核

用于自动化部署、管理和扩展容器化应用程序的 技术,能管理多个容器组成的集群

核心功能 #card

隔离应用运行环境,实现应用的快速部署 和迁移

容器集群管理、资源调度、服务发现、负载均衡、 自动伸缩、故障恢复等

代表工具 #card

Docker

Kubernetes(k8s)

部署难度 #card

部署单个容器相对简单,通过拉取镜像并 启动容器即可

部署和配置容器编排系统较为复杂,涉及多个组 件的安装、配置和集群初始化

适用场景 #card

适合部署单一、简单的应用,或作为微服 务架构中单个服务的运行载体

适用于大规模、复杂的容器化应用集群管理,如 大型互联网应用、企业级分布式系统,这些系统 需要高效的资源调度、自动伸缩和服务治理等功 能

管理粒度 #card

主要管理单个容器的生命周期,如创建、 启动、停止、删除,以及容器内应用的运 行状态

从集群层面管理多个容器,包括容器的分组、调 度到不同节点、监控容器的健康状态、动态调整 容器数量等

运行原理

+

运行原理 #card

基于操作系统层面的虚拟化, 共享宿主机内 核,直接运行在操作系统之上

通过硬件虚拟化技术,模拟出完整的硬件 环境,运行独立的操作系统

资源隔离方式 #card

利用 cgroups 进行资源限制(如 CPU、内存、 磁盘 I/O 等),通过 namespace 实现命名空间 隔离(如进程、网络、文件系统等),不同容 器共享内核但彼此隔离

依靠硬件虚拟化技术,在不同虚拟机实例 间实现完全的资源隔离,每个虚拟机有独 立的内核和硬件资源

启动速度 #card

启动非常快,一般在秒级。因为无需启动完整 操作系统,仅需加载应用及其依赖

启动相对较慢, 通常需要数十秒到数分 钟,要加载整个操作系统

资源占用 #card

占用资源少,仅需运行应用所需的资源,因为 共享宿主机内核

资源占用多,每个虚拟机都有独立的操作 系统和完整硬件资源模拟,开销大

应用移植性#card

移植性好,将应用及其依赖打包在镜像中,环 境一致性高,可在不同支持容器的环境中快速 部署

移植有一定难度,受虚拟硬件环境和操作 系统影响,迁移时需考虑兼容性

隔离性#card

隔离性相对较弱,虽能实现进程、网络等隔离, 但共享内核,存在一定安全风险(如内核漏洞 可能影响多个容器)

隔离性强,每个虚拟机相互独立,一个虚 拟机出现问题基本不影响其他虚拟机

管理复杂度#card

相对简单,主要管理容器镜像、容器生命周期 (创建、启动、停止、删除等),通过编排工 具可实现集群管理

管理复杂,需管理多个虚拟机的操作系统 安装、配置、补丁更新等,以及虚拟硬件 资源的分配和管理

docker 常用指令 #card

Kubernetes 常用指令 #card

分层架构的脆弱性包括 **底层发生错误会导致整个系统无法正常运行、层与层之间引入通信机制势必造成性能下降 ** 两个方面

网络划分层次 #card

核心层

汇聚层

接入层

层次式体系结构设计是将系统组成一个层次结构,每一层为 上层服务 ,并作为下层客户。

分层架构的一个特性就是关注分离。#card

该 层中的组件只负责本层的逻辑,

组件的划分很容易明确组件的角色和职责,

也比较容易开发、 测试、管理和维护。

污水池反模式(SinkholeAnti-Pattern) :-> 在这个模式中,请求流只是简单穿过各层次。

缺点 #card

这种做法会导致层次间隔离失效会使系统结构不清晰,

业务规则变化时修改易出现遗漏或 不一致、可维护性降低。

解决方法 #card

典型层次架构

[[嵌入式处理器]]

用来进行 cpu 调试的接口 :-> JTAG

该方法通过使用 基于构件 的开发方法获得快速开发。

形式化开发基于 数学逻辑和形式化语言 对系统需求、设计与实现进行建模和验证,强调在开发早期消除缺陷。

性能质量属性场景主要关注系统的响应速度,可以通过效率、响应时间、 吞吐量 、负载来客观评价性能的好坏 。

结构组成

ABSD 方法有三个基础,分别是 #card #incremental

对系统进行功能分解

采用 **架构风格 ** 实现质量属性与商业需求

采用 软件模板 设计软件结构。

6 个关键步骤 #card #incremental

需求变化归类 :<-> 识别并归类用户需求变动,分析哪些变动对应已有构件,哪些需要新增构件。

制订体系结构演化计划 :<-> 在修改结构之前,制定详细的演化实施计划,确保演化过程有序进行。

修改、增加或删除构件 :<-> 根据变化归类结果调整构件集合,进行必要的增、删、改操作。

更新构件的相互作用 :<-> 因为构件变动可能改变构件之间的接口、依赖和交互,因此需更新它们之间的控制流和数据流关系。

构件组装与测试 :<-> 将各构件重新集成,形成新的系统架构,并进行系统级功能和性能测试。

技术评审 :<-> 对整个演化过程和成果进行评审,确保体系结构正确反映了新需求。

在 ABSD 中,强调从多个视角分析系统架构,以确保设计的全面性和高质量:

静态视角 :<-> 用于展示系统功能结构的组织形式,便于分析系统的质量特性,如可维护性、可扩展性等。

动态视角 :<-> 关注系统在运行时的行为特征,如并发性、实时响应性,用于分析系统行为特性。

配置视图 :<-> 用于表示软件到硬件的映射和分布结构(这是架构4+1 视图的定义)。

逻辑视图 :<-> 用来描述系统中设计元素的功能、接口等,明确它们在整个系统中承担的角色,是记录系统功能结构的核心视图

ABSD 体系结构需求一般来自3个方面,分别是 #card #incremental

系统的质量目标

系统的商业目标

开发人员的商业目标

顶层系统自顶向下被分解为若干个 :-> 概念子系统

NDB 架构由 客户端、通信协议和远程服务器 组成

在无噪声的理想条件下,信道的最大数据传输速率(也称为码元速率)公式 #card

契约式设计(Design by Contract,DbC)是一种方法论,它要求软件组件的接口必须精确定义,包括前提条件、后置条件和不变式。#card

前提条件定义了调用者必须满足的条件,后置条件描述了函数执行完后的期望结果,而不变式则是整个组件或类在生命周期中始终不变的条件。

这种设计方法有助于确保系统中各个组件之间的正确交互,提升系统的可靠性。

核心运算符

关键成功因素法通过对 关键成功因素 的识别,找出实现目标所需要的 关键信息集合 ,从而确定系统开发的 **优先次序 **

关键成功因素来源于组织的目标 #card #incremental

通过组织的目标分解和关键成功因素识别、

性能指标识别,

一直到产生数据字典 。

内聚表示模块 :-> 内部各成分之间的联系程度,

是从 功能角度 来度量模块内的联系,

一个好的内聚模块应当 :-> 恰好做目标单一的一件事情。

顺序内聚和过程内聚最大的区别是 #card

顺序内聚的模块各个成分和同一个功 能密切相关,并且一个成分的输出作为另一个成分的输入,存在数据传递和依赖关系;

而过程内聚 中构件或操作之间即使没有数据传递也可组合在一起,不一定存在数据上的依赖。

类型

由 一组对象 提供系统服务且可跨平台通信

模式结构

核心思想 #card

分布式数据库缓存指的是在高并发环境下,

为了减轻数据库压力和提高系统响应时间,

在数据库系统和应用系统之间增加的独立缓存系统。

面向对象的分析模型主要由顶层架构图、用例与用例图和 领域概念模型 构成

设计模型则包含以 包图 表示的软件体系结构图、以 交互图 表示的用例实现图、完整精确的类图、描述复杂对象的 状态图 和用以描述流程化处理过程的 活动图 等。

哈希分片

原理 :-> 对指定的键(如 id)进行哈希运算,再根据 哈希值对存储节点数量取模,所得余数对应 数据应存放的表或节点

适用数据 :-> 数据分布较为均匀,无明显的顺序性或时 间相关性;数据之间的关联性较弱,每个 数据可独立读写

范围分片

原理 :-> 按照特定的范围区间(如时间区间、 ID 区 间等)来划分数据,将满足某一范围条件的 数据存放在一起

适用数据 :-> 具有明显的顺序特征,如按时间先后产生、 按编号顺序排列;数据在某个维度上呈现 出可划分的区间特性

地理位置分片

原理 :-> 依据地理位置信息(如城市、地域等)来分 配数据,将同一地理位置相关的数据存储在 同一位置或相关联的存储单元中

适用数据 :-> 数据与地理位置紧密相关,不同地理位置 的数据使用场景、访问频率等有差异

融合算法

原理 :-> 灵活组合多种分片算法,结合不同算法的优 势来分配数据

适用数据 :-> 数据特点多样,可能同时具有随机读写、 范围查询需求,或兼具多种维度的关联特 性

分片算法

原理

适用数据

取模算法

原理 :-> 对数据的某个键值进行哈希运算,将 哈希值对分片数量取模,所得结果作为数 据存储的分片索引

适用数据 :-> 适合随机访问的数据, 数据分布期望 均匀的场景,例如用户 ID、订单 ID 等主键 数据

范围算法

原理 :-> 按数据的某个字段(如时间、数值等) 的范围划分分片

适用数据 :-> 有范围查询需求的数据, 例如按时间 范围统计的日志数据、按数值区间划分的 业务数据等

列表算法

原理 :-> 列举数据某个字段的取值,指定每个 取值对应的分片

适用数据 :-> 业务场景中取值范围固定且明确的数 据,例如地区、部门等有明确分类的数据

一致性哈希 算法

原理 :-> 将数据键值和节点通过哈希函数映 射到固定哈希环上,数据从其哈希值位置顺时针找第一个节点存储;节点增减时, 只影响相邻部分数据

适用数据 :-> 分布式系统中节点需要动态调整的数 据, 例如缓存数据、 分布式存储中的对象 数据等

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDE0MjU4NTE3Ml8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6Mzg1LjcwNTExNjI3MDYxNDIsInRvcCI6NDA3LjM2ODAyOTU0MDEzODMsIndpZHRoIjoyNTcuMjk5MzMzMTQ3ODA1OCwiaGVpZ2h0IjozNjYuNTAxMjY5NTkzOTkyMTYsImFuZ2xlIjowLCJjSWQiOjF9LHsibGVmdCI6NzA5LjQxNDExNTUwMTQzNjYsInRvcCI6NDExLjIyNjE0NjIwODEzNTIsIndpZHRoIjozMzYuMjg4MDQzNjM0OTEzLCJoZWlnaHQiOjQxNS40MDczNTM3OTk0NzgzLCJhbmdsZSI6MCwiY0lkIjoyfSx7ImxlZnQiOjEwMTMuNjMzMjg5NjE4MDkzMiwidG9wIjozOTkuMDUyOTU3NjExMjkzOCwid2lkdGgiOjIxMS4wMTAxMjEwNzg1MjI0LCJoZWlnaHQiOjEyNi42NjU2MjIyMzQzOTEzMiwiYW5nbGUiOjAsImNJZCI6M30seyJsZWZ0IjoxMjMxLjUxNzkxODQ3NDkzNiwidG9wIjo0MDguOTMxNjQ5NzEwMDQ2OCwid2lkdGgiOjE3MS43NjU2MjY1MDY1ODY0MSwiaGVpZ2h0IjoxNDMuNTQ2MjA4MjEwNzgzODUsImFuZ2xlIjowLCJjSWQiOjR9XX19

包装器外观模式通过 为底层复杂或多变的 API 提供统一封装,使上层应用代码在不同平台之间实现一致调用, 从而提高可移植性与可维护性。

6 个层次 #card #incremental #depth-1

数据层

网络层

共识层

激励层

合约层

应用层

桩模块和驱动模块区别 #card

桩模块是模拟被测模块调用的下级模块

驱动模块用于调用被测模块

自顶向下的单元测试和子底向上测试区别 #card

在自顶向下测试中,测试从系统的顶层模块开始,逐步向下集成。

在自底向上测试中,由于底层模块没有上层模块来驱动调用,因此需要额外编写驱动模块。

划分阶段

服务化架构模式 (SOA/微服 务/小 服务)

按业务域或功能模块拆分应用,每个模块作为独立服务运行,通过 接口契约(API/ 协议) 进行交互。

常结合 DDD(领域驱动设计) 进行服务边界划分, 用 TDD 提升 质量,并通过容器化与 CI/CD 管理快速迭代。

优点 :-> 灵活扩展、独立部署、降低 耦合;

缺点 :-> 分布式环境下治理成本高。

典型场景 :-> 电商订单、支付、库存拆分为 微服务。

Mesh 化 架 构 模 式 (ServiceMesh)

将中间件能力(RPC 通信、负载均衡、限流熔断、安全认证等)从业务进程中剥 离,由独立的 Sidecar/Proxy 组件(Mesh 进程)统一处理。#card

优点 :-> 统一治理、解 耦复杂逻辑,

缺点 :-> 引入额外性能开销。

典型实现 :-> Istio、Linkerd。

Serverless 模式

应用无需管理底层服务器,开发者只需编写业务逻辑代码,由云平台自动完成部署、 运行、弹性伸缩和关闭。#card

优势 :-> 极大降低运维成本、按需伸缩,

劣势 :-> 冷启动延迟和厂商锁定风险。

典型场景 :-> 图片处理、日志分析、IoT 数据采集。

存储计算分离模式

将计算层与存储层解耦:计算节点保持无状态,数据全部存储在分布式存储/云存 储中。#card

优点 :-> 是弹性伸缩、 成本优化

缺点 :-> 计算与存储分离带来延迟问题。

典型应用 :-> Snowflake、TiDB、云数仓。

分布式事务模式

在跨数据库/跨服务的事务中保持数据一致性,常见模式有:

可观测架构

通过三大核心能力实现对系统运行状态的全面感知:#card

Logging:多级日志,记录系统行为和错误。

Tracing:分布式调用链路追踪,快速定位性能瓶颈。

Metrics:系统指标采集与量化(QPS、响应时间、并发度等)。

结合 SLO/SLA 定义服务目标,用于监控、报警和运维优化。

典型工具 :-> Prometheus、 Grafana、ELK、Jaeger。

事 件 驱 动 架 构 (EDA)

系统以 事件 为核心进行交互,事件作为独立数据单元,包含 Schema, 可被生产者 发布、消费者订阅。具备 QoS 保证和失败补偿机制。

优点 :-> 服务解耦、异步处理、 可扩展;

适合高并发、异步业务场景,如 :-> 订单完成触发发货、数据库变更触发缓存 更新。

常用技术 :-> Kafka、 Pulsar、EventBridge。

弹性原则和韧性原则的区别 #card

乍看好像都是为了针对业务来做资源伸缩,保障系统稳定运行。

实际上弹性侧重“资源动态适配 业务需求”,

韧性侧重“故障场景下的系统保护”

原则

Kernel-based Virtual Machine,是 :-> 基于Linux内核的虚拟化技术,支持完全虚拟化

Xen :-> 开源的虚拟机监控器,支持半虚拟化和完全虚拟化,是早期云计算平台常用的虚拟化技术。

Hyper-V :-> 微软开发的虚拟化平台,是Windows Server中的重要组成部分,用于支持虚拟机的创建和管理。

Linux Virtual Server :-> 一种负载均衡技术,用于实现集群系统中请求的调度与转发

项目配置管理中,产品配置是指一个产品在其生命周期各个阶段所产生的各种形式和各种版本的 文档、计算机程序、部件及数据 的集合。

仓库风格是一种 以中央数据存储 为核心的体系结构风格,

共享内存 #card

Socket:#card

消息传递属于一种更高级的通信方式,通常 依赖消息队列或邮箱 等机制,有明确的消息边界

信号量是用于 任务同步与互斥 的机制,不直接用于传递数据

基本功能

企业集成是一个从底层技术基础设施到高层业务功能的逐层构建过程,其由下至上的标准顺序如下: #incremental #card

ESB([[企业服务总线]])是一种中介机制,它提供 消息路由、协议转换、消息转换 等能力,可以在服务消费者和服务提供者之间实现真正的 松耦合

ESB通过 消息传递 机制解耦了服务请求者与服务提供者之间的 直接连接,实现了松耦合

三个阶段 #card #incremental

可控性 :-> 指对信息流动方向和权限进行控制

机密性 :-> 防止信息泄露给未授权用户、实体或过程

信息建模方法是从数据的角度对现实世界建立模型,模型是现实系统的一个抽象,信息建模方法的基本工具是 :-> 实体联系图。

战略目标集转化法将信息系统规划看作是一个 “信息集合” 的构建过程,

它从组织的整体战略目标出发,逐级分解并转化为 信息系统的战略目标 ,以保证信息系统建设与组织战略的一致性。

企业系统规划法(BSP)由IBM提出,是一种结构化的信息系统规划方法。

它通过自上而下识别 企业的战略目标和业务过程 ,再通过自下而上的 数据分析设计信息系统 ,是一种综合性强的方法。

候选码定义 :-> 能够唯一标识表中每一行数据的最小属性集合

数据类型 :-> key/value,list,set,string,sorted 或 丰富/多种数据结构

多线程支持 :-> Redis5.0及以前版本不支持

分布式存储常见方案 #card

主从模式(Master/Slave) :-> 主要解决读写分离和数据备份,但主库宕机时需人工切换;

哨兵模式(Sentinel) :-> 在主从基础上增加自动化监控与故障转移,提升高可用性;

集群模式(Cluster) :-> 则通过内置的 slot 分片机制,支持多主多从、自动负载均衡,是互联网企业应对大规模业务的主流方案。

集群切片方式

客户端分片 #card

即在客户端就通过key的hash值对应到不同的服务器。

逻辑简单但耦合度高,需要客户端维护分片策略

中间件实现分片 #card

在应用软件和Redis中间,例如:Twemproxy、Codis等,由中间件实现服务到后台Redis节点的路由分派。

通过代理层屏蔽复杂性,应用透明,但会引入转发开销;

客户端服务端协作分片

Redis Cluster模式,客户端可采用一致性哈希,服务端提供错误节点的重定向服务slot上。不同的slot对应到不同服务器。

Redis Cluster采用 16384 个 slot,服务端负责管理 slot 与节点映射,客户端根据 key 的 CRC16 计算 slot 并路由到对应节点,若节点迁移则通过 MOVED/ASK 重定向实现动态调整。

建模元素

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDE0MzYyODkwOV8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6NzE2Ljg1NzM4MDg0MDU4NzcsInRvcCI6MTgzLjIyNTI0NTM0Mjc1MTI0LCJ3aWR0aCI6OTEyLjA1NzgxNzk0NjgyNzgsImhlaWdodCI6NzUuMTIxNjA4NDEwNDUxMTMsImFuZ2xlIjowLCJjSWQiOjF9LHsibGVmdCI6NjkyLjAwNTQ5ODAxNjAzNjIsInRvcCI6MjkxLjcwOTQxODYxOTg1MjEsIndpZHRoIjo4ODEuNzgzMDM4NDI5MTQ3OCwiaGVpZ2h0Ijo5NC41MDM5MDMzODQ4ODc0LCJhbmdsZSI6MCwiY0lkIjoyfSx7ImxlZnQiOjY2Ny4yNzc2NTA5NDYwMTcsInRvcCI6Mzk2LjU1OTE5NTQwMjgzMTQsIndpZHRoIjo4MzQuNTk3OTkwNDkyNjU1OCwiaGVpZ2h0Ijo4Ny44NjYxNjg1OTcwNTQ0NywiYW5nbGUiOjAsImNJZCI6M31dfX0=

画法

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDE0MzY3MDkzMl8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6NTU4Ljc3Mjc5MDUyNzE4NzIsInRvcCI6MjAwLjc4MTcwOTgwNTUwODcsIndpZHRoIjoyMjguOTY2ODQzNDY1MjQ3MTcsImhlaWdodCI6MTkyLjU2MzU0NzY3Njk0NzYyLCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjEyMTAuNDc0ODM5OTc5MDM5OSwidG9wIjoyNDUuMTU2NzI1ODEzNzQ5OTQsIndpZHRoIjoyNzcuOTQ2Njc2MzQ0MzI1NiwiaGVpZ2h0IjoyNzEuMzE0OTQ1NzMwMDE4NDUsImFuZ2xlIjowLCJjSWQiOjJ9XX19

作业C所需的时间,乐观估计为5天,最可能为14天,保守估计为17天。估算结果 #card

*实际上预期活动天数 = (最小+4最可能+最大)/ 6 **

(5+14×4+17)/6=13

从 用户角度 划分软件质量的三个主要方面 #incremental #card

常见的业务流程建模方法包括:

(1)流程图(Flowchart)

(2)角色活动图与角色交互图

(3)IDEF0 与 IDEF3

(4)高级 Petri 网(High-level Petri Net)

(5)UML 活动图(Activity Diagram)

(6)业务流程建模标注(BPMN) :-> 业务流程建模标注,专门用于业务过程建模

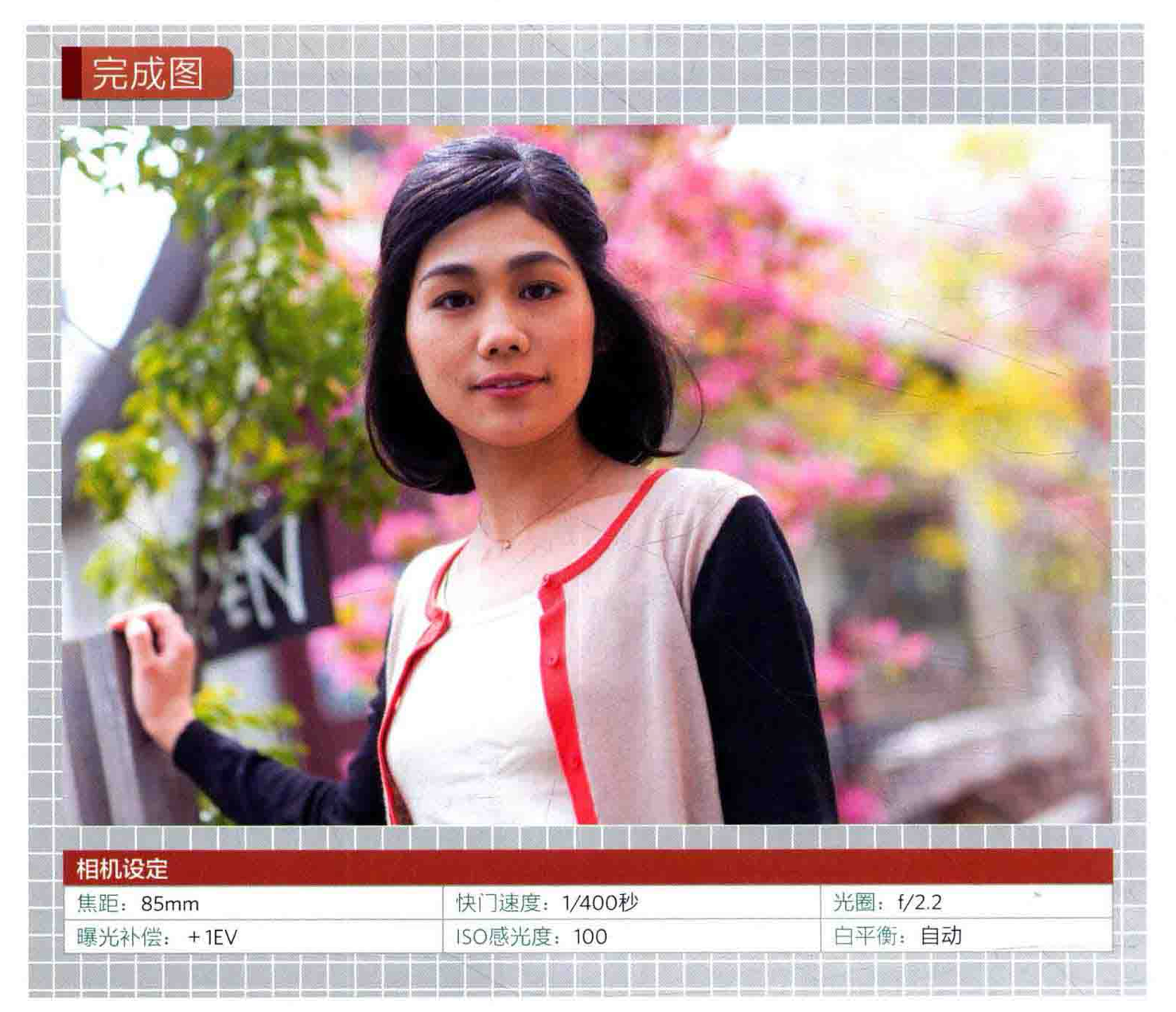

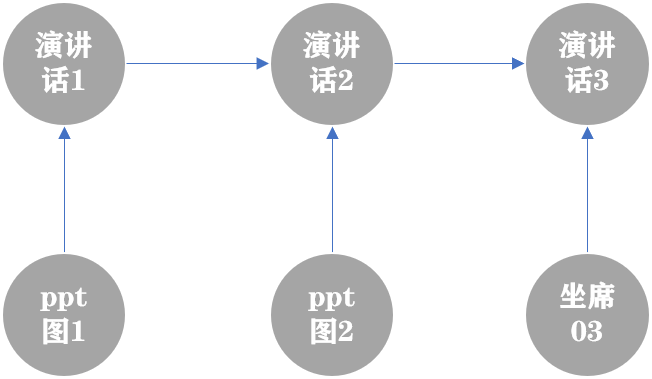

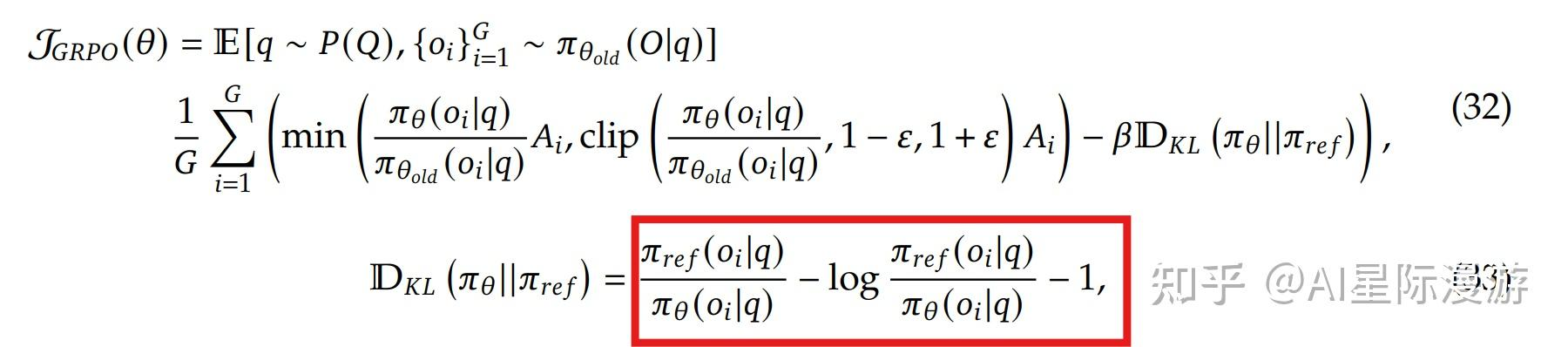

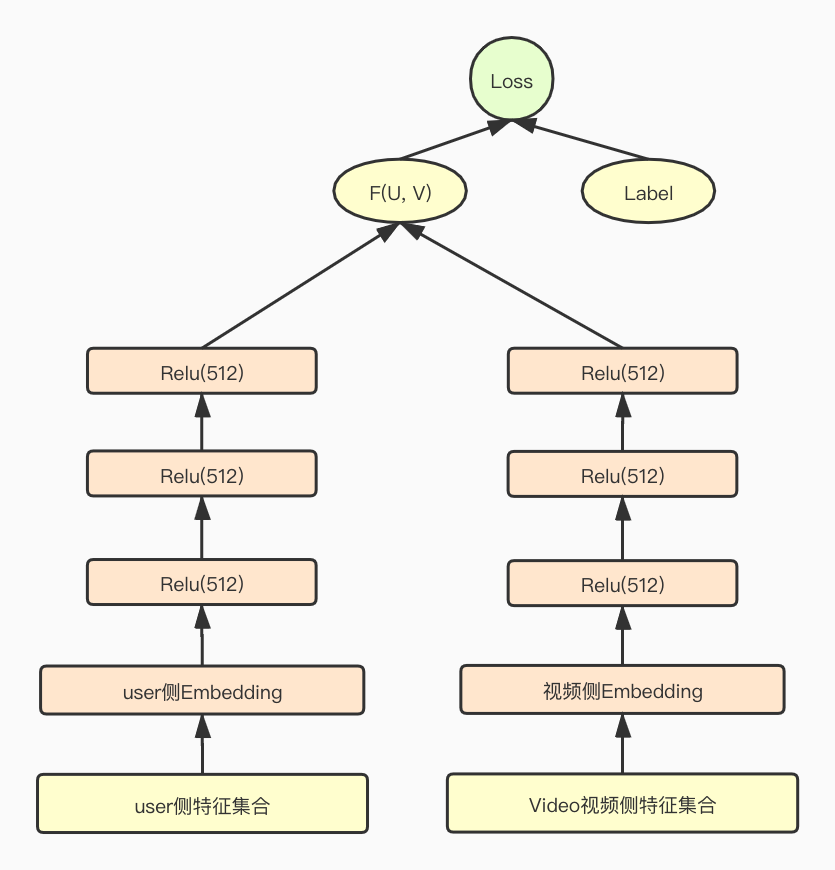

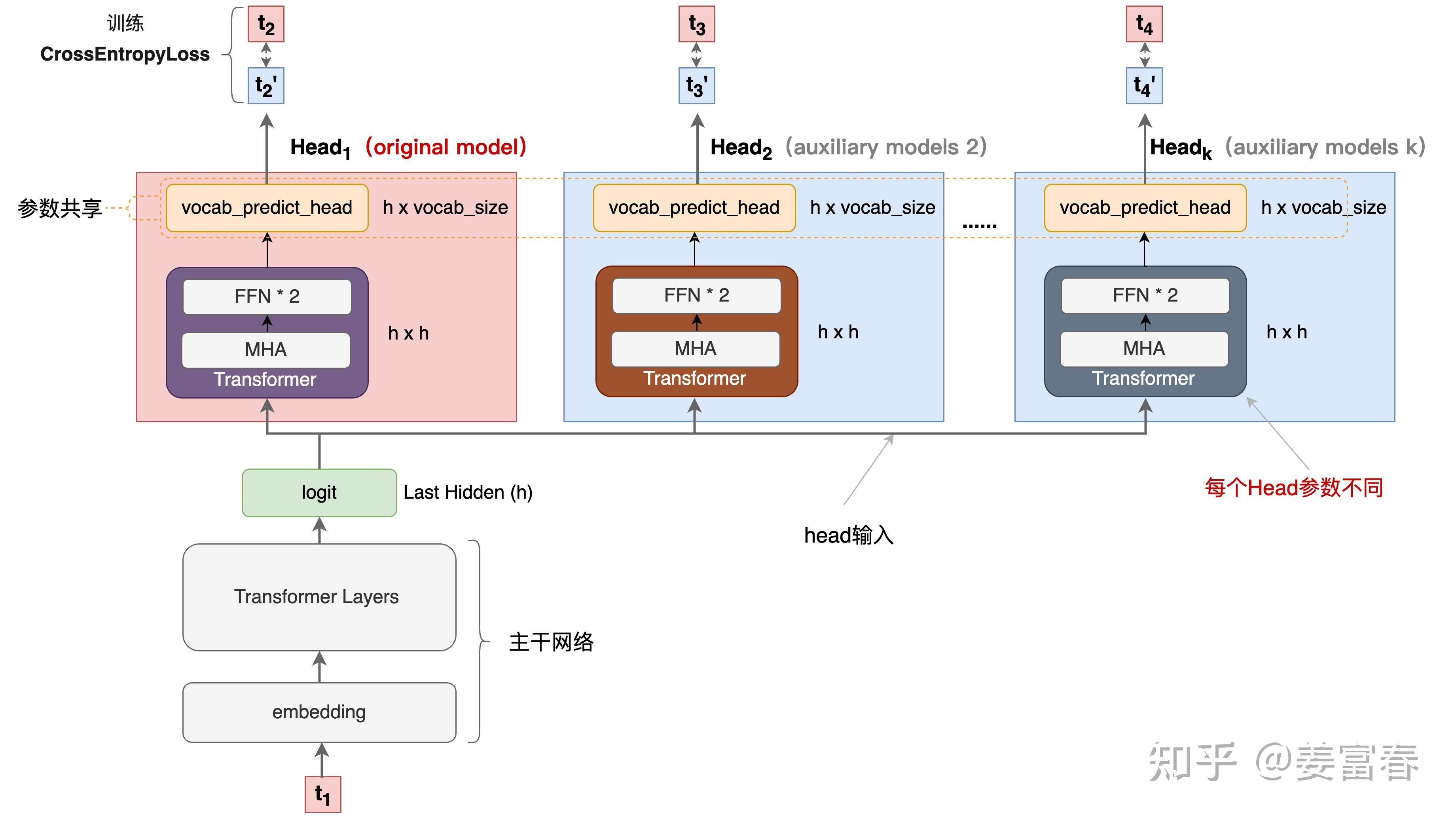

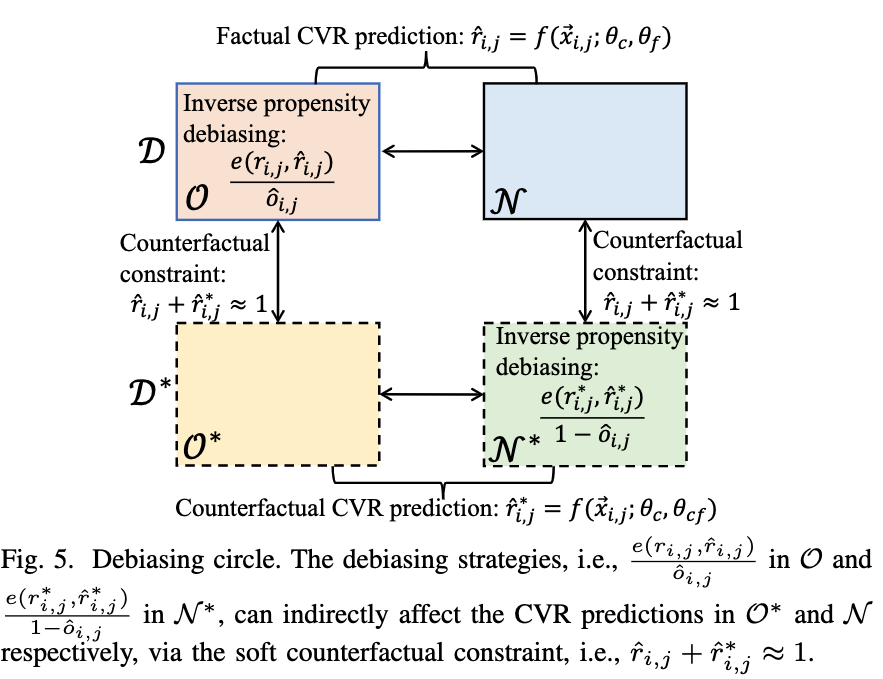

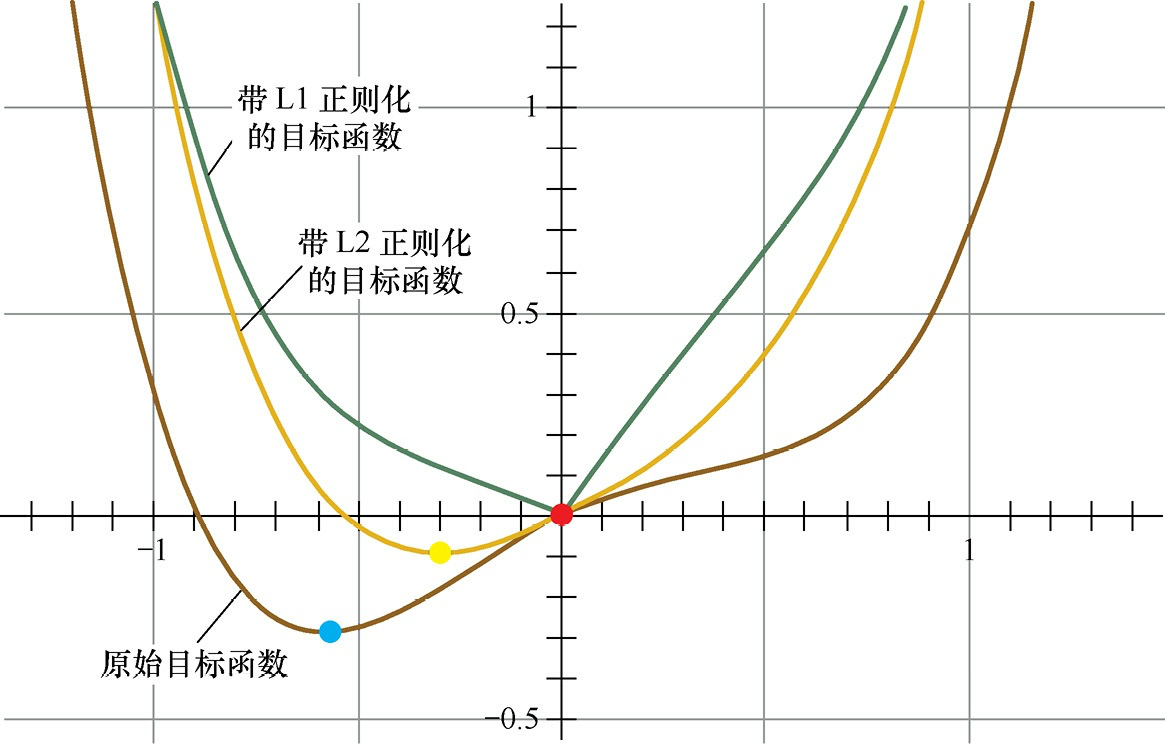

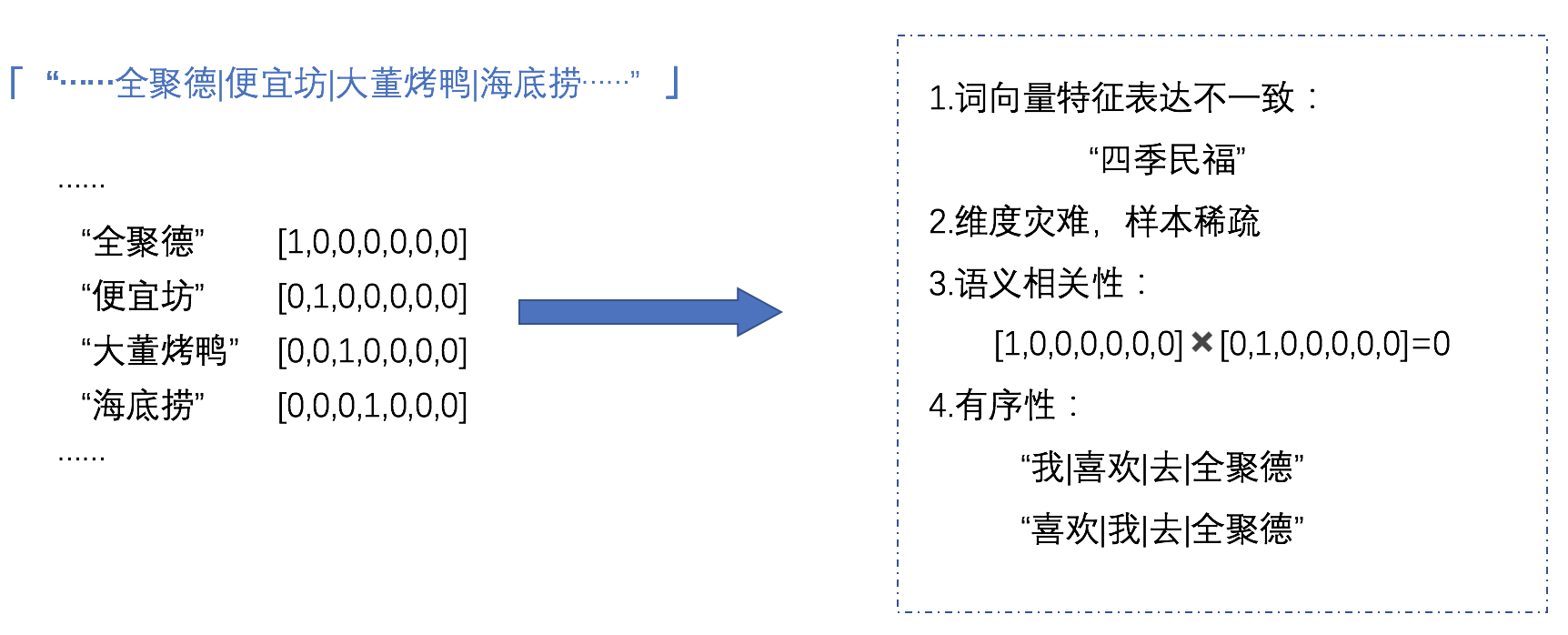

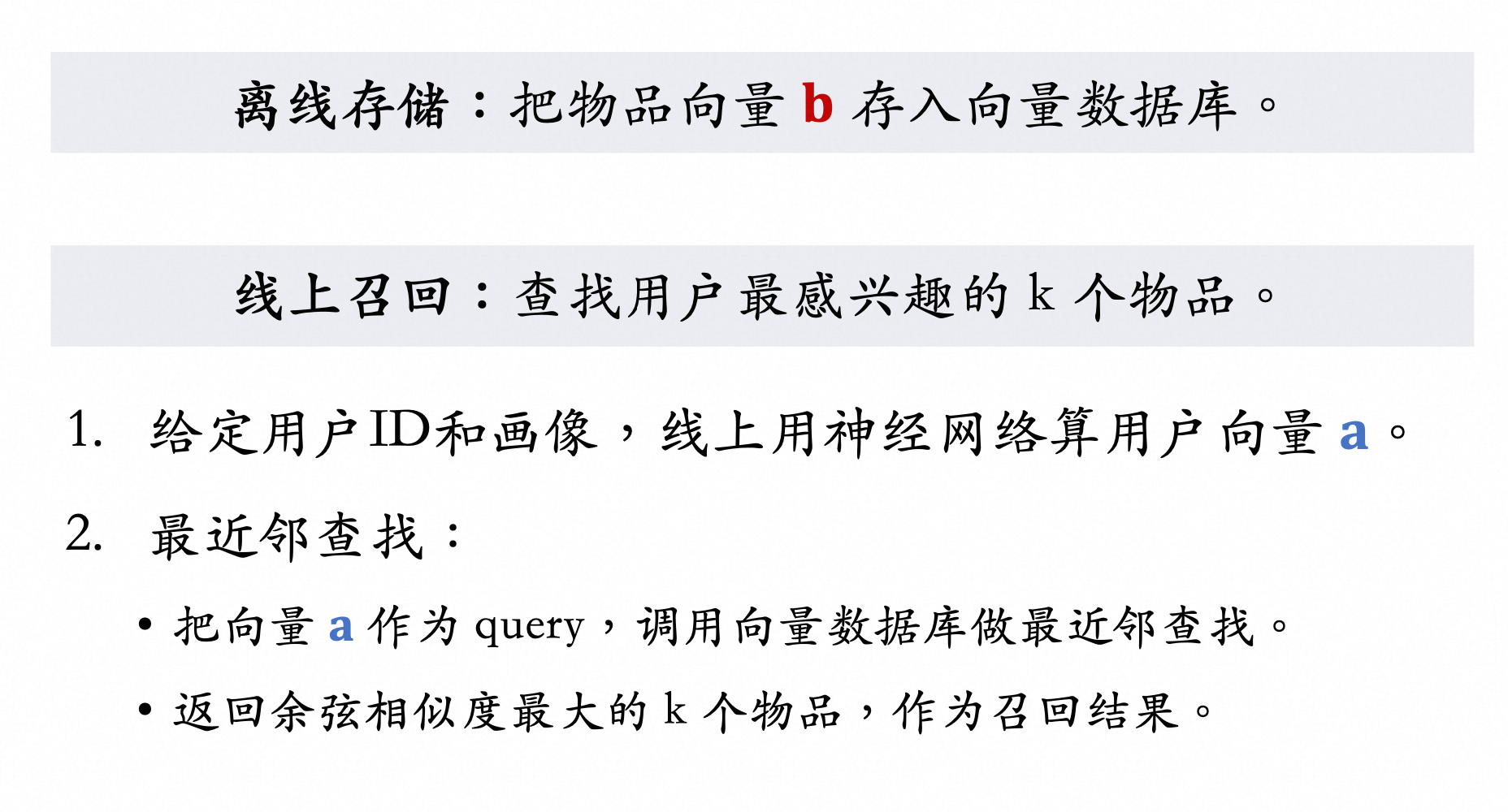

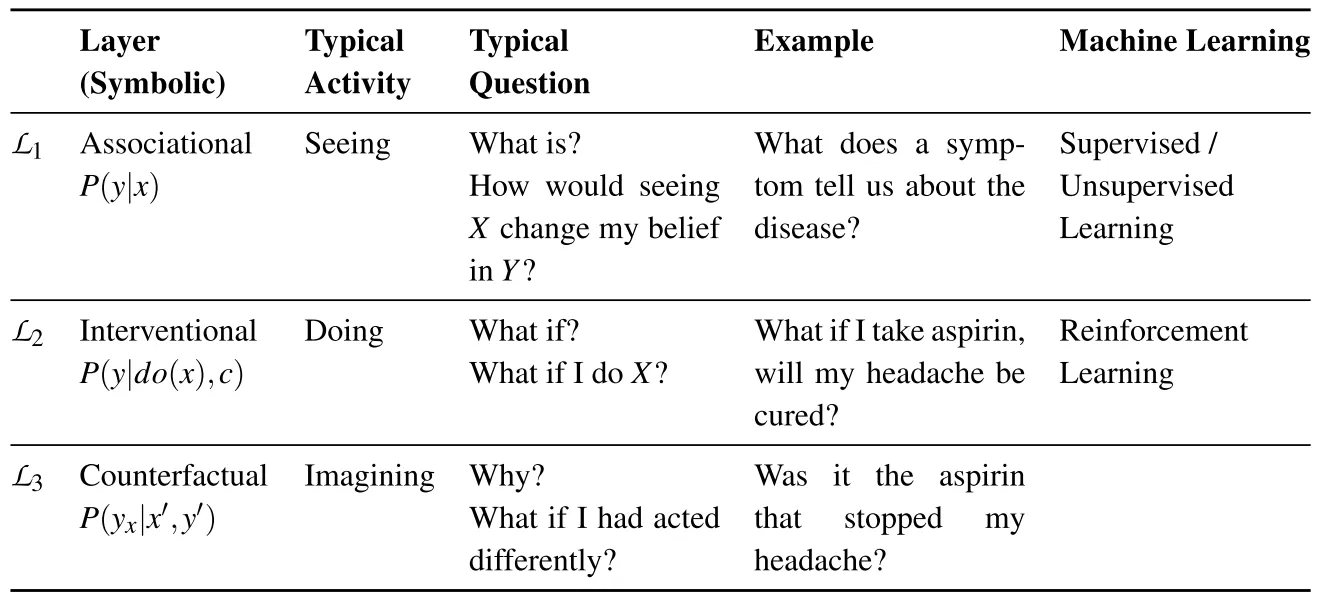

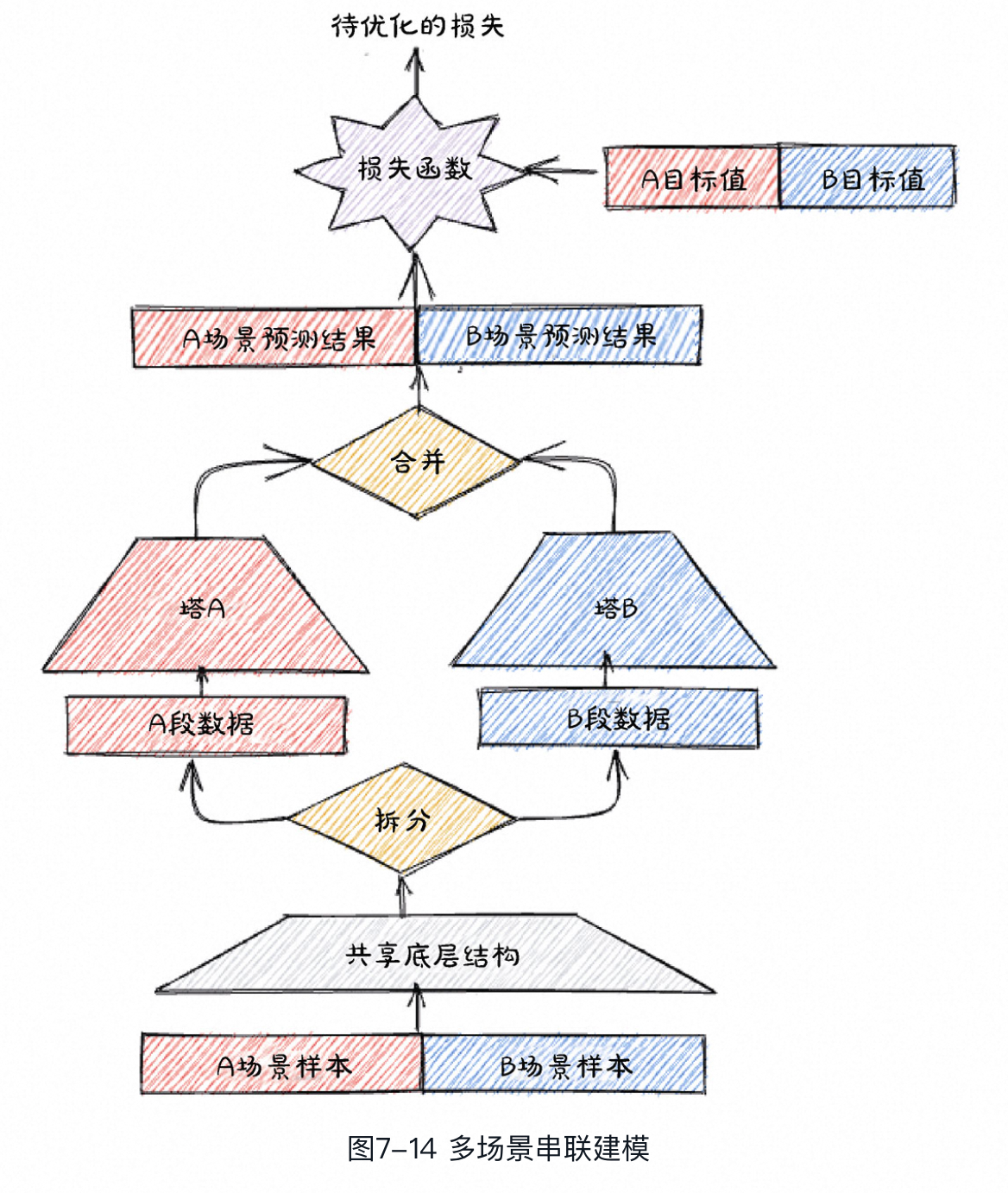

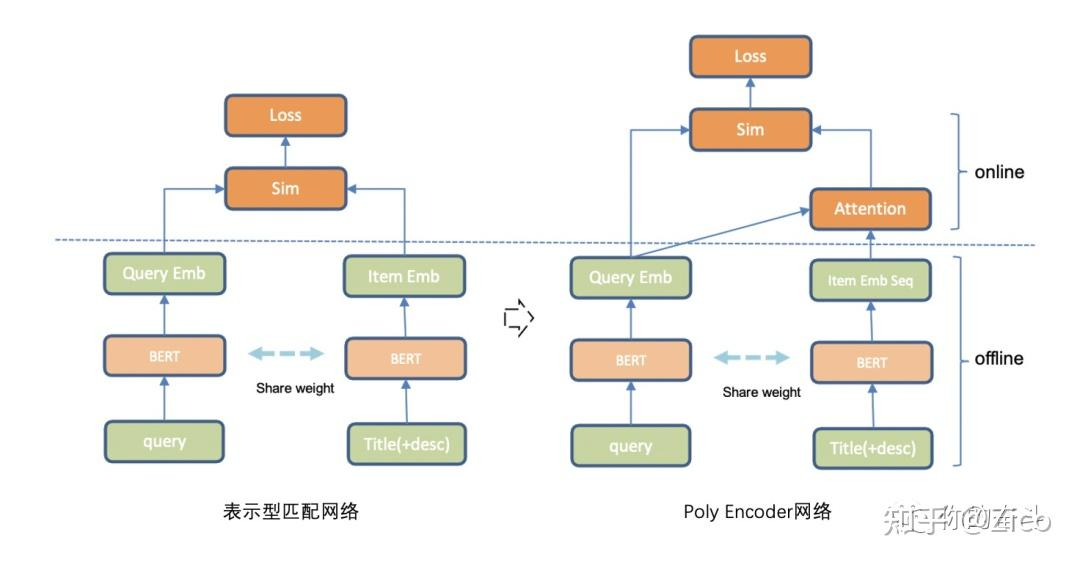

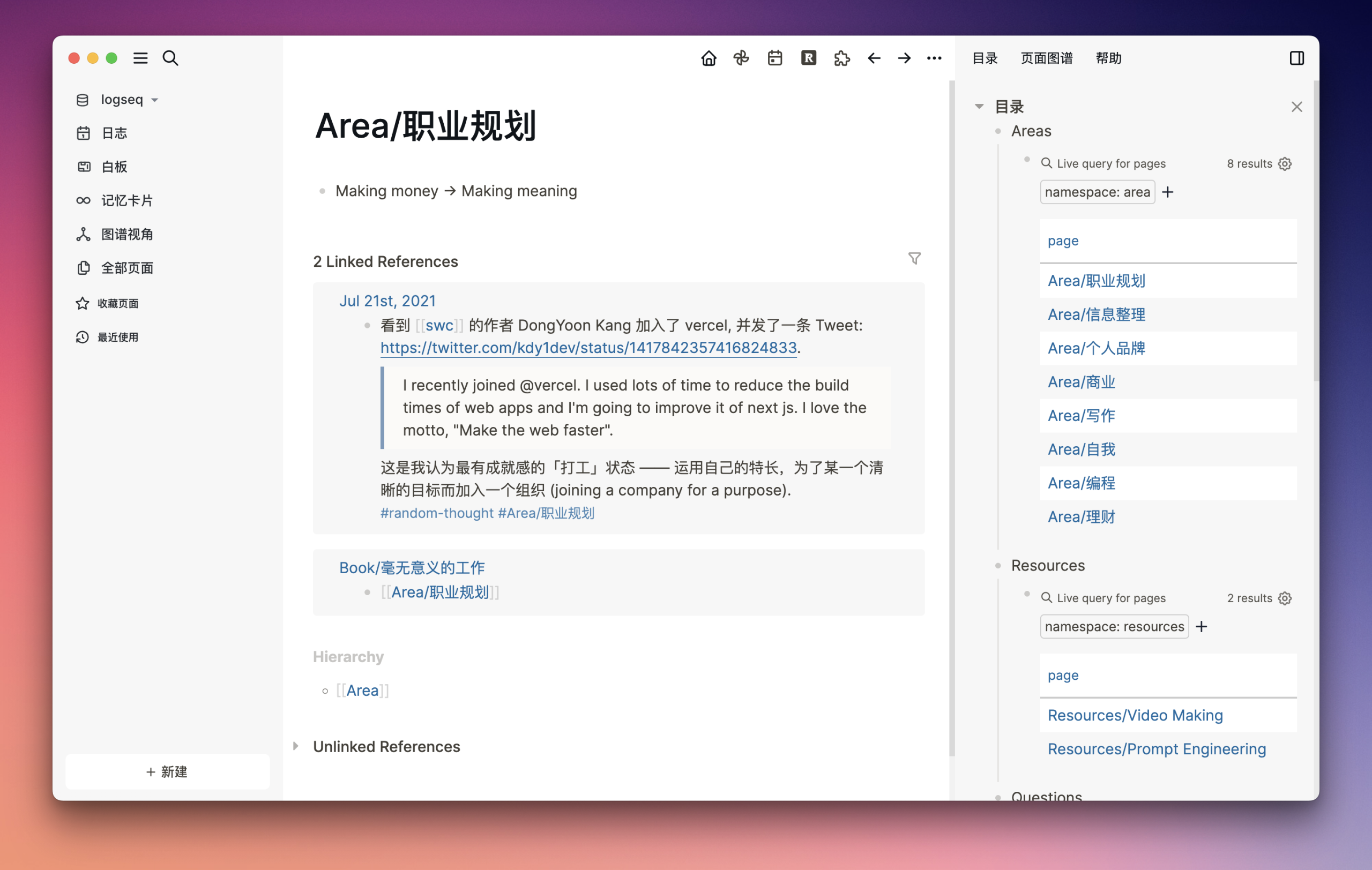

在此图中,将业务系统划分为三层架构。分别是表示层,业务层和数据库层。#card

这里业务层又通过 **DomainModel—Service—Control ** 思想解耦职责、将服务和服务控制隔离,使程序具备 高度的可重用性和灵活性。

领域模型 DomainModel

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDI4NDMxOTAzMl8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MTAzOS41MTM1NjU5ODIzODQzLCJ0b3AiOjE2OS4zNDczNzg5NDg5ODYwNiwid2lkdGgiOjE0MzYuNDExNTUwMTMwNjExLCJoZWlnaHQiOjgzLjM1MTMwOTU5MzUyNzk2LCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjEwMzYuMjk5NTA2NjEwNjY5OCwidG9wIjozMDguMTc3MDM0MTExMDA2NCwid2lkdGgiOjE0NDIuODM5NjY4ODc0MDM5NSwiaGVpZ2h0IjoxMTUuNjA2NDgxNzg2NDU4NTIsImFuZ2xlIjowLCJjSWQiOjJ9LHsibGVmdCI6MTA0MS4wMDgxMzU4MTgzMjY4LCJ0b3AiOjQ1OS4xMDA0ODIxNzA1NTMxNiwid2lkdGgiOjE0MzYuNzU0ODMxNTYyOTA3LCJoZWlnaHQiOjExMC4zNDQ0MTMwMjIzMTU4NSwiYW5nbGUiOjAsImNJZCI6M31dfX0=

事件驱动架构(EDA)是一种典型的 **异步 ** 通信架构风格,通过事件触发机制实现系统内各模块之间的解耦与异步交互。

角色

两个阶段 #card #depth-1

表决阶段(准备阶段,Voting/Prepare Phase) #card

协调者向所有参与者发送“准备提交事务”的请求。

参与者本地执行事务并记录 redo/undo 日志,但不提交。

各参与者返回“同意提交”或“中止”的表决结果给协调者。

执行阶段(提交阶段,Commit Phase) #card

如果协调者收到了所有参与者的“同意提交”,则向所有参与者发送“提交”命令,参与者正式提交并释放锁资源。

如果有任何一个参与者投“中止”,则协调者向所有参与者发送“回滚”命令,参与者执行回滚并释放锁资源。

庞大的单体应用

问题描述 #card

缺乏依赖隔离,

存在代码耦合、

模块间接口 缺乏治理、

不同模块开发发布进度难以协调、

单个模块不稳定影响整个应用等问题

解决方案 #card

单体应用“硬拆” 为微服务

问题描述 #card

过度服务化拆分会致使新架构与组织能力不 匹配,影响架构升级效果。

具体表现有小规 模软件过度拆分、服务间数据依赖、服务拆 分导致性能下降等

解决方案 #card

缺乏自动化能力的 微服务

问题描述 #card

解决方案 #card

建立完善的自动化能力,

涵盖自动化测 试、发布、环境管理等,

以适应复杂度 提升的需求

和 [[UML]] 相比 SysML 新增 :-> 需求图(Requirement Diagram)

核心功能 #card

描述服务元数据、发现服务提供者、集成现有服务[[用例图]] :-> 用于描述系统与外部用户之间的交互关系

[[活动图]] :-> 用于描述业务流程或操作逻辑,清晰展现流程控制结构

通信图、协作图

时序图、顺序图

[[类图]] :-> 用于表示静态结构和业务对象模型,

构件图 :-> 用于表示系统在实现阶段的物理结构,展示各个软件构件(如类、模块、库)之间的依赖关系。

[[uml序列图]] 和 [[uml协作图]] 对比

[[UML序列图]] 强调的是 对象交互的时间次序 。通信图强调的是 对象之间的组织结构。

当你需要清晰地展示消息的时间顺序,以及对象之间交互的时序关系时,选择 序列图 。

序列图强调的是时间顺序,它像电影胶片一样,按时间顺序展示了每个对象发送和接收消息的时刻。适用于描述复杂交互流程,特别是涉及多个对象之间消息传递顺序至关重要的场景,例如 异步操作、并发行为 等。

当你需要清晰地展示对象之间的静态关系,以及它们之间如何通过消息进行协作时,选择 协作图 。

通信图强调的是对象之间的连接关系,它像地图一样,展示了对象之间的链接路径以及消息如何在这些路径上传递。适用于描述 系统结构,以及对象之间协作关系 ,特别是需要清晰地展现对象之间静态连接关系的场景。

[[UML序列图]](顺序图)是用来显示你的参与者如何以一系列顺序的步骤与系统的对象交互的模型。#card

顺序 图可以用来展示对象之间是如何进行交互的。

顺序图将显示的重点放在消息序列上,即强调消息是 如何在对象之间被发送和接收的。

协作图,和序列图相似,显示对象间的动态合作关系。#card

序列图和协作图合称为交互图

如果强调时间和顺序,则使用 :-> 序列图

如果强调上下级关系或对象间组织结构,则选择 :-> 协作图

[[UML2.0]] 将整个 UML 规范划分为 :-> 基础结构和上层结构

基础结构是 uml 的 **元模型 ** ,它定义 :-> 了构造 UML模型的各种基本元素:

上层结构则定义了 :-> 面向建模用户的各种 UML 模型的语法、语义和表示。

UML 建模在面向对象分析与设计阶段的应用

面向对象的[[分析模型]]主要由 **顶层架构图 ** 、 用例与用例图 、 领域概念模型 构成

设计模型则包含以包图表示的软件体系结构图、以交互图表示的 用例实现图 、完整精确的类图、针对复杂对象的状态图和用以描述流程化处理过程的 活动图 等。

类图 :<-> 描述类、接口、协作及它们之间的关系

对象图 :<-> 描述对象及对象之间的关系

包图 :<-> 描述包及包之间的相互依赖关系

组合结构图 :<-> 描述系统某一部分(组合结构)的内部结构

构件图 :<-> 描述构件及其相互依赖关系

部署图 :<-> 展示构件在各节点上的部署

外廓图 :<-> 展示构造型、元类等扩展机制的结构

顺序图 :<-> 表示对象之间消息的交互,强调消息执行顺序的交互图

通信图/协作图 :<-> 展示对象之间消息的交互,强调对象协作的交互图。协作图是 UML1 的说法。

时间图/定时图 :<-> 展示对象之间消息的交互,强调真实时间信息的交互图

交互概览图 :<-> 展示交互图之间的执行顺序

活动图 :<-> 描述事物执行的控制流或数据流

状态机图 :<-> 描述对象所经历的状态转移

用例图 :<-> 描述一组用例、参与者及它们之间的相互关系

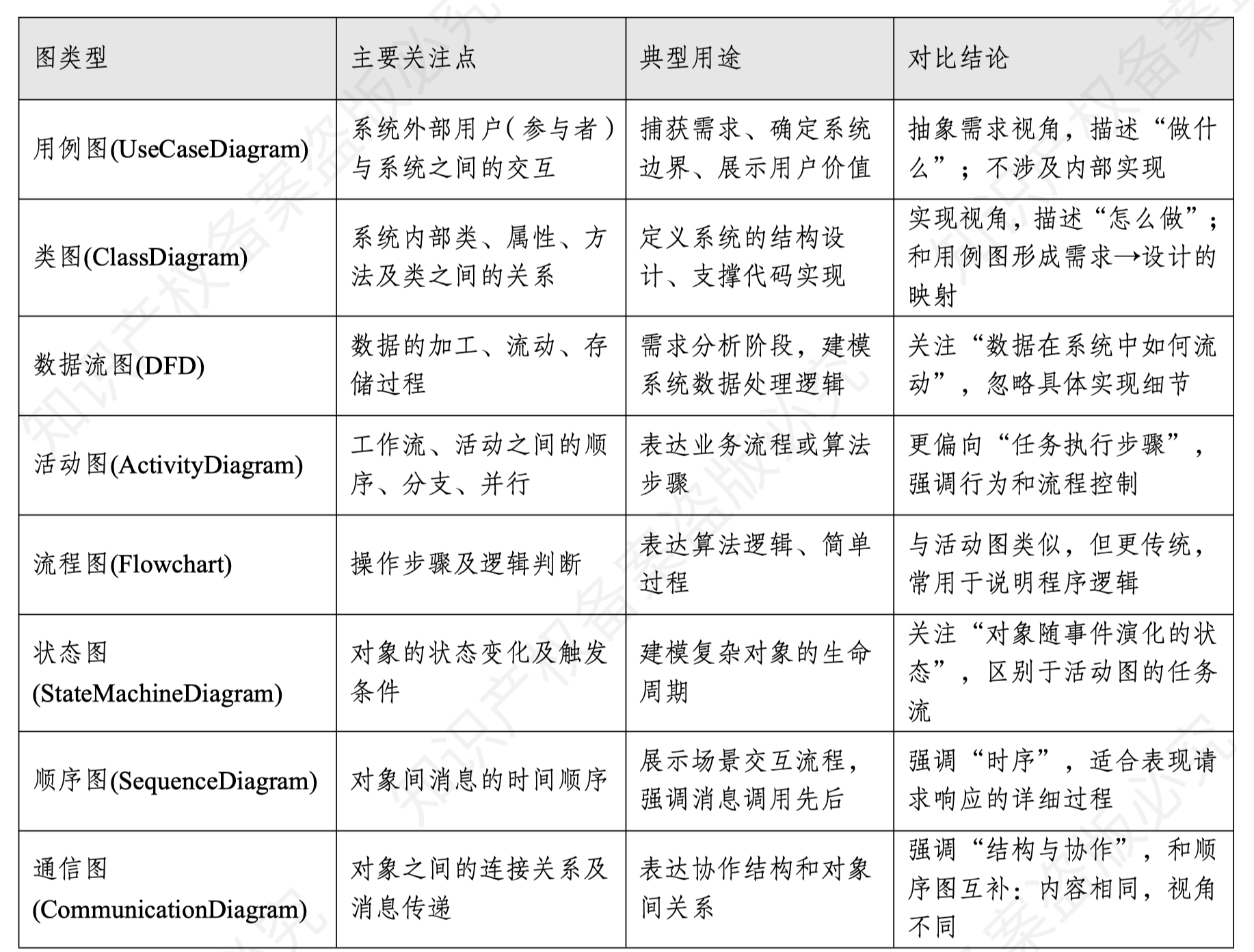

对比

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDE0MzQxNTgzNF8wLnBuZyI6eyJjb25maWciOnsiaGlkZUFsbFRlc3RPbmUiOnRydWV9LCJlbGVtZW50cyI6W3sibGVmdCI6MTE0Mi41Mzg1MTI3NjEwMTkzLCJ0b3AiOjIwOS4zOTUwMjI1MTY3NTAzLCJ3aWR0aCI6MTI2NC40NDgxNTU3NjYzNjA3LCJoZWlnaHQiOjExOC43NDM2NjkwNzA4OTQxLCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjExNDguMTg2NTA2MDkyMDI4MSwidG9wIjozNzYuMDY5NDE4NTEwNTE4LCJ3aWR0aCI6MTI3OS44MDkxOTc5MjAzNDgyLCJoZWlnaHQiOjEzOC42NDYyNzk1NDk0MjA2OCwiYW5nbGUiOjAsImNJZCI6Mn0seyJsZWZ0IjoxMTQ2LjM5MDMzMDgwNzA5NTMsInRvcCI6NTMxLjk2MDQzNDk5ODM5MzMsIndpZHRoIjoxMjkwLjA2NTgwNTY5NDIxNTIsImhlaWdodCI6MTI2Ljc5NDY4MjYyOTc2MDcsImFuZ2xlIjowLCJjSWQiOjN9LHsibGVmdCI6MTE0NC42MDE1NzI1MzMwNzI2LCJ0b3AiOjY3OC42NDc1ODQzODE4Nzc0LCJ3aWR0aCI6MTI3My42NTA1NTA2MzAyNTc0LCJoZWlnaHQiOjEyMC4wMjA1NzgzMTYzODk5LCJhbmdsZSI6MCwiY0lkIjo0fSx7ImxlZnQiOjExMzYuNTA1OTg1MDE1MDM2LCJ0b3AiOjgyMi4xMjkwMzM5OTY4MzUsIndpZHRoIjoxMjYzLjE4NDY5Njg1MDMyNTUsImhlaWdodCI6MTMyLjk4ODExNTE0MjU2NTU2LCJhbmdsZSI6MCwiY0lkIjo1fSx7ImxlZnQiOjExNTEuNjQxMzI4NjY3MDUyNCwidG9wIjo5ODMuNTIxMjA5ODgzNzc1Mywid2lkdGgiOjEyNjYuMjM1Mjk1NTY2Mjk4NiwiaGVpZ2h0IjoxNDMuNDU5ODAzNDMxMDA3NDYsImFuZ2xlIjowLCJjSWQiOjZ9LHsibGVmdCI6MTEzNS4yMjYwNzM2MDMwOTQsInRvcCI6MTE0My44MjE4ODQ2MTMzNTA3LCJ3aWR0aCI6MTI2NS43NDQ1MTk2NzQyMDk2LCJoZWlnaHQiOjExNi4xMjM3NjkyMjY3MDA5MiwiYW5nbGUiOjAsImNJZCI6N30seyJsZWZ0IjoxMTQ4LjU4NzExNTc1NzA4MDMsInRvcCI6MTMwMS44NjA1ODEyNDUzOTgsIndpZHRoIjoxMjcyLjM0MzcyMTM4NjI0MywiaGVpZ2h0IjoxNDYuNjMyNjU3NjI3NDIyMDgsImFuZ2xlIjowLCJjSWQiOjh9XX19

顺序图用来描述 对象之间的消息交互 ,其中循环、选择等复杂交互使用 序列片段 表示

对象之间的消息类型包括 #incremental #card

同步消息(sender 等待 receiver 完成)

异步消息(sender 不等待)

返回消息(receiver 处理完返回结果)

创建消息(新对象实例化)

销毁消息(对象生命周期结束)

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDA1NjAxMDAzN18wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MTMwMi4zMzQzNzk2ODUwODI3LCJ0b3AiOjEzMi40MTg3OTUwNTY5MDk2Mywid2lkdGgiOjIyOC44NDM4MjgyODM2NTYxNywiaGVpZ2h0IjoxMDMuMDMzOTU2ODM4NTI5MTksImFuZ2xlIjowLCJjSWQiOjF9LHsibGVmdCI6MTIxMS4zMzM1ODM5MTcyOTQsInRvcCI6MzE2Ljk1NTI1MDk5NDc2NDksIndpZHRoIjoyNDAuODcyNDc1OTI0MDQ1NTcsImhlaWdodCI6ODguNjAyMTg5ODUyNDY4OTIsImFuZ2xlIjowLCJjSWQiOjF9LHsibGVmdCI6MTA1Ny4zNDU1MjA0MzQxMjI4LCJ0b3AiOjQ5Mi4zMDEwOTQ5MjYyMzQ1NSwid2lkdGgiOjIzMy44OTg3MzYyNjEwNjk2NywiaGVpZ2h0Ijo4Ny41NTY3MDExNzY1MDkwMiwiYW5nbGUiOjAsImNJZCI6MX0seyJsZWZ0Ijo5NDQuNjc3NjgzNDU4Mjk1NSwidG9wIjo2NzAuNTY2MDcwMTAwNDQyMiwid2lkdGgiOjIzNC4yNzAyMTk3NjMyMTA5LCJoZWlnaHQiOjgwLjY3Mjk1MDAxNTA3MzIsImFuZ2xlIjowLCJjSWQiOjF9LHsibGVmdCI6MjM3LjQ2ODQ2NjU1NzQ2MDcyLCJ0b3AiOjEzOC4wOTQyNDQxNzEzMDg3Niwid2lkdGgiOjIyMy45MTU0NDczODQ2Mjk3MiwiaGVpZ2h0Ijo4MS42OTMxNjcyMDQzODg2NiwiYW5nbGUiOjAsImNJZCI6Mn0seyJsZWZ0IjozNDcuMDA3NDU5MTc5MTAxODMsInRvcCI6MzIyLjY5NjQwNTk3NDQzOTUsIndpZHRoIjoyMzQuODAwODU2ODIzMDcyMSwiaGVpZ2h0Ijo3Mi4xMjQ5MzQxOTA0NDg3NiwiYW5nbGUiOjAsImNJZCI6Mn0seyJsZWZ0Ijo0NzUuNDI1MDk3MjEyOTgyNCwidG9wIjo0OTAuMzcxODU1MDg4ODM4NjMsIndpZHRoIjoyMTcuOTI3MzgzOTAxNDU4NSwiaGVpZ2h0IjoxMDYuNDAwMDE3OTU5MzE0MjUsImFuZ2xlIjowLCJjSWQiOjJ9LHsibGVmdCI6NjI1Ljk4NjM3MTMzMjcwNDIsInRvcCI6NjYzLjM5NTY3NTI4MzM3MTgsIndpZHRoIjoxODYuNzYxODY0MjAxNDMxMDgsImhlaWdodCI6MTA5Ljk5ODU3Njc1NzIyNzI4LCJhbmdsZSI6MCwiY0lkIjoyfV19fQ==

常见的三类消息

[[UDDI]](Universal Description, Discovery and Integration): :<-> 是服务注册和发现机制,用于让服务提供者发布服务、让服务请求者查找服务。

[[SOAP]](Simple Object Access Protocol) :-> 是一种传输协议,用于定义消息如何通过 HTTP 传输

WSDL(Web Services Description Language) :-> 是一种基于 XML 的接口描述语言,明确规定了服务提供者提供哪些服务、请求格式、响应格式、参数类型等数据规范。

在 包含 重用形式下 :-> 一个外部对象拥有指向一个内部对象的唯一引用,外部对象只是把请求转发给内部对象

在 聚集 重用形式下 :-> 直接把内部对象的接口引用传给外部对象的客户,而不再转发请求。

DB持久化方式和AOF持久化方式在以下面有所不同:

(1)磁盘更新频率: #card

RDB方式在指定时间间隔内将内存中的数据快照保存到磁盘,

而AOF方式则实时记录每次写操作到磁盘。

(2)数据安全: #card

(3)数据一致性: #card

RDB方式在快照时刻保存数据,可能会导致部分数据丢失,

而AOF方式记录每次写操作,数据更加完整和一致。

(4)重启性能: #card

RDB方式在重启时加载快照文件,速度较快;

而AOF方式需要重新执行日志文件中的写操作,重启时间可能较长。

(5)数据文件大小 #card

AOF方式通常比RDB方式的数据文件更大,

因为AOF记录了每次写操作。

全称 :-> Representational State Transfer

REST的状态转移是借助 HTTP方法 来实现

POST :<-> 创建资源

GET :<-> 获取资源

PATCH :<-> 部分更新

PUT :<-> 资源的整体更新

URI和资源是多对多关系:这是错误的。#card

REST中的URI(统一资源标识符)用于唯一标识某一资源,虽然一个资源可能有多个URI(例如为了兼容历史系统),但一个URI只能对应一个资源。

因此,URI与资源的关系应为“多对一”或“多(URI)对一(资源)”,而不是多对多

REST是一种 设计风格 而不是一个架构

REST中的一切都是资源,设计核心是 资源的表示、标识和操作方式

核心特征

[[实时操作系统任务调度策略]]

中文 :-> 软件过程模型

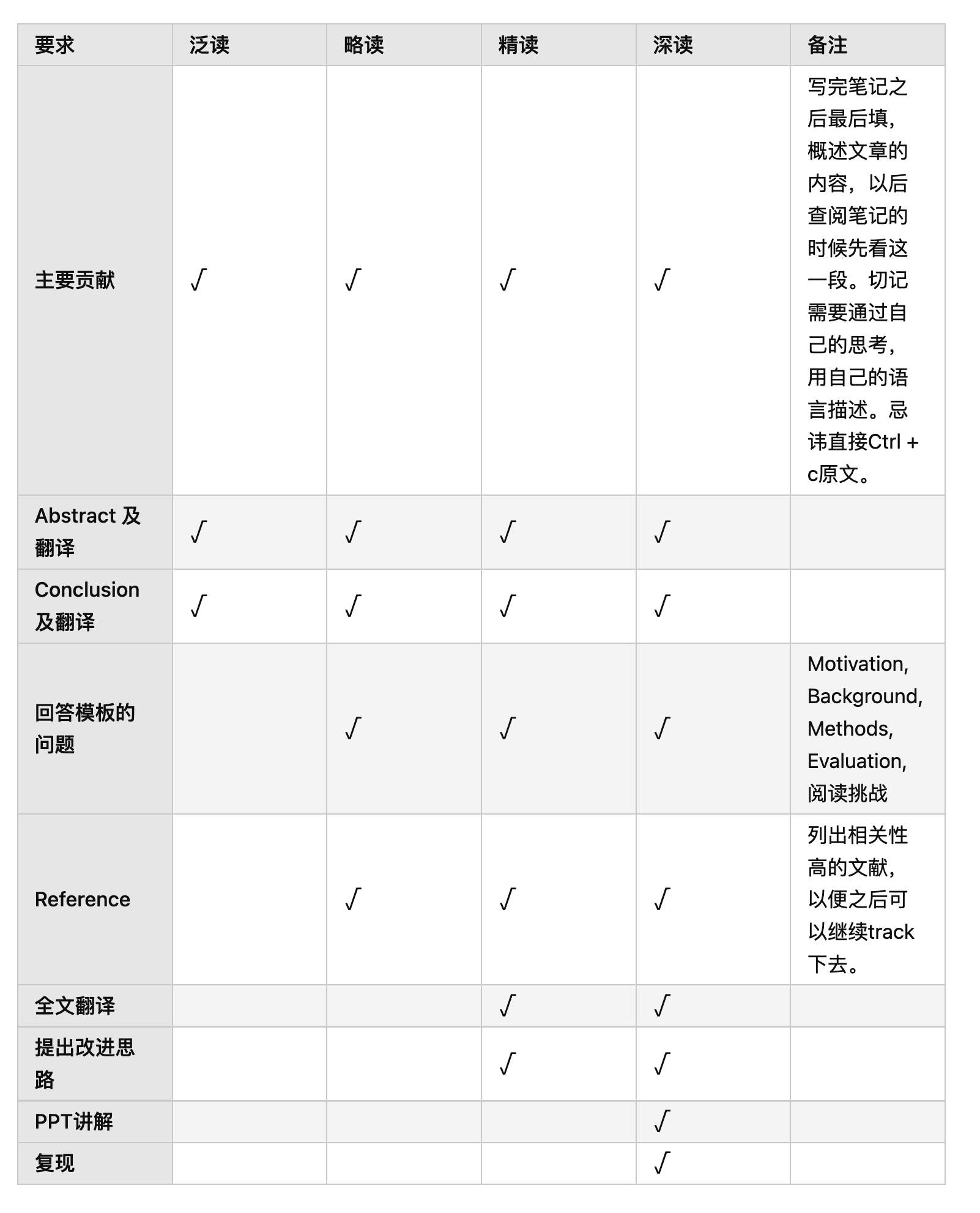

RUP 是一种软件开发过程框架,强调以下三个核心特征: #card #incremental

用例驱动(Use Case Driven) :<-> RUP 使用用例来驱动整个开发过程,贯穿需求分析、设计、实现和测试。用例帮助开发团队理解用户需求,并保持开发工作的业务一致性。

以体系结构为中心(Architecture-Centric) :<-> RUP 强调在项目早期构建系统的核心架构,架构贯穿于整个开发过程,指导系统设计和实现。

迭代和增量开发(Iterative and Incremental) :<-> RUP 采用分阶段的迭代方法,每个迭代周期交付可运行的软件版本,不断完善系统。

主要工作流

业务建模 :-> 是RUP的核心工作流之一,它关注在系统开发过程中如何理解和建模业务需求,以确保系统能够支持组织的业务目标。

配置与变更管理 :-> 配置与变更管理是RUP中的一个关键工作流,确保开发过程中版本的管理、变更的追踪以及系统各部分的同步。

环境 :-> 开发和部署软件所需的技术环境,包括开发工具、操作系统、数据库等设施的管理。

一个开发周期 #card #incremental #depth-1

初始

细化

构建

交付

同步方案 #card

Cache-Aside(旁路缓存)

读取数据时,先读取Redis中的数据,

如果Redis没有,则从原数据库中读取,并同步更新Redis中的数据。

写回时,写入到原数据库中,并同步更新至Redis中。

全称 :-> 基于场景的架构分析方法 Scenarios-based Architecture Analysis Method

主要输入是 #Card #incremental

问题描述

需求声明

体系结构描述

在进行架构评估时,首先要明确具体的 质量目标 ,并以之作为判定该架构优劣的标准。

从应用的角度定义,可以认为 SOA 是一种 应用框架 ,它着眼于日常的业务应用,并将它 们划分为单独的业务功能和流程,即所谓的服务。

从软件的基本原理定义角度,认为 SOA 是一个 组件模型 ,它将应用程序的不同功能单元 (称为服务)通过这些服务之间定义良好的接口和契约联系起来。

解耦机制

SOAP 描述了在消息传递过程中如何使用 **XML 数据 ** 进行编码,并通过 **HTTP 或 SMTP ** 等协议进行传输。

SOAP 消息由 **一个信封、头部(Header)和主体(Body) ** 组成

灾难恢复的最高级别 :-> 通过数据同步技术和自动化机制实现业务的瞬时接管和零数据损失

排序核心标准是 :-> 商业价值

交换机刚启动时没有任何 MAC 地址表项,需要通过 学习机制动态 建立。

OOA模型包括对象模型、动态模型和功能模型。

路由器(Router) 是一种连接多个网络、实现数据包路由选择与转发的设备。它的核心功能包括: #card #incremental

依据 IP地址 进行路径选择

转发数据包到目标网络

实现多个子网之间或不同网络之间的通信

路由器工作在 网络层

不同层

OSI 安全体系结构中定义的五大安全服务(ISO 7498-2)

两个主要元素 #card

实体是现实世界中可以区别于其他对象的”事件”或”物体”

联系

EJB是企业级Java构件,用于开发和部署多层结构的、分布式的、面向对象的Java应用系统。

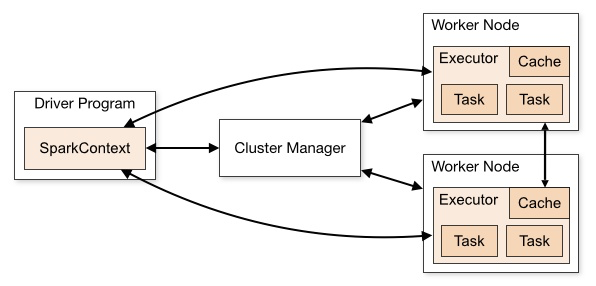

架构图 #card

基本结构图 #card

“可靠性(Reliability)”的子特性分类

Applet :<-> 运行在客户端浏览器中的 Java 程序。

Servlet :<-> 运行在服务器端,处理 HTTP 请求并生成动态内容。

JSP(JavaServer Pages) :<-> 简化 Servlet 开发的技术,最终编译成 Servlet。

EJB([[Enterprise JavaBeans]]) :<-> 封装业务逻辑的服务器端组件,提供事务管理等企业级服务。

Application Client :<-> 运行在独立客户端,能直接访问 EJB 和其他 J2EE 服务的 Java 应用程序。

JDBC(Java Database Connectivity) :<-> Java 访问关系型数据库的标准 API,能够与遗留系统中的数据库部分集成。

JCA(Java Connector Architecture) :<-> JavaEE 与企业信息系统(EIS)之间的标准连接架构,EIS 包括遗产系统,可直接实现对其访问与集成。

Java IDL(Interface Definition Language) :<-> 在 Java 环境中进行 CORBA 编程,实现不同语言编写的遗产系统与 JavaEE 应用互操作。

JMS :<-> 主要用于 Java 应用之间的异步消息传递,不是遗产系统集成的核心技术

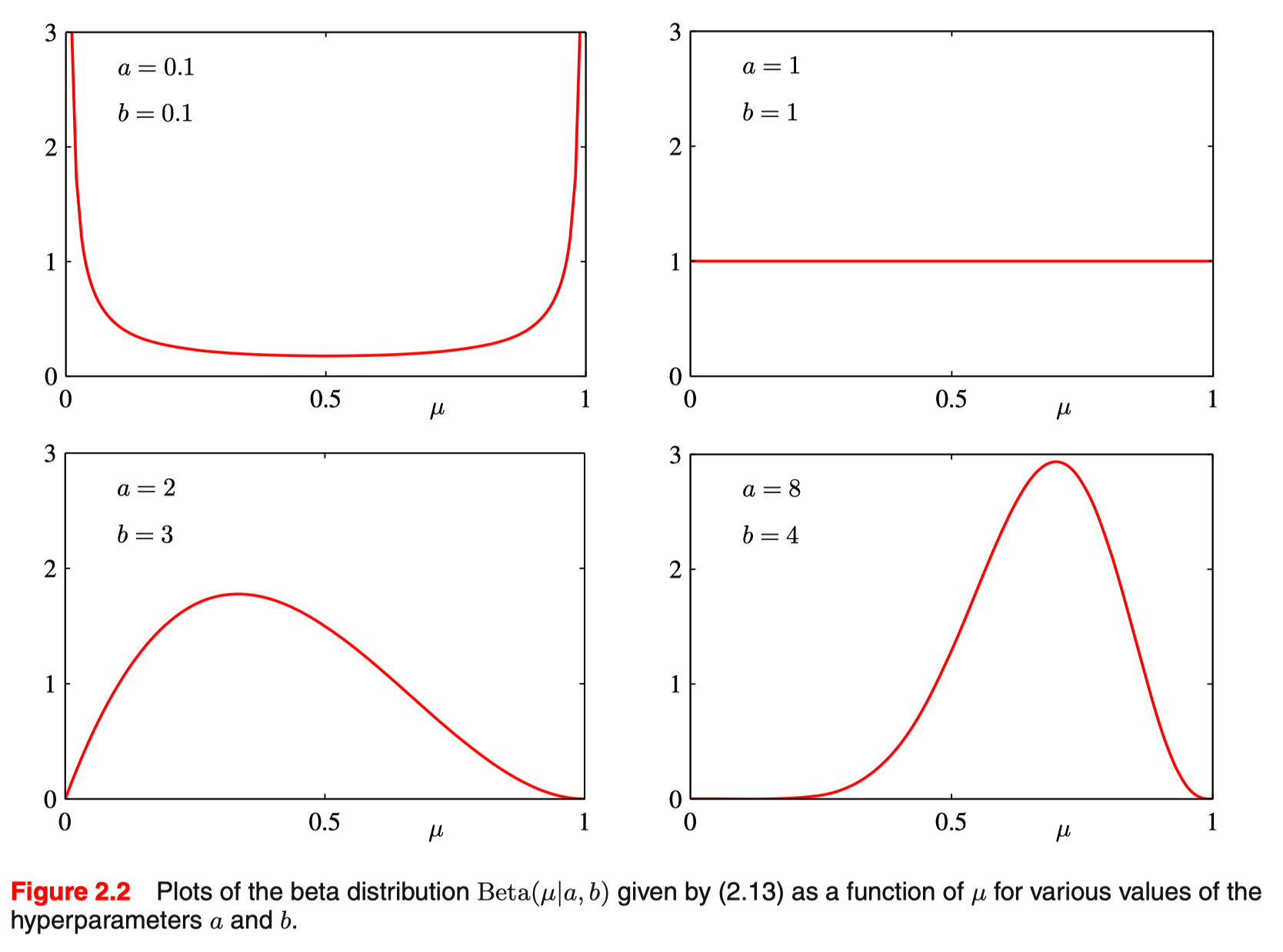

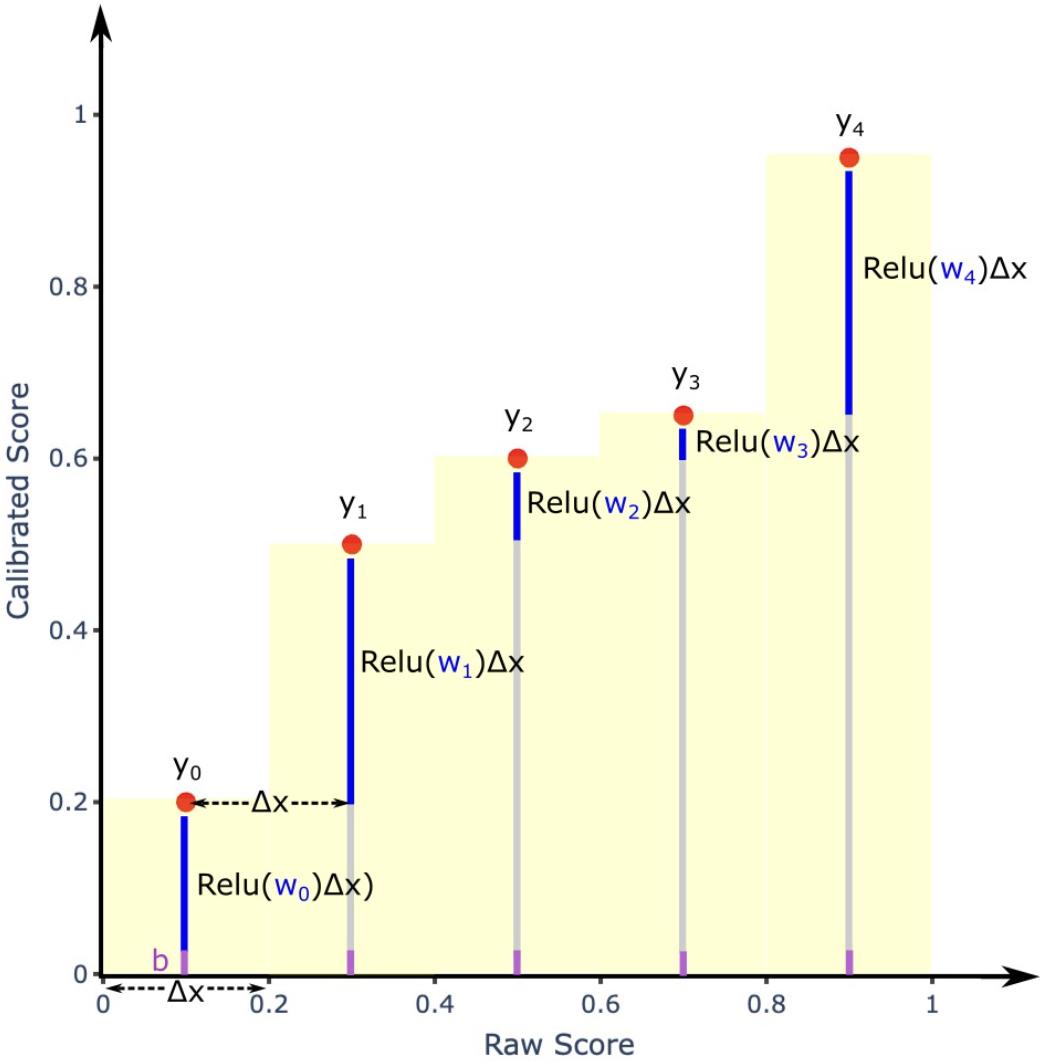

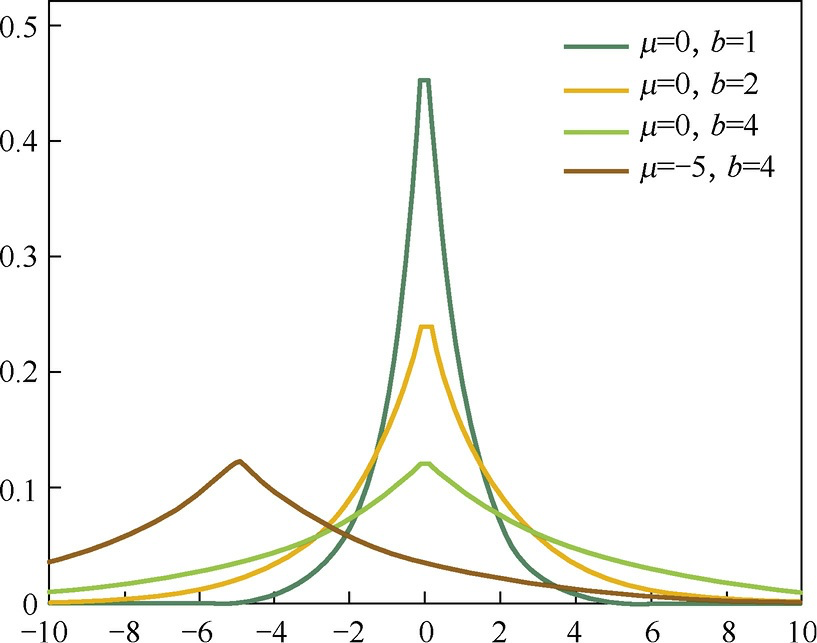

[[概率密度函数]] #card

$\operatorname{Beta}(\mu \mid a, b)=\frac{\Gamma(a+b)}{\Gamma(a) \Gamma(b)} \mu^{a-1}(1-\mu)^{b-1}$

$\Gamma$ 是 [[gamma函数]]

期望 #card

$\mathbb{E}[\mu]=\frac{a}{a+b}$

方差 #card

$\operatorname{var}[\mu]=\frac{a b}{(a+b)^2(a+b+1)}$

和 [[二项分布]] 的区别 #card

二项分布对成功次数 x 进行建模

beta 分布对成功概率 p 进行建模

随着 $\alpha$ 的增加(成功事件增多),概率分布的大部分将向右移动。

另一方面,$\beta$ 的增加会使分布向左移动(更多失败事件)。

同样,如果我们同时确定 $\alpha$ 和 $\beta$ 都增加,则分布将变窄。

例子 [[@PRML Note 前十一章]] 2-006

ls-type:: annotation

hl-page:: 62

hl-color:: purple

以及 ((654bb13c-db71-49d4-ad0e-123ec812c258))

[[二项分布]] 概率函数

结合 Beta 先验分布,根据[[贝叶斯公式]]后验分布有

$\begin{aligned} p(\mu \mid m, N, a, b) & \propto p(m \mid N, \mu) p(\mu \mid a, b) \ & =C_N^m \mu^m(1-\mu)^{N-m} \frac{\Gamma(a+b)}{\Gamma(a) \Gamma(b)} \mu^{a-1}(1-\mu)^{b-1} \ & \propto \mu^{m+a-1}(1-\mu)^{N-m+b-1}\end{aligned}$

n 和 m 都是已知

超参数 a 和 b 是先验中时间发生的次数和不发生的次数,a+b就是有效观察次数

根据这个公式可以看出先验对后验的影响

根据 $p(\mu \mid m, l, a, b)=\frac{\Gamma(m+a+l+b)}{\Gamma(m+a) \Gamma(l+b)} \mu^{m+a-1}(1-\mu)^{l+b-1}$ 后验分布也服从 Beta 分布

得到事件发生的概率期望等于事件发生次数除以总次数

+ 二项分布中 $p(x=1 \mid D)$ 预测的分布就是 $\mathrm{E}[\mu \mid D]$

+ $p(x=1 \mid D)=\mathrm{E}[\mu \mid D]=\frac{m+a}{N+a+b}=\frac{m+a}{m+a+l+b}$

+ l = N-m,后验中时间不发生的次数

+ 次数增加,m 和 N 值会变大,当趋于无穷时,a 和 b 可以忽略。

+ 试验次数少,受先验影响大,反之相反。

+ 试验次数多到一定程度后,先验几乎没有影响,后验估计和极大似然估计趋于一致。

2-008

ls-type:: annotation

hl-page:: 63

hl-color:: purple

[[Bayesian Online Learning]] ((654e45e1-d673-4eeb-806f-9334ee4ee3d9))

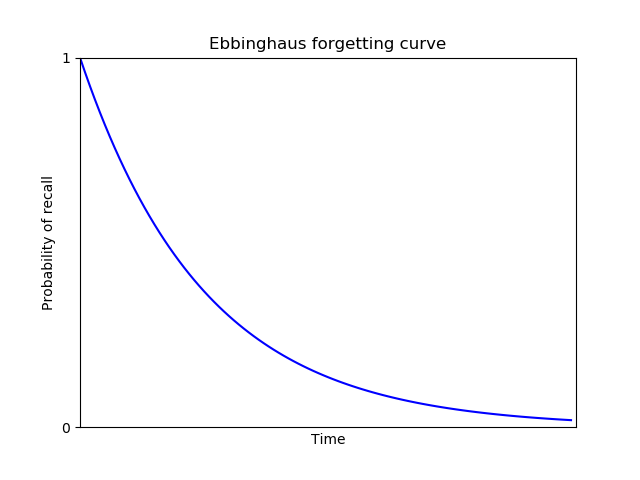

a和趋于无穷时,u 的方差趋于 0。对应试验次数越多,u 的取值越集中,不确定(方差)越小。#card

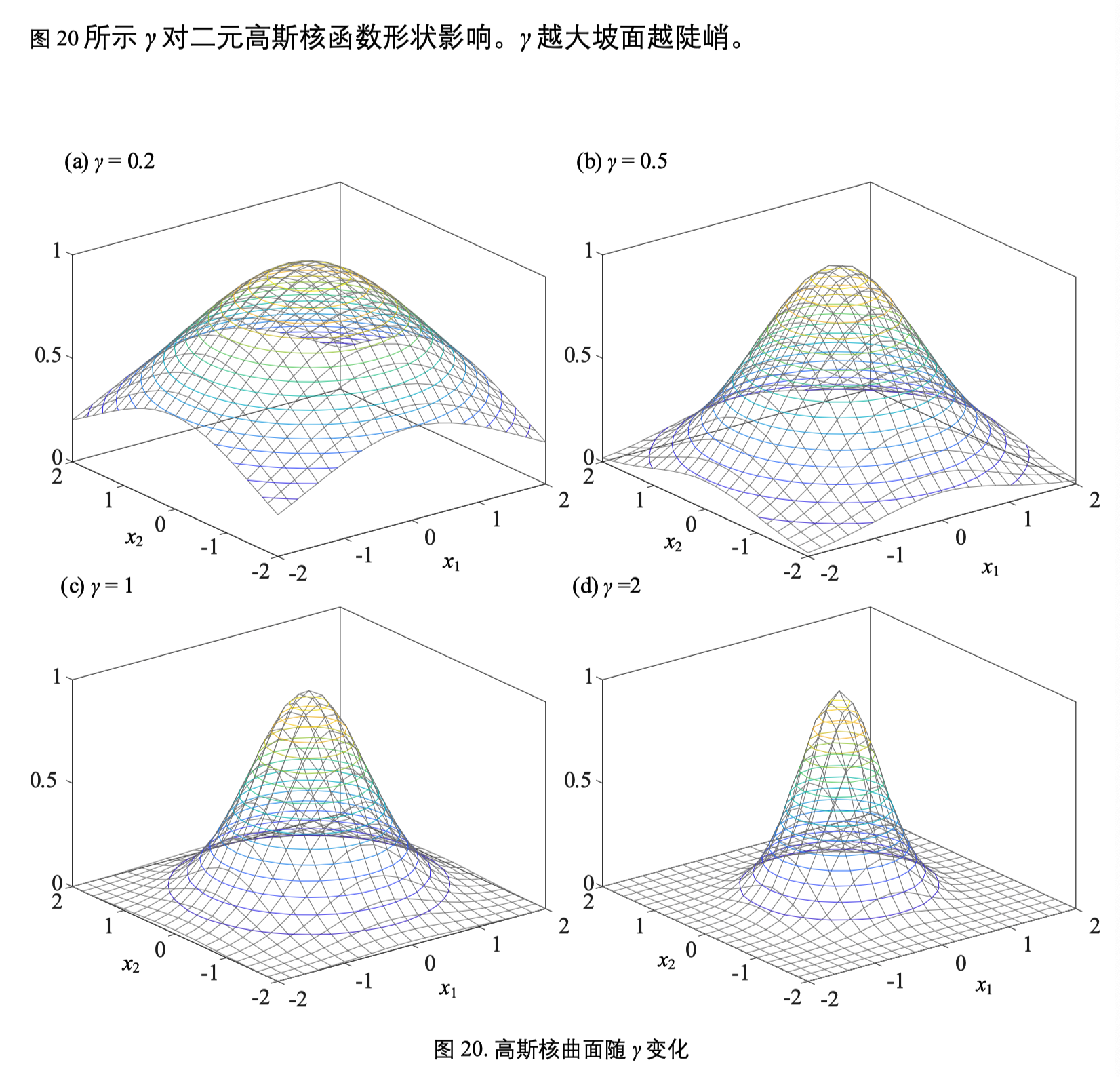

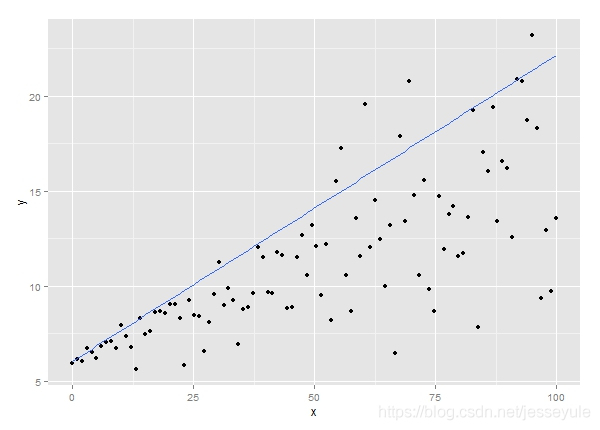

+ 下图是 beta 分布概率密度曲线

+ #card [\[\[试验次数和后验分布的关系\]\]](/post/logseq/%E8%AF%95%E9%AA%8C%E6%AC%A1%E6%95%B0%E5%92%8C%E5%90%8E%E9%AA%8C%E5%88%86%E5%B8%83%E7%9A%84%E5%85%B3%E7%B3%BB.html) 随着试验次数的增加(数据集的变大),未知参数的取值越来越集中?

ls-type:: annotation

hl-page:: 63

hl-color:: yellow

+ 随着试验次数的增加,后验分布的不确定性会越来越小?

ls-type:: annotation

hl-page:: 63

hl-color:: yellow

+ 答案是:在一般情况下,理论上的确有这样的趋势,但对于某些特定的数据集则不一定。

ls-type:: annotation

hl-page:: 63

hl-color:: yellow

[[@例子:概率的概率]]

[[不同 beta 分布形状]]

基本组成 #card #incremental

组件

连接器

消息

体系文件层次结构 #incremental #card

顶层方阵 :<-> 用于制定质量管理的总体目标和方向,为下级文件提供指导原则

过程文件 :<-> 描述各个过程域的具体活动、步骤和职责,是体系运行的主要依据

规程文件 :<-> 对过程文件中的某些步骤进行细化,提供具体的执行规则和标准

模板类文件 :<-> 用于规范相关文档和记录的格式,如 Word 模板、Excel 表格等,是实际操作的工具支持。

CMMI 将组织的软件过程成熟度分为五个等级:

初始级(Level 1) :<- 流程随意、混乱,依赖个人能力和英雄主义精神。

已管理级(Level 2) :<-项目层面的流程被规划、文档化、执行、监控和控制,能满足成本、进度和质量目标。

已定义级(Level 3) :<-组织层面形成了标准化、制度化的管理流程,并根据自身特点进行定义;开始收集项目的经验资产,确保过程一致性。

量化管理级(Level 4) :<-建立产品质量、服务质量和过程性能的定量目标,能够预测和控制过程性能。

优化级(Level 5) :<-通过持续的增量式和创新式改进,利用多个项目收集的数据优化过程性能。

可移植对象适配器 POA :-> 协调调用请求与服务实现之间交互的关键组件

两层 C/S 架构只有 表示层(客户端)和数据层(数据库服务器) 两层

三层 CS 架构 #card #incremental

表示层、用户界面层

数据层

应用服务器、功能层、业务逻辑层

表示层、用户界面层作用 :-> 通常部署在客户端,负责展示数据和接收用户输入。

在三层结构中,表示层驻留在 客户端 ,功能层在 中间的应用服务器上 ,数据层在 后端数据库服务器上 。

一个数据管理能力成熟度模型,共包括 8 个核心能力域,细分为 28 个过程域和 445 个能力等级标准。

企业数据管理能力根据成熟度被划分为 5 个等级 #card #incremental

初始级(1级)

受管理级(2级)

稳健级(3级)

量化管理级(4级)

优化级(5级)

8 个核心能力域包括#card #incremental

数据战略

数据治理

数据架构

数据应用

数据安全

数据质量

数据标准

数据生存周期

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDA1NzUwMzk5MV8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MTYyNy45ODYwMDI4NTQyNDU3LCJ0b3AiOjM3OS4zMDEyODIxNzkxNjk5LCJ3aWR0aCI6Mjk0LjAwMTMxNjMxMTAxMDksImhlaWdodCI6NDYwLjAwNDU2NzY2MTM3NjU0LCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjEwMTMuNDkxMjkzMzU2ODgyOCwidG9wIjozODguNjUyMTUwNDAzNzc5MDUsIndpZHRoIjo4NTAuOTg3NzI2NTk0ODU1MiwiaGVpZ2h0Ijo0ODkuMzAzMzA3ODM3NjkzMiwiYW5nbGUiOjAsImNJZCI6Mn0seyJsZWZ0IjozMDIuOTkwMDY2NTkwODM4NywidG9wIjozODUuNjUxMzc1ODg3Mjg0NjQsIndpZHRoIjo1MTkuOTgyMzM1OTg3ODU4NywiaGVpZ2h0Ijo0NzkuMzA0Njk3OTk1NTAzNiwiYW5nbGUiOjAsImNJZCI6M31dfX0=

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc2MDA1NzU1NjkwOF8wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MTk5LjY2MTU2OTA4MzU1NCwidG9wIjoyMjMuNDQxMjI5NTAzNDc0NjMsIndpZHRoIjozNDIuODgwMjM4NDQ0ODE4OSwiaGVpZ2h0Ijo0MjEuMDE3ODkyNDg4OTA5NSwiYW5nbGUiOjAsImNJZCI6MX0seyJsZWZ0Ijo1MjkuNzc0MjA5ODQ2MzYwNSwidG9wIjoyNTYuMjA4NzU3NjkwNzYxMywid2lkdGgiOjI2OS4zMjM2MTI4ODY1OTk3LCJoZWlnaHQiOjM0Mi4xNTI2OTc0NTg1NTgzNSwiYW5nbGUiOjAsImNJZCI6Mn1dfX0=

在数据流图(DFD)中,如果一个过程产生B数据或C数据,但不能同时产生B和C数据,这种逻辑选择通常使用哪个符号表示 #card

DHCP 是 :-> 一种在 TCP/IP 网络中自动分配 IP 地址及其他网络配置参数的协议,减少人工配置的复杂性。

采用的经典架构是 哈佛结构

ACID 原则

基于体系结构的软件开发模型

6 个过程 #card #incremental

体系结构需求、

体系结构设计、

体系结构文档化

体系结构复审

体系结构实现

体系结构演化

在架构复审过程中,主要由(__)决定架构是否满足需求、质量需求是否在设计中得到体现。 #card

用户代表关注系统是否满足需求,

领域专家关注领域知识与系统设计是否吻合

**体系结构文档化 ** 过程的主要输出结果是 体系结构规格说明 和 测试体系结构需求的质量设计说明书 。

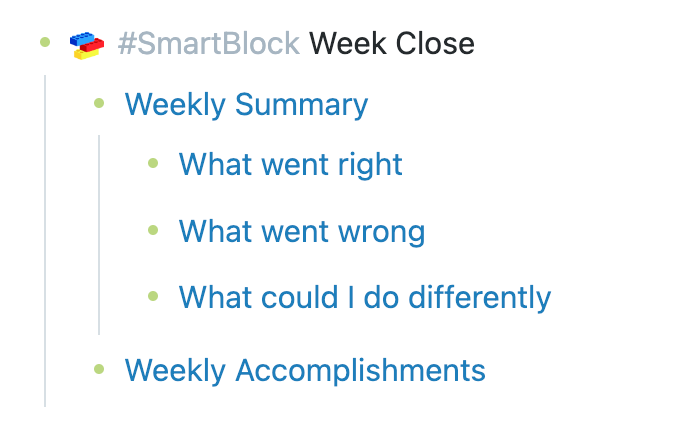

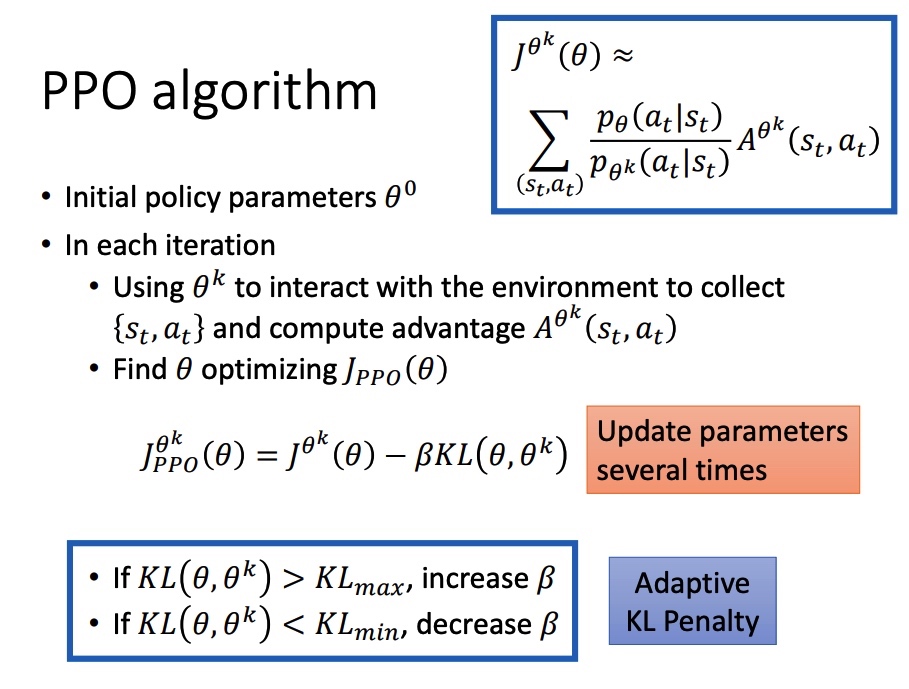

ATAM(Architecture Tradeoff Analysis Method,架构折中分析法)是由SEI提出的一种系统架构评估方法

重点关注的四个属性 #card

核心特征之一就是使用“[[质量属性效用树]]”,它用于:#card #incremental

对多个质量属性进行分类与排序;

将高层次质量目标逐层细化为具体的场景;

结合重要性与实现难度,辅助分析架构设计的取舍点(即“折中分析”)。

通过利益相关者头脑风暴方式识别关键场景,这些场景用于评估系统架构在满足质量属性需求(如性能、可用性、可维护性等)方面的能力。典型的三类场景包括

用例场景(Use Case Scenario) :<-> 源自最终用户的真实操作,用于验证系统是否满足其核心业务功能。

增长情景(Growth Scenario) :<-> 用来模拟系统未来可能发生的变化,例如扩展、升级等,体现架构的可扩展性与可演化性。

探索性场景(Exploratory Scenario) :<-> 用于挑战架构极限,例如极端负载或极端故障情形,测试系统鲁棒性与适应能力。

活动阶段 #card #incremental

需求收集

架构视图描述

属性模型构造和分析

架构决策与折中

推理规则

无损分解

设关系模式 R<U,F>,其中 U 为属性集,F 是 U 上的一组函数依赖,则有:

① A1自反律 :<-> 若 Y⊆X⊆U,则 X→Y 为 F 所蕴含;

② A2增广律 :<-> 若 X→Y为 F 所蕴含,且 Z⊆U,则 XZ→YZ 为 F 所蕴含;

③ A3传递律 :<-> 若 X→Y,Y→Z 为 F 所蕴含,则 X→Z 为 F 所蕴含。

根据上面三条推理规则,又可推出下面三条推理规则:

逻辑数据模型设计过程 #card

1)确定数据模型

(2)将E-R 图转换成为指定的数据模型

(3)确定完整性约束

(4)确定用户视图

[[超类实体]]是 :-> 将多个实体中相同的属性组合起来构造出的新实体。

[[派生属性]]是 :-> 指某个实体的非主键属性由该实体其他非主键属性决定,不必单独存储,通过计算得出的属性

问题一

1 a

2 b

3 c d

4 f g

5 e

问题二

为什么选择 RDB 方式 #card

问题三

[[Redis]] “定期删除+惰性删除”策略 #card

Redis 的过期键(Expired Keys)是自动删除的,Redis 会在每个键的过期时间秒数到达时检查该键是否过期,如果是,它会自动从 Redis 中删除该键。

Redis 内部通过使用时间轮算法和惰性删除方法来实现过期键的删除。

具体来说,过期键的定期删除策略由redis.c/activeExpireCycle函数实现,每当Redis的服务器周期性操作redis.c/serverCron函数执行时,activeExpireCycle函数就会被调用,它在规定的时间内,分多次遍历服务器中的各个数据库,从数据库的expires字典中随机检查一部分键的过期时间,并删除其中的过期键。然后,Redis 会启动一个后台线程,使用惰性删除方法来删除已过期的键。

惰性删除指的是,当需要访问一个键时,Redis 判断该键是否过期,如果过期就立即删除。

[[Redis]] “定期删除+惰性删除”策略失效场景 #card

是指”定期删除”没删除KEY,”惰性删除”也没生效。

因为大量过期的key在定期删除策略下没有及时删除 + 外部在这段时间内没有要查询这个key的动作,导致无法做惰性删除,所以还占用着内存。

[[Redis]] 内存淘汰机制 #card

(1)从已设置过期时间的数据集最近最少使用的数据淘汰。LRU

(2)从已设置过期时间的数据集将要过期的数据淘汰。

(3)从已设置过期时间的数据集任意选择数据淘汰。

(4)从数据集最近最少使用的数据淘汰。LFU

(5)从数据集任意选择数据淘汰。

常见的反规划化设计方法

(1)增加冗余列:#card

(2)增加派生列:#card

(3)重新组表:#card

(4)分割表:#card

反规范化解决数据不一致问题的方法

定期同步更新:#card

触发器同步:#card

应用程序级同步:#card

该医药销售系统,药品数据更新频繁,采用触发器法和应用程序校验较合适。#card

其中 ZSet(有序集合) 最适合实现热销药品排名 #card

因为它可以通过 score 存储销量,并且支持自动排序、区间查询,非常契合排行榜场景。

例如:ZINCRBY sales 1 drugID 可以为某药品销量加 1,然后通过 ZREVRANGE 获取销量前 N 的药品。

解决 Redis 和 MySQL 数据实时同步问题的方案 缓存与数据库的数据一致性

基于 Binlog 异步同步 。#card

用 Canal 等工具监听 MySQL 的 Binlog 日志,解析数据变更事件并推送到 Redis。

对应用透明,能捕获多种操作,可靠性高,但有延迟,部署复杂。

适用于高频写且要求最终一致场景。

应用层双写。#card

业务代码中同步写 MySQL 和 Redis,靠事务保证原子性。强一致、低延迟,但双写增加耗时,事务处理复杂。

适用于低频写、强一致场景 。

消息队列解耦。 #card

写 MySQL 后发消息到队列,消费者异步更新 Redis。

可解耦、削峰填谷,但有秒级延迟和消息堆积风险。

适用于高并发写、允许短暂不一致场景。

延迟双删。#card

更新 MySQL 前后各删一次 Redis 缓存。

简单有效,能减少不一致窗口,但极端并发下仍可能有脏数据。适用于读多写少、对一致性要求不苛刻场景。

结合数据库触发器。#card

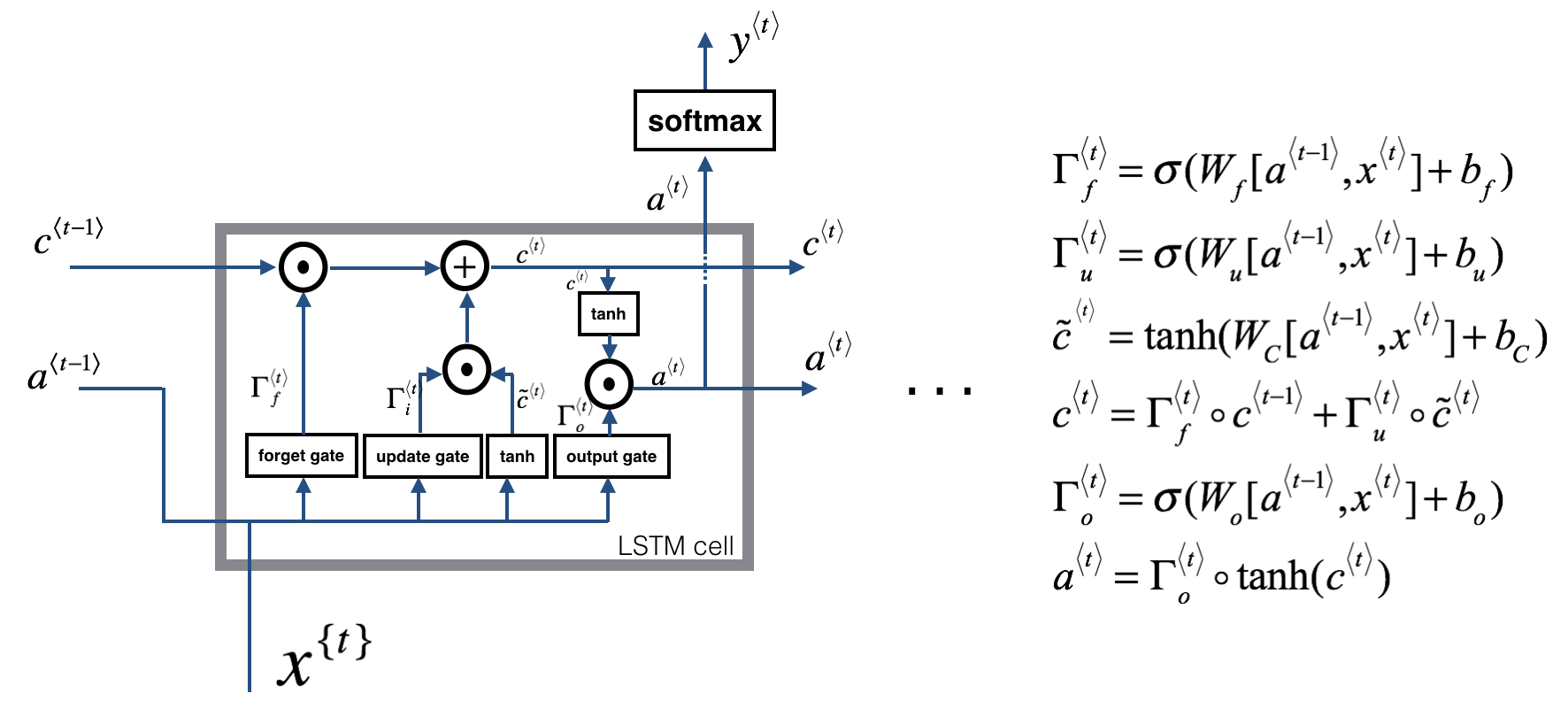

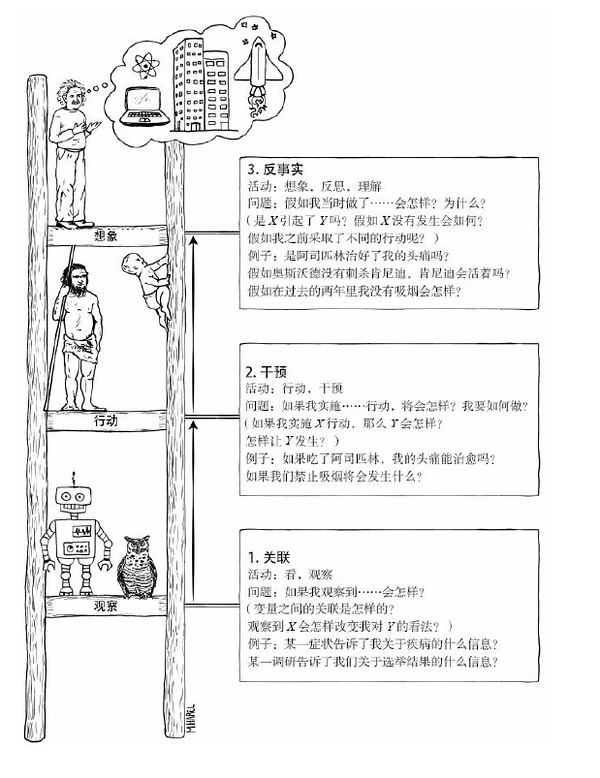

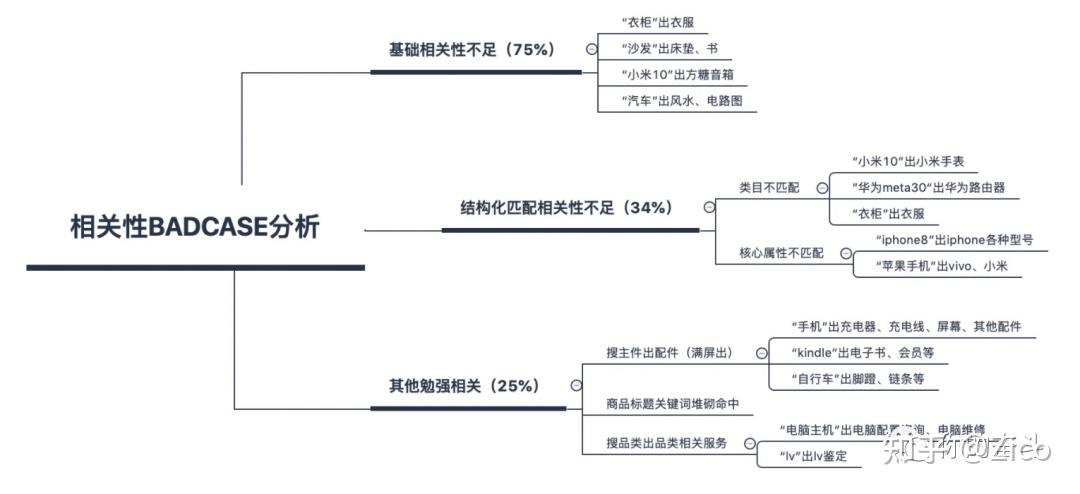

Kruchten在1995年提出了一个”4+1”的视图模型。

“4+1”视图模型从5 个不同的视角来描述 软件架构

每个视图只关心 系统的一个侧面

5 个视图结合在一起才能反映 软件架构的全部内容

“4+1”的视图模型组成 #incremental #card #depth-1

过程视图 :<-> 用于捕捉设计的并发和同步特征

逻辑视图 :<-> 主要描述系统的功能需求和实现,即类、对象等设计元素的组织结构

开发视图 :<-> 关注代码的组织方式,如模块、包等,属于静态组织结构

物理视图、部署视图 :<-> 描述软件组件在硬件上的映射

系统软件单元如何映射到硬件资源上,包括节点之间的连接、部署架构、物理拓扑结构等。

它体现了系统在物理硬件层面的分布式部署,是“软件→硬件”的直接映射。

场景视图、用例视图 :<-> 用于描述系统如何满足用户需求

问题一

难度大,针对特定应用系统设计。符合关系模式

格式灵活,冗余大。多个文件中复制相同的数据属性

以文件为中心组织、管理数据。以应用系统为中心

方便在不同应用系统之间共享,应用中按指定方式连接数据库即可

问题二

非关系模式, kv 模式

通过sql语句读写,性能较高

基于内存存储,容量比较小

可靠性不高,断电会消失。虽然有恢复机制,但并不是所有故障都能恢复。

5 关系山书库

6 关系数据库

7 内存数据库

8 内存数据库

9 内存数据库

问题3

1提升

2 降低

3 降低

4 提升

MemCache 存在的数据可靠性和一致性问题描述 #card

(1)MemCache没有持久化功能,所以掉电数据会全部丢失,而且无法直接恢复,这存在可靠性问题。

(2)MemCache不支持事务,所以操作过程中可能产生数据的不一致性。

原方案采用“写缓存再写数据库”或“写数据库再写缓存”,看似能保证缓存与数据库的数据一致,但实际上存在双写不一致问题。#card

例如,先写缓存后写数据库时,如果缓存写成功而数据库写失败,会导致数据不一致;反之,若先写数据库再写缓存,缓存更新失败时也会造成矛盾。

此外,当多个请求同时发生时,可能出现读写冲突,即一个请求刚写数据库但缓存未更新,另一个请求却从缓存读到旧数据,造成脏读。这些问题说明,双写方案并不能彻底解决一致性。

[[缓存淘汰机制]](Cache-Aside Pattern) #Card

读操作:优先从缓存读,若未命中,则从数据库读并更新缓存;

写操作:先写数据库,再删除或使缓存失效。

这种方式的优势在于避免了缓存与数据库的双写,只需保证数据库正确写入即可。缓存失效后,下一次读请求会触发数据库读取并刷新缓存,从而实现最终一致性。

由于删除缓存的操作是轻量级内存操作,失败概率极低;即便出现偶发不一致,也会在下一次读取时自动修复。

因此,该方案在保证高性能的同时,极大地降低了缓存与数据库不一致的风险,成为业界常见的实践。

问题一

a 去查数据库

b 将key value 写到缓存中

c 数据库

d 将 key value 写到缓存中

缓存key设置空值

存在问题 #card

解决思路 #card

查询缓存之前,对key值进行过滤,只允许系统中存在的key进行后续操作(例如采用布隆过滤器进行过滤)。

常见方法是布隆过滤器:它基于位数组和多哈希函数,能够高效判断某个 key 是否可能存在于系统中,如果布隆过滤器判断 key 不存在,则无需访问数据库和缓存,从源头阻断恶意请求。

此外,还可采用字典表或位图记录已存在 key 的范围和规则。

这样,系统只对合理 key 发起查询,从而避免无效 key 导致缓存膨胀,保证整体稳定性和性能。

当大量缓存 key 设置了相同过期时间,或者缓存系统重启导致 key 大量失效,会出现 “缓存雪崩” 现象:瞬间有海量请求绕过缓存直击数据库,导致数据库 QPS 暴增,甚至直接宕机。

本题中的场景就是典型的缓存雪崩问题。其原因在于 :-> 缓存失效集中触发数据库访问,加上并发请求数大,数据库无法承受瞬时流量。

当大量缓存 key 设置了相同过期时间,或者缓存系统重启导致 key 大量失效,会出现 “缓存雪崩” 现象:瞬间有海量请求绕过缓存直击数据库,导致数据库 QPS 暴增,甚至直接宕机。

[[缓存雪崩]] 如何解决缓存失效带来的性能问题

①串行化更新,通过加锁或排队控制同一 key 的并发写请求,避免重复写数据库刷新缓存;

②过期时间随机化, :-> 为不同 key 设置不同或带随机偏移的 TTL,使缓存过期时间分布更均匀,减少同一时刻的大规模失效;

③多级缓存 :-> 在应用节点本地维护 L1 缓存,分布式缓存作为 L2,双层缓存共同抵御突发流量,即使部分失效,也能通过局部缓存抵消部分请求压力。

结合实际业务特点,往往需要综合使用

例如在 热点数据 上启用多级缓存与锁机制,在 长尾数据 上采用过期时间分散策略,从而整体上避免缓存雪崩,保障系统性能与可用性。

[[20250924]]

问题一

E1 房主 E2 租赁者

P1 登记房主信息

p2 查询手续费信息 登记房屋信息

p3 登记租赁者信息

p4 查询租赁房屋信息

p5 生成看房记录 安排看房

p6 变更房屋状态

D1 房主信息表

d2 租赁者信息表

d3 房屋信息表

d4 看房记录表

问题2

房主

2 房屋

3 房屋类型

4 租赁者

5 看房安排

信息工程方法中的”实体(entity)” 与面向对象方法中的”类(class)”之间有哪些不同之处? #card

实体用于数据建模,而类用于面向对象建模。

实体只有属性,而类有属性和操作。

在面向对象方法中通常采用用例(Use Case)来捕获系统的功能需求。用例可以按照不同的层次来进行划分,其中的Essential Use Cases和Real Use Cases有哪些区别?

翻译 #card

Essential Use Cases 可翻译为抽象用例

Real Use Cases 可翻译为真实用例。

适用阶段不同 #card

Essential Use Cases 用于分析阶段

Real Use Cases 用于设计阶段。

描述对象不同 #card

Essential Use Cases 描述用例的本质属性,它与如何实现这个用例无关,独立于实现该用例的软硬件技术。

Real Use Cases 描述的是用例的实现方式,表达了设计和实现该用例时所采用的方法和技术。

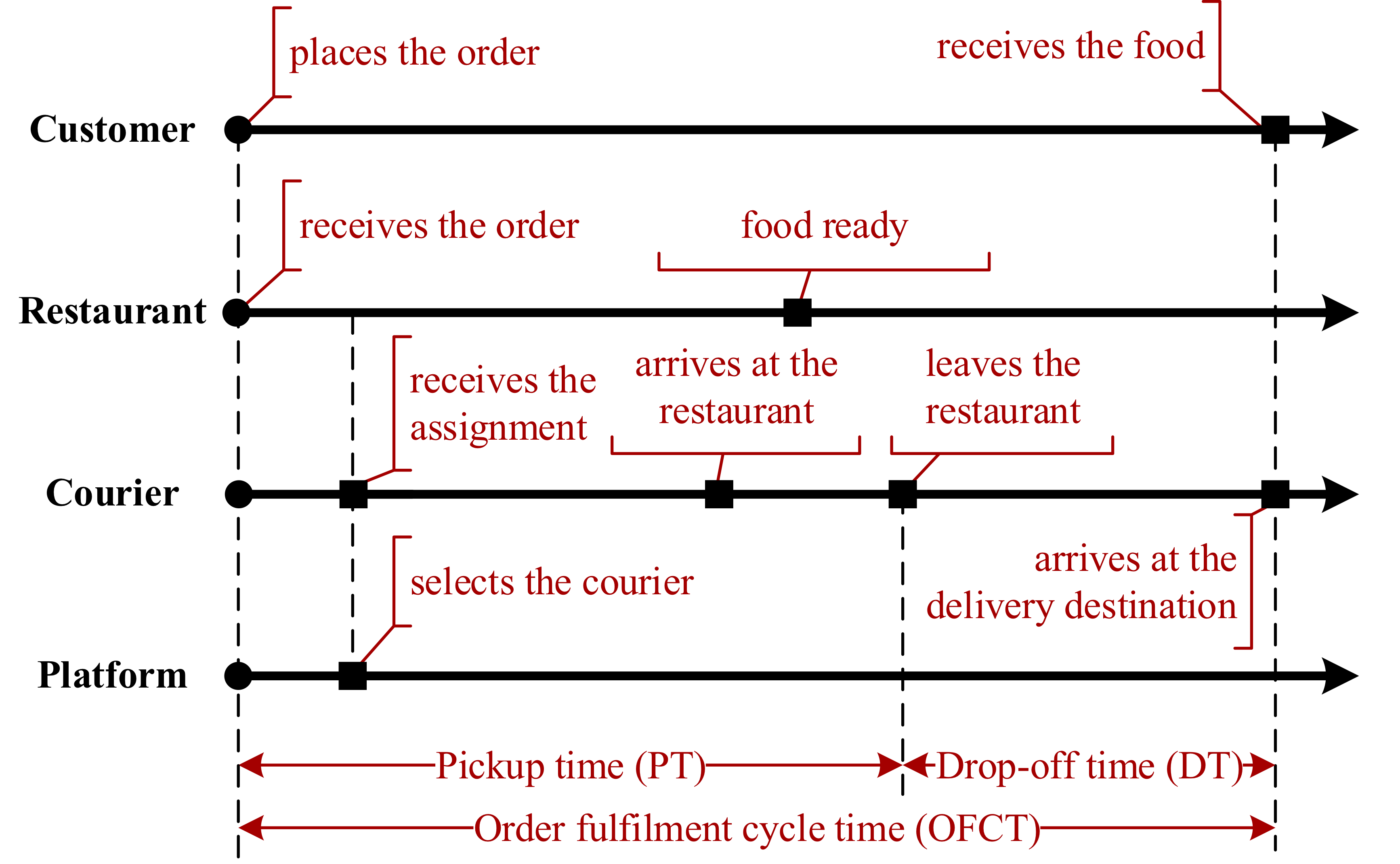

[[20250917]]

E1注册客户

E2 注册客户 厨房

E3 快餐店经理

E4供应商

p1 在线订餐

p2 生成菜单 厨房备餐

p3 厨房备餐 生成报表

p4 食材采购

[[20250910]]

问题 1

1 患者

2 医院管理员

3-8 3c账号管理,注册登录、b信息,,d预约挂号,e查询与取消,报告查询

9-12 号源管理、,预估管理,报表管理,信用管理,c注册登录

问题2

1 系统界面 预约人员

2 点击预约按钮 预约挂号请求

3 显示医生信息和可预约时间

4 显示预约结果 是否成功

[[20250908]]

问题一

1 f

2 g

3 h

4 d

5 b

6 e

问题 2

1 项目管理员

2 项目经理

3 指标数据

4 项目信息

5 关联事故

6 影响因素

问题 3

1 风险驱动的安全分析 #incremental #card

风险识别 :<-> 全面查找系统中可能存在的各类危险,如物理风险、软件故障等。

风险评估 :<-> 对识别出的风险进行评估,考量其发生的可能性及潜在后果的严重程度。

安全需求定义 :<-> 基于风险评估结果,明确系统应具备的安全需求和功能。

安全设计与验证 :<-> 依据安全需求进行系统设计,并验证设计是否满足需求,降低风险。

问题2 [[故障分析树]]

1

2

3

4

5

6或7

8

9

3

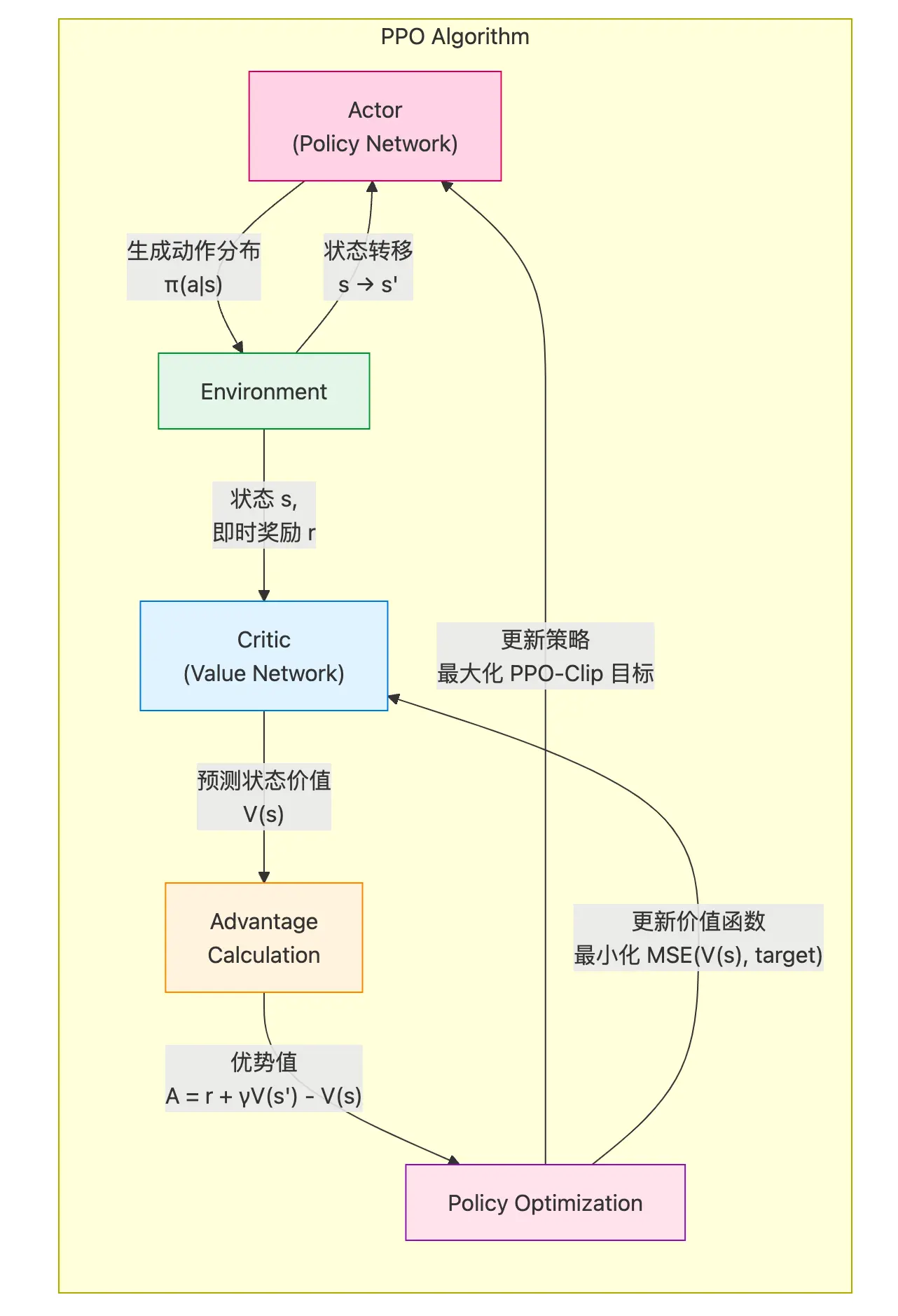

@强化学习中action value减去state value之后怎么就减小了方差,方差不是不变吗?

链接: https://www.zhihu.com/question/344367451

核心误区澄清:“减去一个常数(baseline)不会改变随机变量的方差,因为方差是平移不变的。” 问题出在哪? #card

在强化学习中,基线 $\mathrm{V}(\mathrm{s})$ 不是常数!它是状态 s 的函数,与动作值 $\mathrm{Q}(\mathrm{s}, \mathrm{a})$ 是高度相关的随机变量。

因此,我们需要分析 $\operatorname{Var}[Q(s, a)-V(s)]$ 的联合分布特性。

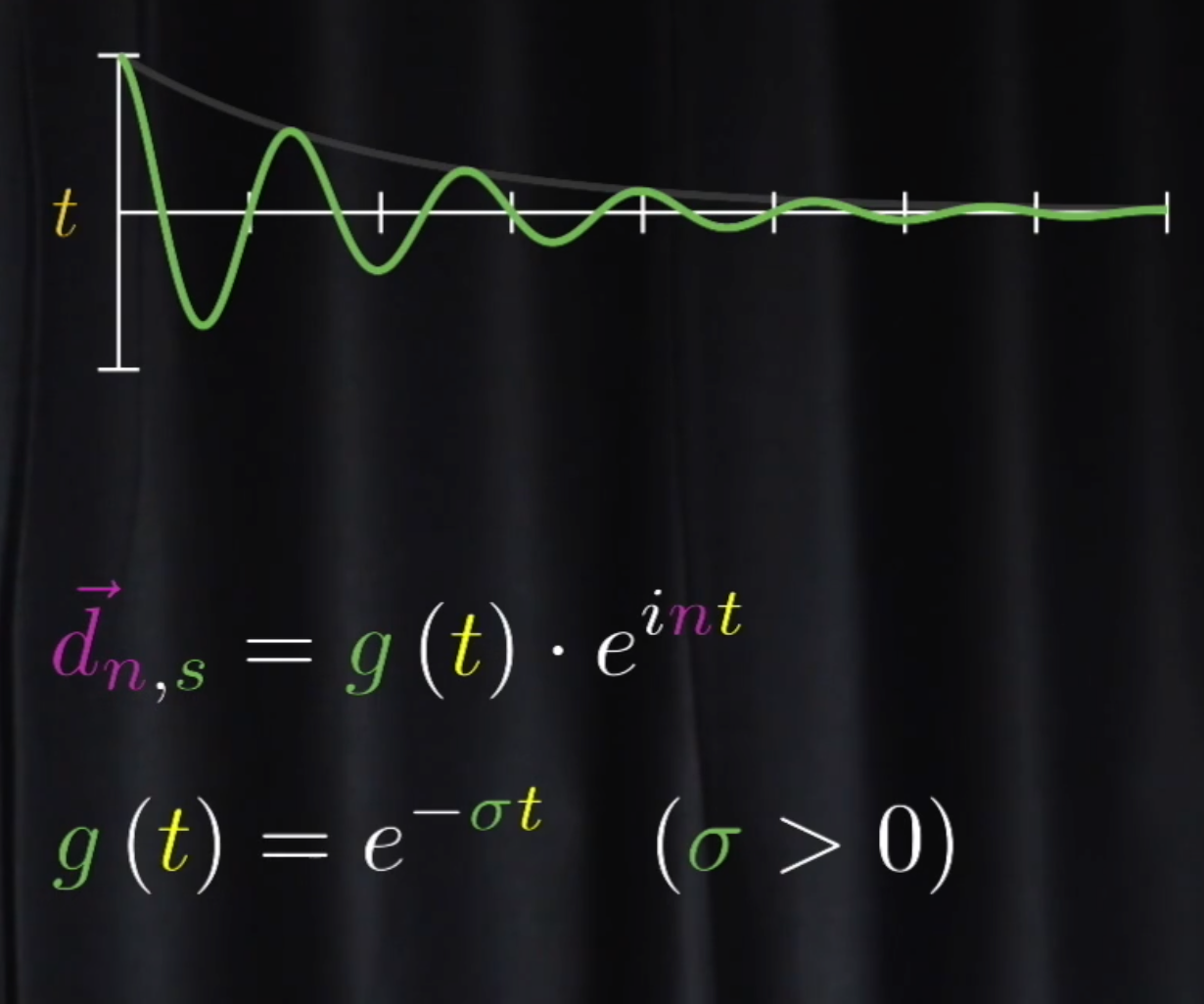

为什么 $\operatorname{Var}[A(s, a)] \le \operatorname{Var}[Q(s, a)]$ ? #card

[[协方差效应]]

方差公式展开: $\operatorname{Var}[Q-V]=\operatorname{Var}[Q]+\operatorname{Var}[V]-2 \operatorname{Cov}(Q, V)$

若 Q 和 V 正相关(通常成立,因为 $V(s)=\mathbb{E}_a[Q(s, a)]$ ),协方差 $\operatorname{Cov}(Q, V)>0$ ,

$\operatorname{Var}[Q-V]=\operatorname{Var}[Q]+\operatorname{Var}[V]-2 \operatorname{Cov}(Q, V)<\operatorname{Var}[Q]+\operatorname{Var}[V]$ 是否一定小于 $\operatorname{Var}[Q]$ ? #card

实际场景中的方差减少

1.$V(s)$ 平滑了 $Q(s, a)$ 的波动:

2. $\mathrm{Q}(\mathrm{s}, \mathrm{a})$ 的方差来源于动作 a 的随机性和环境动态的随机性。

3.$V(s)$ 是 $Q(s, a)$ 的期望(对所有动作取平均),因此天然过滤了动作选择的随机性,其方差通常比单个 $\mathrm{Q}(\mathrm{s}, \mathrm{a})$ 小。

4.因此, $\operatorname{Var}[V(s)] \ll \operatorname{Var}[Q(s, a)]$ ,且 $\operatorname{Cov}(Q, V)$ 接近 $\operatorname{Var}[V]$ 。

极端情况 1.假设 $Q(s, a)=V(s)+\epsilon$ ,其中 $\epsilon$ 是零均值噪声(动作带来的波动)。#card

2.则 $\operatorname{Var}[Q-V]=\operatorname{Var}[\epsilon]$ ,而 $\operatorname{Var}[Q]=\operatorname{Var}[V]+\operatorname{Var}[\epsilon]$ 。

3.显然 $\operatorname{Var}[Q-V]<\operatorname{Var}[Q]$ 。

直觉解释

$\mathrm{Q}(\mathrm{s}, \mathrm{a})-\mathrm{V}(\mathrm{s})$ 表示动作的相对优势,数值范围更小(有正有负)。

如果某个动作 $a$ 的 $Q(s, a)$ 很高,但 $V(s)$ 也高(因为其他动作也可能很好),优势值 $A(s, a)$ 会被 "压缩",从而抑制极端值。

条件方差公式:对任意随机变量 X 和 Y ,有: $\operatorname{Var}[X]=\mathbb{E}[\operatorname{Var}[X \mid Y]]+\operatorname{Var}[\mathbb{E}[X \mid Y]]$ 应用到 $\mathrm{Q}(\mathrm{s}, \mathrm{a})$ 和 $\mathrm{V}(\mathrm{s})$ #card

$\mathbb{E}[Q \mid s]=V(s)$, 因此: $\operatorname{Var}[Q]=\mathbb{E}[\operatorname{Var}[Q \mid s]]+\operatorname{Var}[V(s)]$

而 $\operatorname{Var}[Q-V \mid s]=\operatorname{Var}[Q \mid s]$ ,因此: $\operatorname{Var}[Q-V]=\mathbb{E}[\operatorname{Var}[Q \mid s]]<\operatorname{Var}[Q]$

结论:减去 $\mathrm{V}(\mathrm{s})$ 消去了 $\operatorname{Var}[V(s)]$ 项,保留了更小的条件方差。

[[Actor-Critic]] 和 [[A2C]] 区别 #card

AC(无优势函数): 梯度更新依赖 Q(s,a) 或单步TD误差,受奖励尺度影响大,训练不稳定。

A2C(用优势函数): 优势值 A(s,a) 的尺度更稳定,收敛更快(尤其是稀疏奖励场景)。

方差减少的本质:#card

不是简单的“减去常数”,

而是通过利用 Q 和 V 的相关性,消去了 Q(s,a) 中与状态相关的波动(被 V(s) 捕获),保留了动作相关的差异。

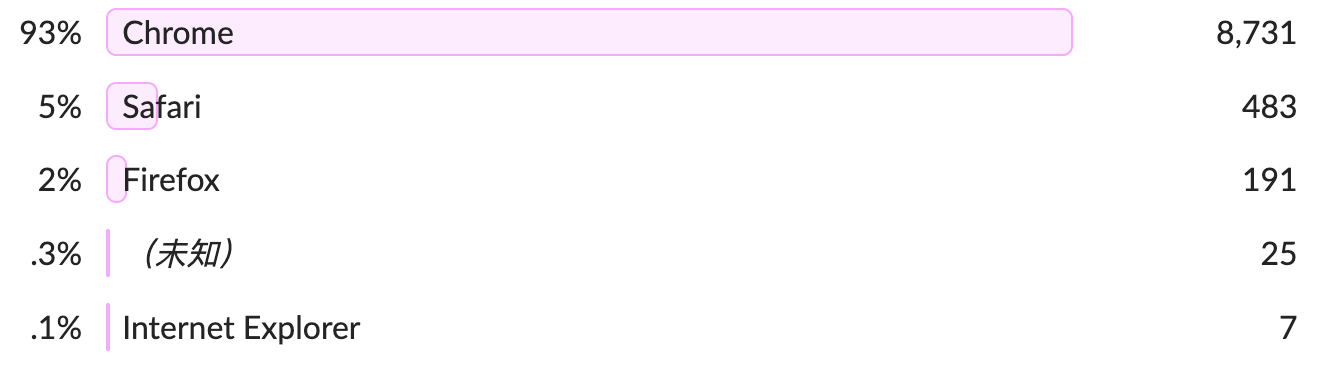

备份今年在 [[GoatCounter]] 上的博客统计数据。

The Best Things and Stuff of 2025

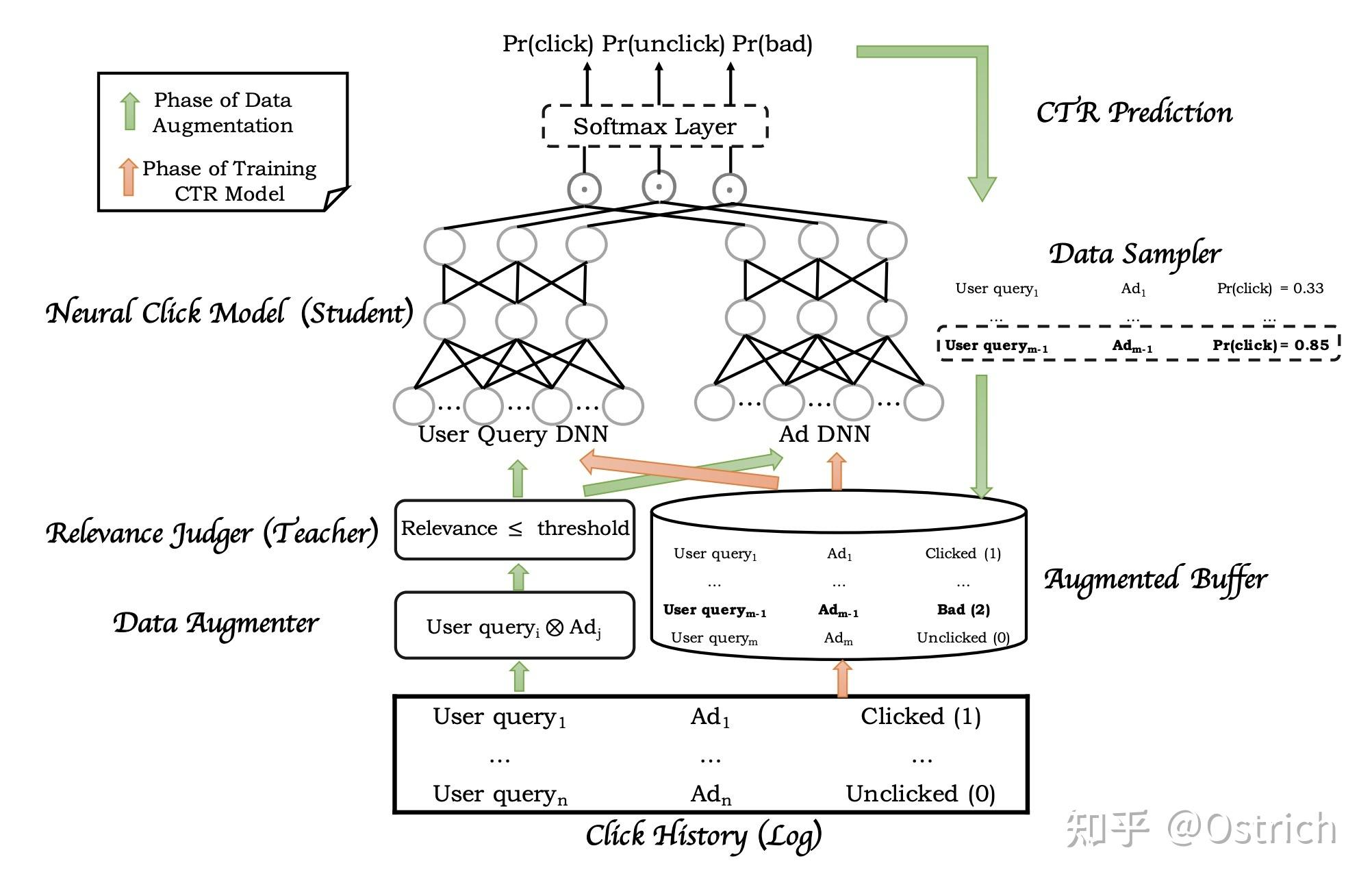

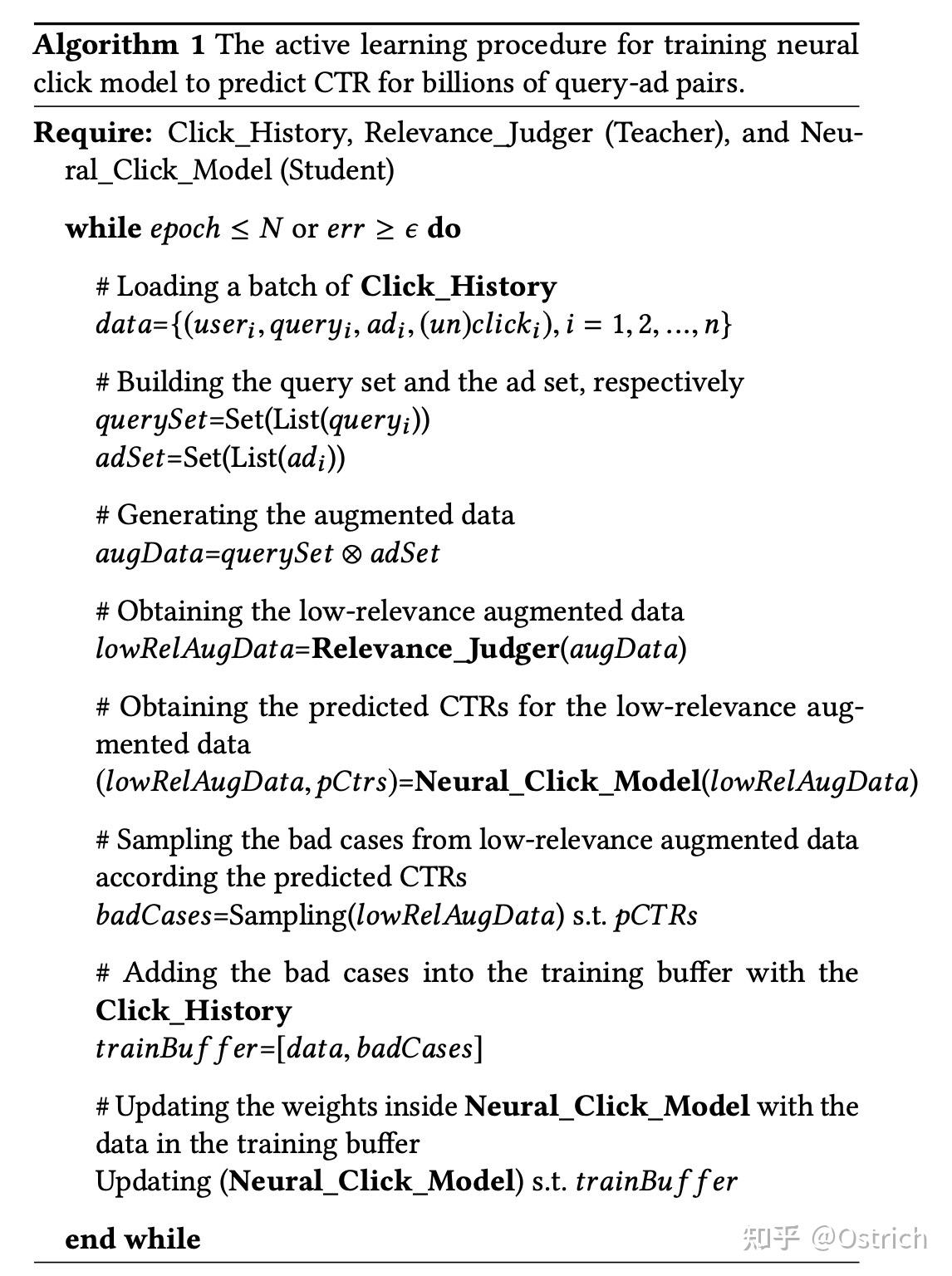

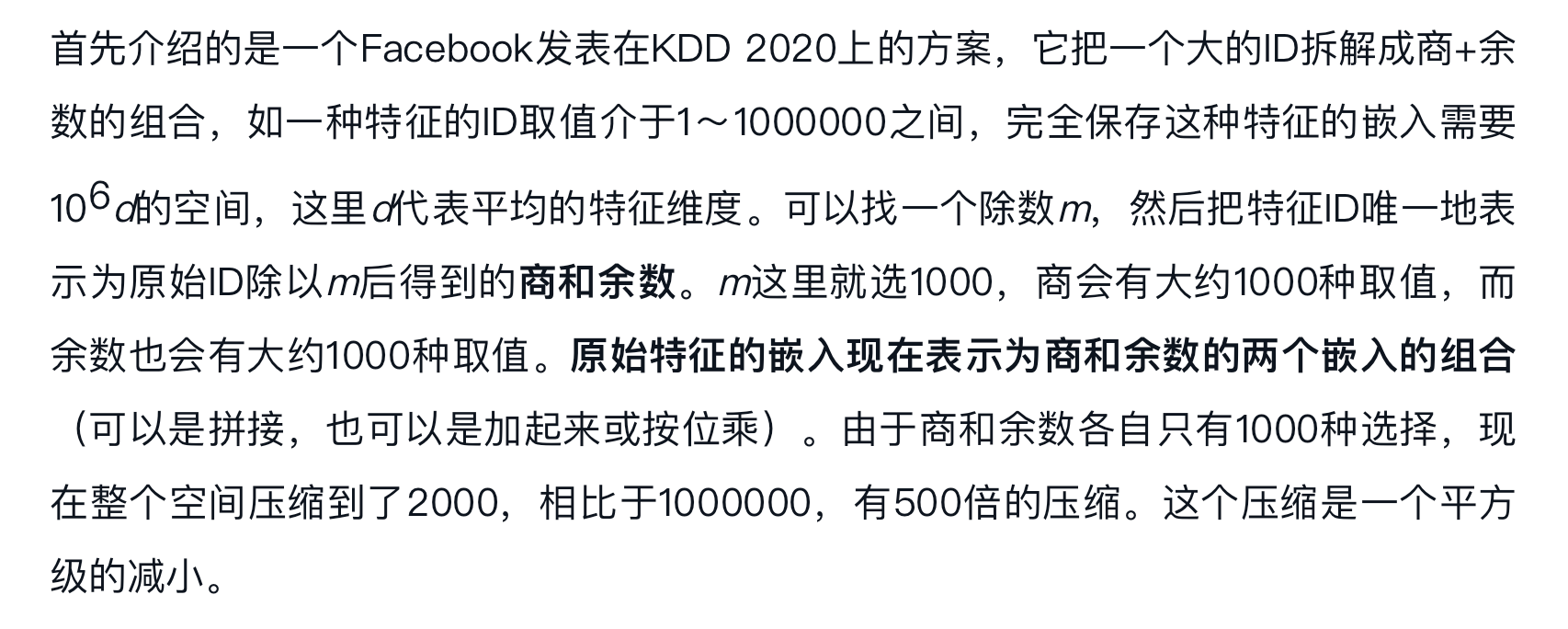

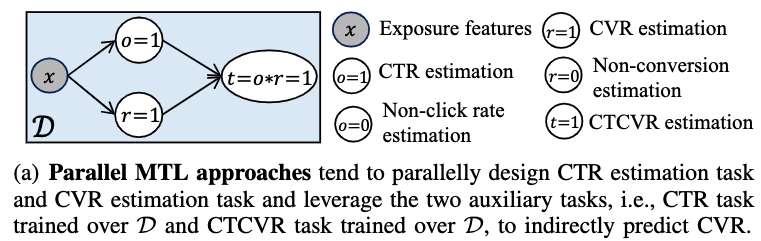

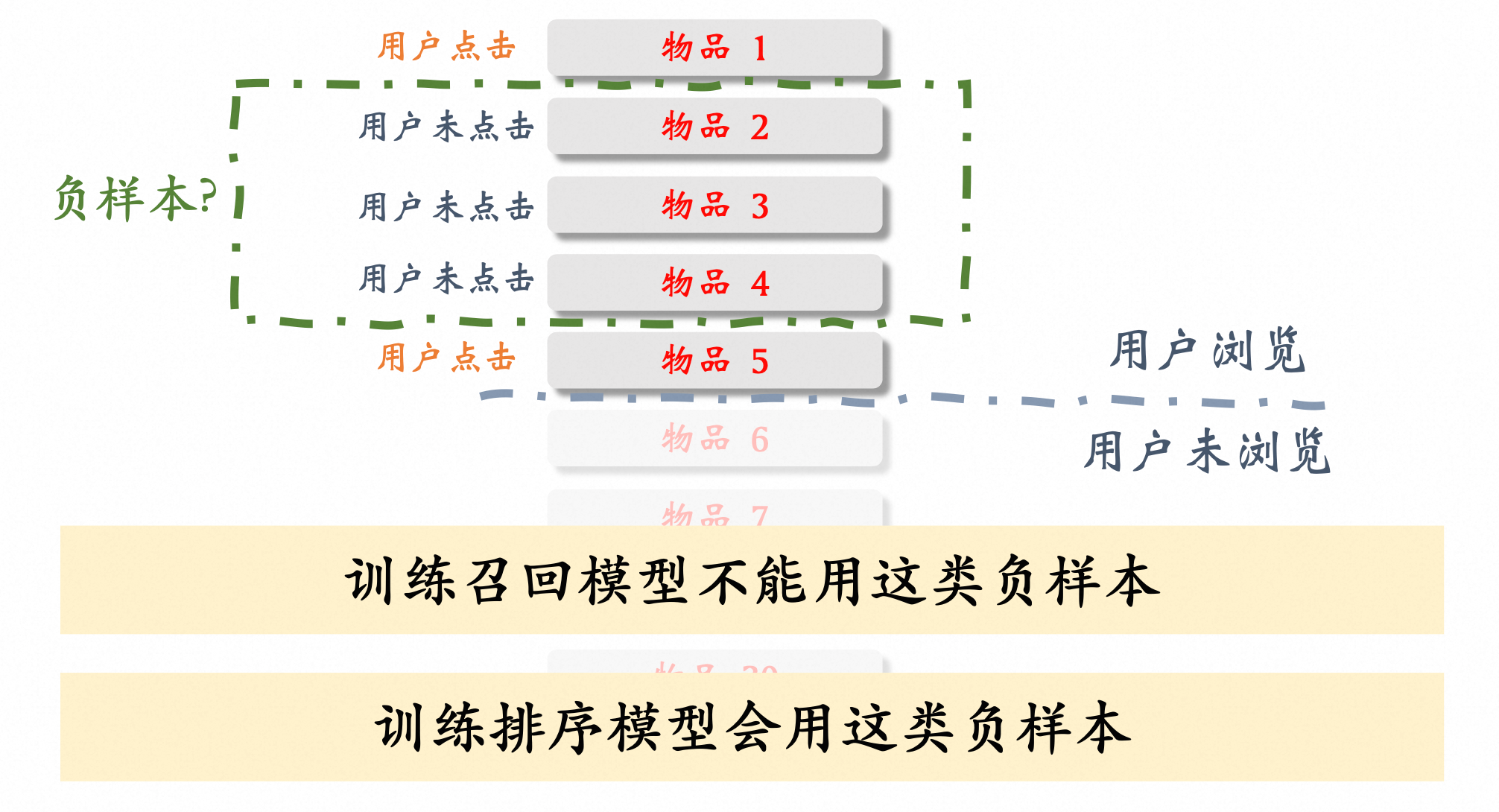

链接: 容易被忽略的CTR/CVR Label优化 - 知乎

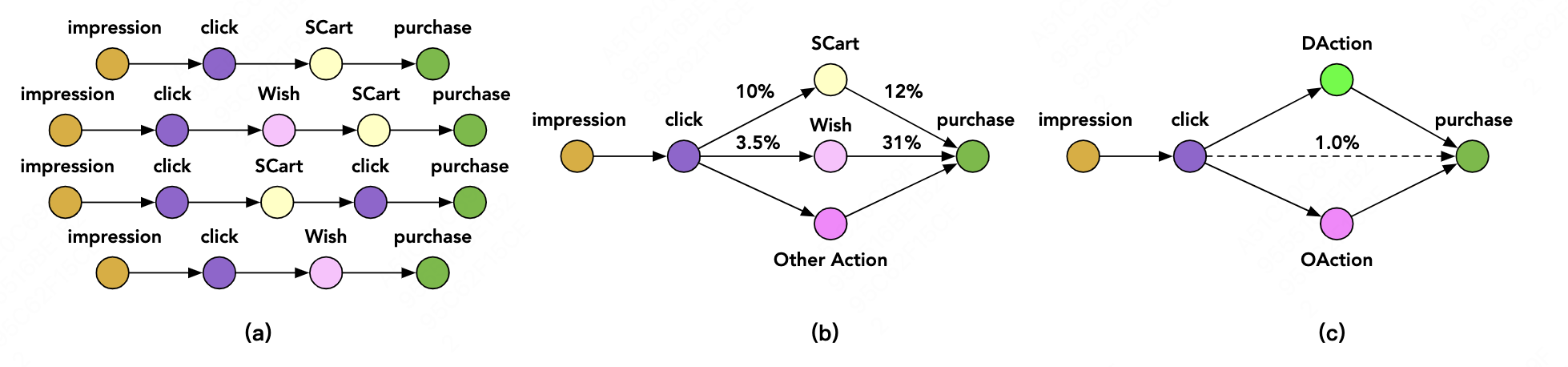

延迟成交与延迟退货的建模本质上都是在解决一个问题,#card

那就是样本准确性与样本时效性的平衡,采用当天口径归因时效性较好

,但由于掺杂了部分伪负例会导致效果次优。

不过引入延迟反馈一般对当天指标提升有限,除非数据稀疏,Base较弱,

或大量延迟反馈是如外界事件中断所致,这些反馈本就应该在当天口径下发生。

向前归因:对当天成交关联过去N天点击,将回补的正例Union到当天样本 #card

优点是不影响当天样本时效性,

缺点是回补正例被当作过负例,有时需要通过重加权降低影响。

向后归因:对当天点击关联未来N天成交,因此样本会滞后N天的时间窗口,不过延迟成交通常呈长尾分布,取M<<N天即可关联大多数订单。#card

多任务建模

+ [[ECAD]] #card

[[沉浸式翻译]] 的推荐

很多人,包括我,自学最大的崩溃点,就是回头打开自己的笔记,发现全是截图、摘抄、感想,几个月后自己看的都吃力。

工具越换越多,从备忘录、Notion 到各种知识管理 App,结果最后都变成“电子垃圾堆”,真正能沉淀下来的东西几乎为零。

而 http://Gwern.net 展示的是完全相反的一种走向:同样是“写在互联网上的笔记”,但是被他硬生生做成了一座深度研究的长期堡垒。

这是独立研究者 Gwern Branwen 的个人网站,他写 AI、心理学、统计学、暗网市场、比特币、动漫、行为遗传、自我实验,所有内容都长期挂在一个公开站点上。

他的每一篇文章,都不是“一次性写完就丢着”的快照,而是几年甚至十几年的动态文档。

有的页面从 2010 年开始写,中间不断追加新数据、新论文、新实验,类似“Spaced Repetition”“Nootropics 实验”“Darknet Markets 档案”等页面,都是隔几年更新一轮,笔记像活的一样在长大。

这就是很多人笔记做不出质感的第一层差距:

我们习惯“写完就算”,而他默认“写完只是版本 0.1,以后还要回来更新”。

同样一篇“读书笔记”或者“研究心得”,放在他的系统里,会被当成一个长期项目,不断加注脚、补证据、修正预测,几年后就成了一块可以被拿出来当「作品」的知识砖块。

第二个差距,是证据密度。

多数人的自学笔记,是“我觉得”“我感觉”“某某博主说”,往下就断了。

Gwern 的文章基本都是:一个结论后面挂一串论文链接、数据图、计算过程,连统计方法和可能的偏差都写出来,等于逼着自己每一条洞察都要有来源、有推理链。

这也解释了,为什么很多人把他的网站叫作“个人版研究百科”

习惯写这种高证据密度的内容,你的笔记就不再只是给自己看的随手记录,而更像是“对世界的一次公开下注”,别人完全可以照着你的链路复现和反驳。

那种“我只是随便记点东西”的心态,会被迫升级成“我要写一个经得住几年之后的我自己、和别人一起回头看的东西”。

第三层,是你刚刚提到的“长期预测型数字花园”。

Gwern 很多文章里,有时间戳、有预测、有后验检讨,比如 AI scaling 的判断、某些技术路线的趋势、某些社会现象的发展,他不是说完就跑,而是几年后回来对照自己当年的说法,看哪些被证伪、哪些撑住了。

这就让整个网站,变成了一块“把思考写在时间轴上”的公共实验场,而不是永远正确的金句合集。

我们可以对照一下自己的笔记系统,不会造还不会模仿吗?

电子垃圾型笔记:记的时候爽、抄的时候多、从不回头改,时间一久,你自己都不信任里面写的东西。

堡垒型笔记:像 Gwern 那样,把每篇内容当成可以被别人检验的公开作品,写的时候就会自带“证据强迫症”,之后也愿意回来打补丁、改版本、承认错判。

偷学他的思路,哪怕只学三件事,也足够让你的笔记不再是垃圾场:

给每篇重要内容加时间戳和后续更新;

所有结论都尽量挂上来源和推理链,而不是只写“我觉得”;

把自己最在意的几个主题做成长期页面,反复回去更新,而不是一次性写完就丢。

当你愿意这样对待自己的数字花园,你的每一条笔记,才会真正从“自言自语”,变成能和世界对话的砖块。

[[The Rule of Three]] 如果你发现自己做某件事三次,那就应该修复它。

大学同学 @haihongblog 带着入坑,不过当时可能就在学校玩过几次,连三级都没有生到(所以拿到不到更早的周年牌子,挺坑的)

2020 年 11 月 3 级

公司遇到一位蓝军大佬 observerandy,可惜我重新捡回来的时候,他就结束了实习。

后续自己在北京单机玩过一段时间

2025 年 6 月份左右,看 nanoape 的文章,重新入坑,开始漫长的升级之旅。

[[crazerg]],杭州绿军 poc,也是台州老乡。

plzenjoygame 浙大森林附近的蓝军大佬,经常对抗。

po 场:梦想小镇、阿里西溪a区、杭师大、浙大森林、浙大紫金港、浙大玉泉、西湖(特别是孤山)

[[20251115]] 周年庆双倍,之前自己和 @zhengbinle,差不多在梦想小镇摸 key 1 个多月。准备了 40 多套 key,

链接: 聊聊生成式召回的本质 - 知乎

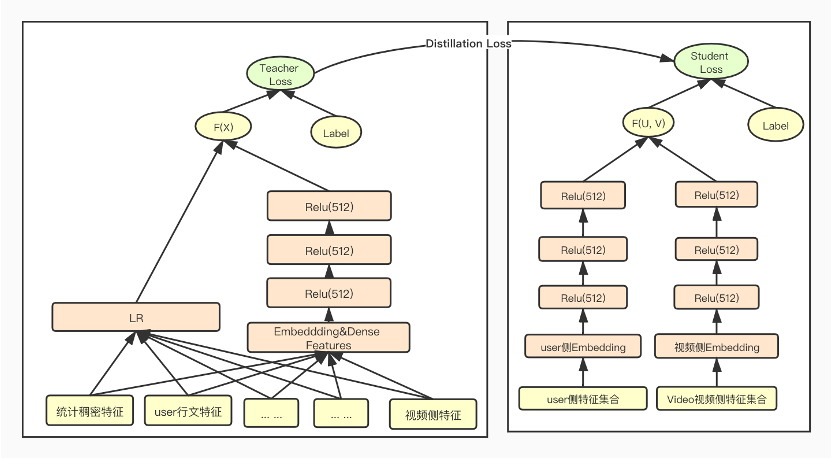

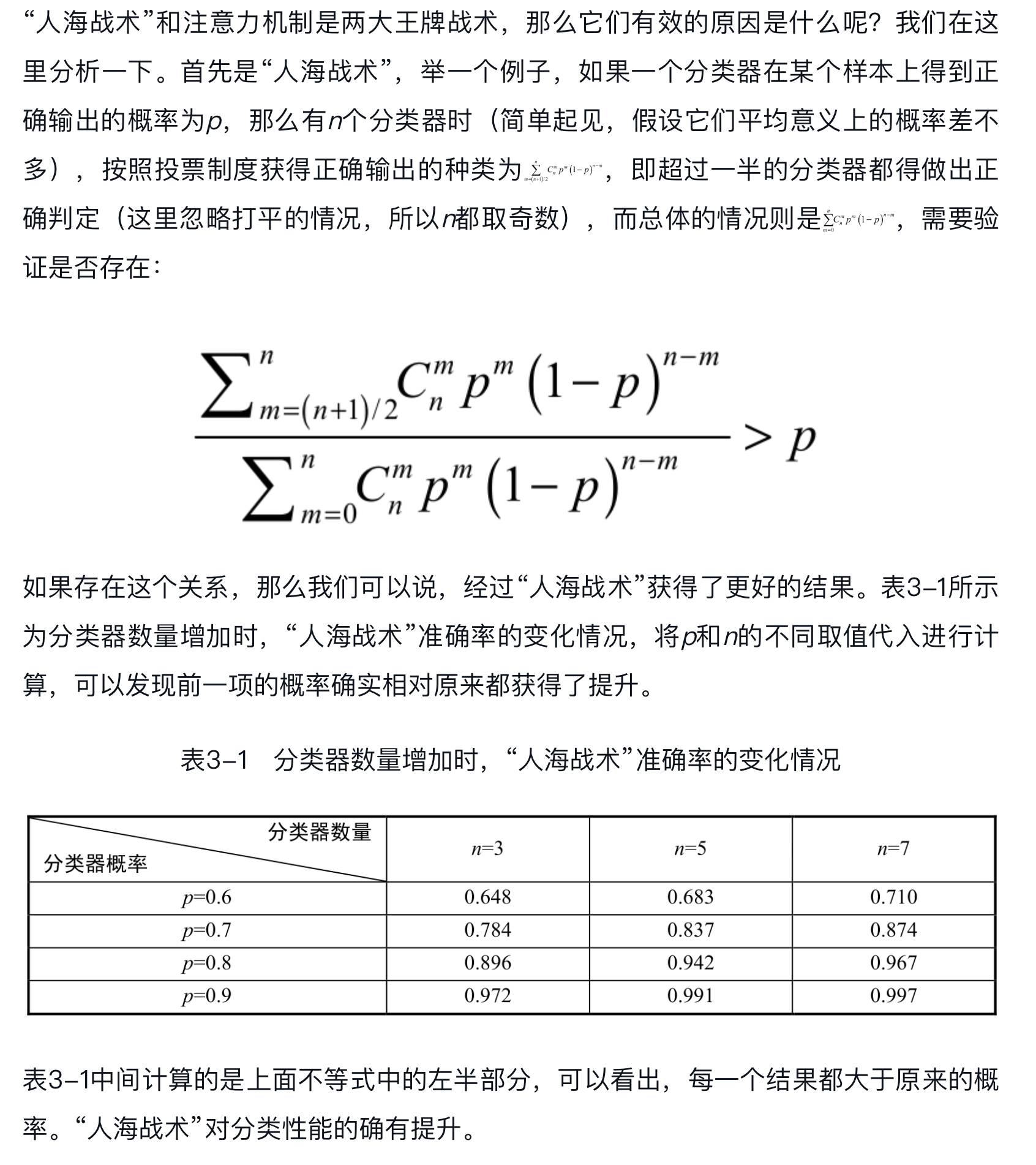

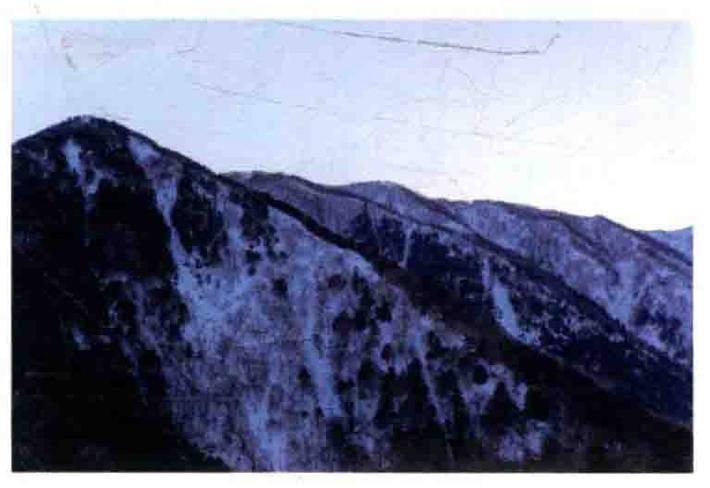

这种生成式召回往往是这样建模:输入用户的历史行为序列,保持在item ID这个粒度,可以附带author ID,timestamp这样的side info,预测下一个要产生正行为(比如点击,完播,点赞这种)的item。但是,工业场景item是个开集,#card

其一,ID在不断新增,我连下一个item是谁都不知道,更不可能知道它的ID是什么

其二,item ID的空间理论上是无限大的,不可能按照分类去建模。

所以建模的时候,往往是预测这个item的embedding,而不是它的ID。但还是那个问题,你根本不知道下一个要出现的item是谁,怎么会知道它的embedding长啥样呢?#card

所以即使我给模型这么一个任务,它也完不成这个目标。

模型实际上做到的是另外一件事:在过去发生正向行为的item embedding之间,找到某种滑动平均的中点。

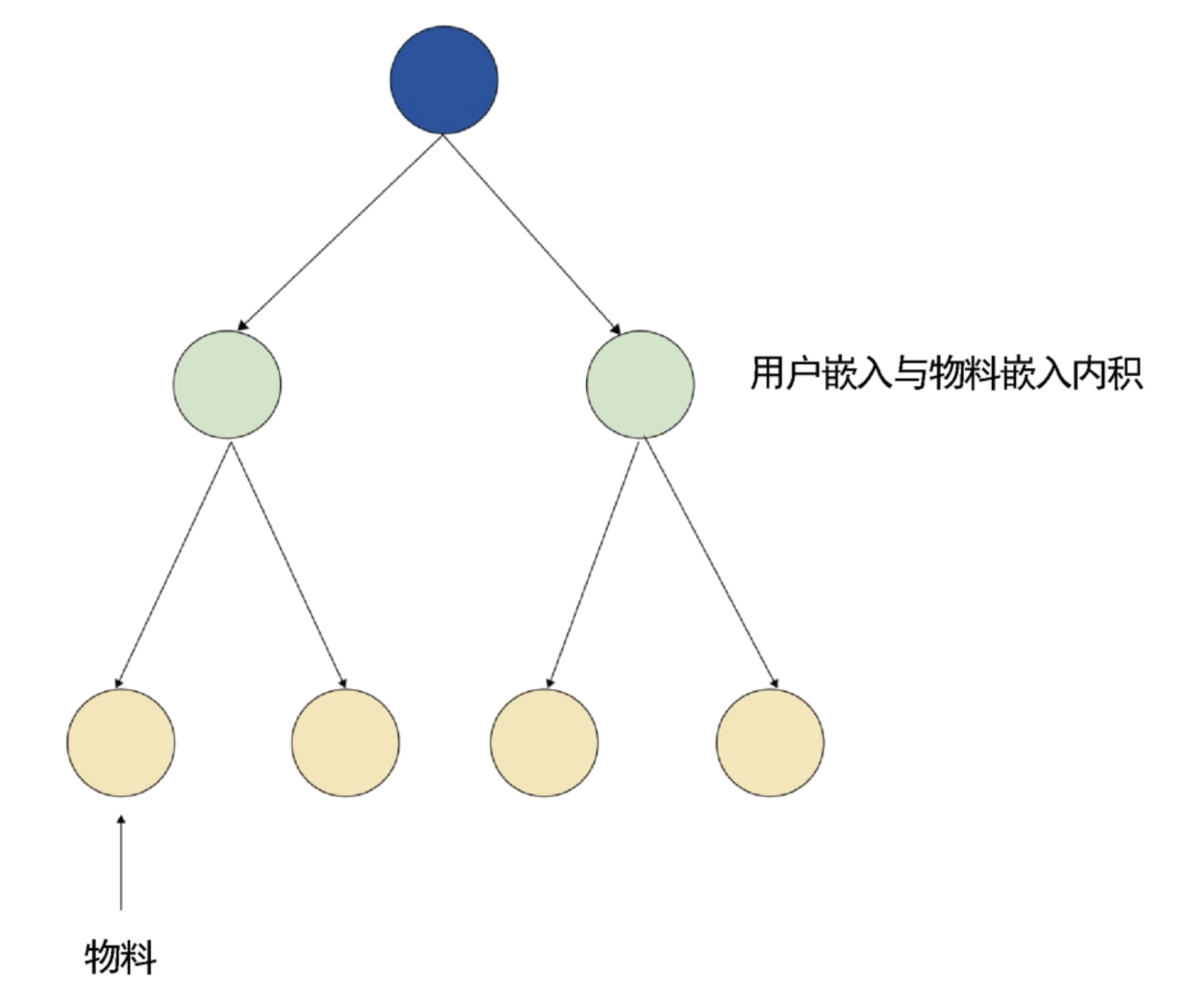

注意,上面的这整个过程,都是user侧自己的计算,直到最后,才用inbatch的softmax和item侧产生交互(由于item是开集,用inbatch softmax而不是softmax)。那我们发现,#card

这套方案里面其实没有设计如何让user和item产生一个很复杂的交叉的过程。

尽管用户序列可以搞得很长,可以用transformer或者其他复杂结构,

到最后user的最终结果和item之间仍然是一个很简单的内积或者距离关系。

而且,在serving的时候,用户侧信息得到是一个中间结果的embedding,怎么拿它来找item呢?#card

那还得借助索引,就还上HNSW,那它本质不就还是双塔吗?

只不过是一个user加了长序列和复杂建模的双塔。

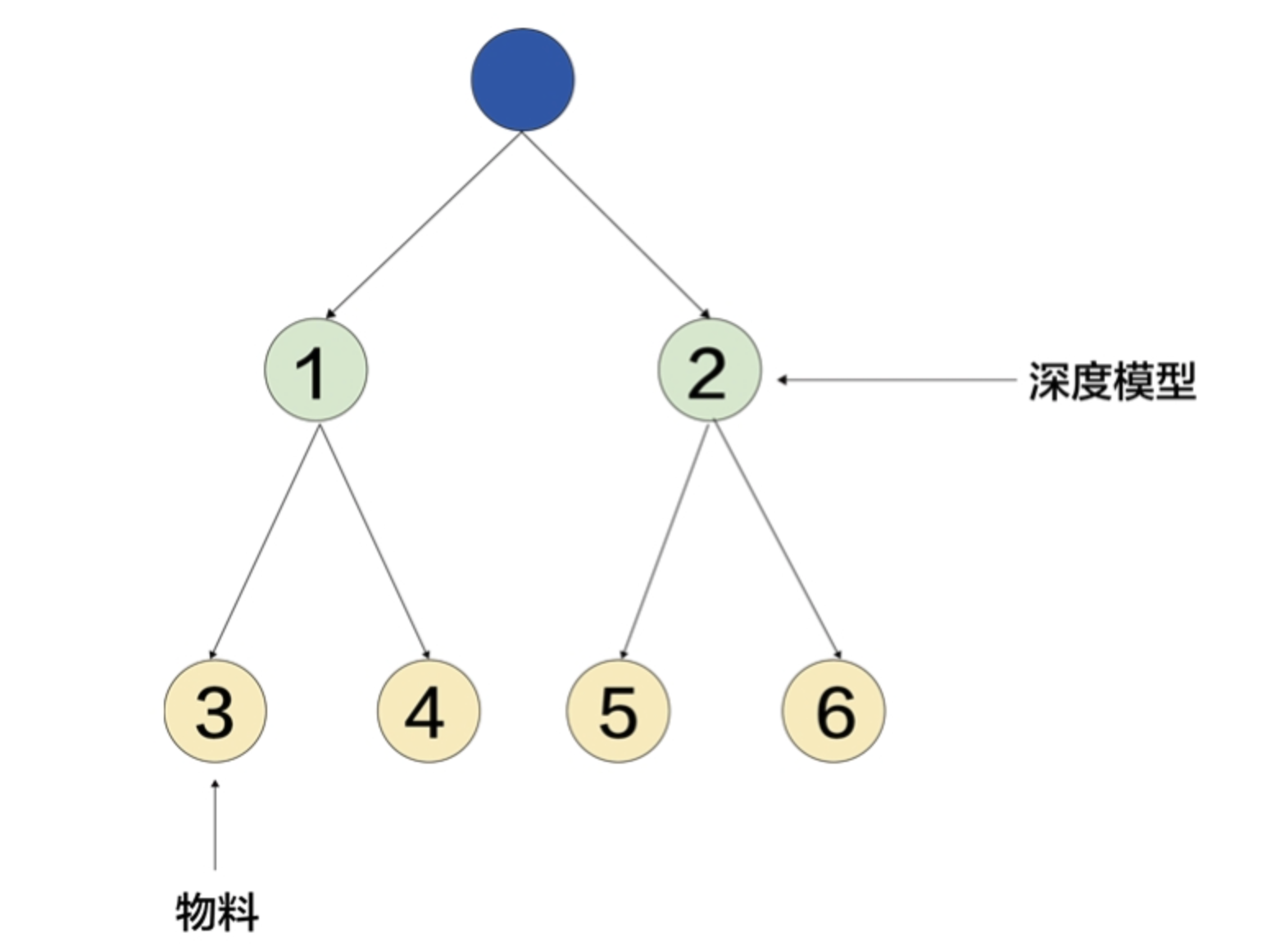

另一种生成式召回的实现方式,最典型的是[[google TIGER]](Recommender Systems with Generative Retrieval),它的逻辑是,#card

这个建模范式,和上面相比,最显著的变化就是,cluster是个有限集合,所以在预测的时候可以使用softmax做分类。但是,#card

同个cluster内部一般是没有序的,这就和deep retrieval中的一条path,streaming VQ中的一个cluster(这个是特殊情况,有办法使得它内部可以排序,详情见 现在,我们最好的召回模型来了)是一样的情况。

单路召回的出口条数其实还比较少,如果这样的生成式召回直接接召回出口,由于cluster内部无法取舍,很可能出现,选择n个cluster填不满,选择n+1个又超了的情况,而且这个n往往比较小,对聚类质量要求非常高。

所以一般来说,也会在上面流程的出口处,再接一个rerank模型,把很多个cluster的所有item放在一起,再排一遍序,最后拿一部分出口。#card

如果我们把这种两阶段的结构和streaming VQ做一个对比,“生成式”的这一部分实际上承担了索引的部分,有两个显著的特点:

1.可以粗略地对候选缩量;

2.某些item之间没有定义排序关系,需要加一个排序模型才能完整完成召回。

但和上一节略有不同的是,上一节中的生成式范式,在loss设计上和目前主流的召回模型没有区别。而这里的生成式范式,由于按照softmax分类,本质是随机负例,而不是inbatch负例。#card

因为这里softmax让其中一项最大化,其他的就要最小,但这个最小的约束和分布无关,看起来就像是均匀采集的负样本。

相反,inbatch负例和热度是相关的,能达到例如打压热度的效果,其实是更优的。

不过和TIGER利用多模态token不同,我更建议使用协同的cluster来实现生成式召回,例如嵌入一套VQ的训练框架。#card

这就来到了一个多模态更好,还是协同ID更好的问题。

我理解我们现在很希望多模态特征能替换掉协同ID,那样冷启动就不会是个问题,模型的泛化性会非常好,甚至我们也有可能直接用上LLM那边的模型参数。

但实际上根据我的实践经验,用多模态取代协同ID,费九牛二虎之力,最后也很难成,而且大家已经搞了很多年。反观协同ID,大不了随便加点embedding slice,这边就融化了。原因是什么呢?#card

设想两个模型,一个使用纯粹的多模态作为输入,一个使用现在的协同ID,也就是item ID这种。

用同样的训练数据,同样的损失函数,哪个会把拟合任务完成的更好?

如果在训练样本不充分的情况下,前者可能会更好,但在训练数据充足的情况下,就是后者更好。

为什么?因为协同ID的embedding是可变的,可以随着训练而调整,它的空间不是就比不能变化的多模态特征要更大吗?

(即使多模态特征接了MLP,本质还是没变,到输入层这里还是不可改变)

这就是为什么实践中往往多模态特征可以提升冷启动的效果,对于整体大盘的效果就很有限,能新增做出增量价值,已经是很难能可贵了。

以上几个点我们讨论完毕,那就到下面这个最终的结论—— #card

生成式召回其实都是目前streaming VQ框架可覆盖的。

而streaming VQ有很多独特的点,生成式召回反而提供不了。

首先看第一种,预测下一个item embedding的范式,他现在本质还是个双塔,而且实际上是相当于streaming VQ的ranking部分。#card

streaming VQ现在的ranking部分是已经可以支持复杂模型+长序列建模的,

因此这一部分肯定是streaming VQ 1:0领先。

对于第二种,我们就要对比索引阶段。这里又有分支,如果你不同意我的观点,认为多模态特征有增量价值,没关系,#card

如果是基于协同的生成式范式,那么streaming VQ在索引上和对方有同样的VQ聚类体系,同样的双塔结构。#card

现在生成式这里唯一占优的是长序列,和长序列建模。但还是那句话,#card

在双塔的前提下,streaming VQ想在单user侧加长序列建模是十分容易的,工程上并不比生成式负担更大,

那就是你加序列我也加,你加user复杂化我也加,你不打了我也不打了,你能赢得了我吗?

其实还不止,生成式召回这里,要保证输入和预测对象的一致,才用cluster ID。#card

我们上面讲的第二种生成式使用softmax,而streaming VQ使用inbatch softmax,这个又是谁更好呢?#card

streaming VQ沿用了很多成熟的热度消偏方案,在索引平衡性、即时性、等等问题都有解决方案,#card

综上所述,我们得到最终的结论,即,目前存在的生成式召回范式,其实都能被streaming VQ覆盖,后者是前者的超集。

三个层次 #card #incremental

控制层位于SDN架构的核心,负责网络的流量控制、流表的管理和决策。

转发层也称为数据平面,主要负责根据控制器的指令进行数据包的转发。

应用层指的是通过SDN控制器与网络进行交互的应用程序层,

工厂方法 :<-> 定义一个接口用于创建对象,但由子类决定实例化哪个类。

抽象工厂 :<-> 提供一个接口以创建相关或依赖对象的家族,而无需明确指定具体类。

单例 :<-> 确保一个类只有一个实例,并提供全局访问点

三层架构 #card #incremental

感知层 :<-> 负责数据采集和识别,

网络层 :<-> 负责将感知层获取的数据通过各种通信方式(如Wi-Fi、5G、以太网等)传输至应用层。

应用层 :<-> 面向用户,处理数据并提供具体服务,如智能家居、智慧城市、工业自动化等。

感知层

物联网的基础,用于识别物体、采集信息, 解决人类世界和物理世界的数据获取问 题。

先通过 传感器 等设备采集外部物理世 界的数据,再通过 短距离传输技术 传递数 据。

设备 :-> 利用传感器、RFID、摄像头等设备。

网络层作为纽带连接感知层和应用层,功能是#card

传递信息和处理信息,

负责将感知层获取的 信息安全可靠地传输到应用层,

并根据不 同应用需求进行信息处理。

适配器 :<-> 将一个类的接口转换为客户希望的另一个接口,使原本接口不兼容的类可 以一起工作。

eng :-> Adapter

装饰模式 :<-> 动态地给对象添加职责,而不改变其接口

eng :-> Decorator

代理 :<-> 为另一个对象提供一个代理或占位符以控制对它的访问。

外观模式 :<-> 为子系统中的一组接口提供一个统一的高层接口,使子系统更容易使用。

英文 :-> Facade

桥接模式 :<-> 将抽象部分 Abstraction 与它的实现部分 Implementor 分离,使它们都可以独立变化

例如将类的颜色和形状解耦,但是独立地去继承或者实现

英文 :-> Bridge

组合 :<-> 将对象组合成树形结构以表示“部分-整体”的层次结构,使客户可以统 一处理单个对象和组合对象

享元 :<-> 通过共享技术来有效支持大量细粒度对象的复用。

策略 :<-> 定义一系列算法,将每一个算法封装起来,并使它们可以互换。

模板方法 :<-> 在一个方法中定义一个算法的骨架,而将一些步骤延迟到子类中,使子类 可以不改变算法结构即可重定义该算法的某些步骤。

观察者 :<-> 定义对象间一种一对多的依赖关系,使得每当一个对象改变状态,所有依赖它的对象都会得到通知并自动更新。

迭代器 :<-> 提供一种方法顺序访问一个聚合对象中的各个元素,而不暴露其内部表示。

责任链 :<-> 使多个对象都有机会处理请求,从而避免请求的发送者和接收者之间的耦 合。

命令 :<-> 将请求封装成对象,以便使用不同的请求、队列或日志来参数化其他对象。

备忘录 :<-> 在不破坏封装的前提下,捕获并外部化对象的内部状态,以便以后恢复到 该状态。

状态 :<-> 允许对象在内部状态改变时改变其行为,对象看起来好像修改了其类。

访问者 :<-> 表示一个作用于某对象结构中的各元素的操作,使你可以在不改变各元素 类的前提下定义作用于这些元素的新操作。

类不变、新操作

表示一个作用于某对象结构中的各元素的操作。它使你可以在不改变各元素的类的前提下定义作用与这些元素的新操作。即对于某个对象或者一组对象,不同的访问者,产生的结果不同,执行操作也不同

中介者 :<-> 用一个中介对象来封装一系列对象交互,使对象不需要显式地相互引用, 降低它们的耦合度。

不直接引用

避免复杂的互相调用,让对象之间解耦

解释器 :<-> 给定一个语言,定义其文法的一种表示,并定义一个解释器,用于处理该 语言中的句子。

软件架构风格描述某一特定领域中的系统组织方式和惯用模式,反映了领域中众多系统所共有的 结构和语义 特征。

层次性 :<-> 每一层负责不同的功能,彼此之间通过结构进行通信

事件系统 :<-> 适用于系统中大量异步时间交互的场景,图形界面或部分中间件。

数据线(流水线)风格 :<-> 数据处理过程明确、顺序固定的系统,如编译器

[[C2架构]] :<-> 是一种以组件和连接件为核心的架构风格,强调解耦与消息驱动,适合可插拔系统

黑板 :<-> 典型用于语音识别、知识推理等复杂问题,多个知识源通过共享的“黑板”协作解决问题

[[进程通信结构]],系统由 **多个独立的进程(构件) ** 组成,这些进程之间通过 连接件 进行交互。

潜在缺点(脆弱性)

管道-过滤器风格 不能并发处理? #card

错误。管道-过滤器风格通过将处理过程划分为一系列过滤器节点,并通过管道连接,这种结构非常适合并发处理。

每个过滤器可以在独立线程中运行,从而实现流水线式处理。

说“不能并发”是对其特性的误解。

事件驱动风格:事件触发顺序不可控 #card

正确。[[事件驱动架构]]虽然解耦性强,

但由于事件的触发顺序可能不可控,

容易引发状态不一致或难以调试等问题。

某公司为其研发的硬件产品设计实现了一种特定的编程语言,为了方便开发者进行软件开发,公司拟开发一套针对该编程语言的集成开发环境,包括代码编辑、语法高亮、代码编译、运行调试等功能。针对上述描述,该集成开发环境应采用(__)架构风格最为合适。 #card

系统中的构件和连接件都有一个顶部和一个底部,构件的顶部应连接到某连接件的底部,构件的底部则应连接到某连接件的顶部,构件和构件之间不允许直接连接,连接件直接连接时,必须由其中一个的底部连接到另一个的顶部。上述构件和连接件的组织规则描述的是(__)架构风格。#card

静态测试 :-> 不运行程序,通过人工审查和静态分析工具检测文档和代码的正确性与逻辑错误

动态测试 :-> 需要在计算机上运行程序

不同测试方法

强度测试 :<-> 模拟极端恶劣的环境(如网络不稳定、低内存等)来测试系统在资源受限条件下的稳定性

负载测试 :<-> 关注系统在逐步增加负载下的性能变化

压力测试 :<-> 测试系统在超负荷条件下的反应

容量测试 :<-> 测试系统能处理的最大并发用户数量

黑盒测试方法

等价类划分法 :<-> 将输入域划分为有效和无效等价类,并从每类中选取代表值进行测试

因果图 :<-> 通过建立输入与输出之间的逻辑因果关系图,生成测试用例

边界值分析 :<-> 基于错误通常出现在输入边界的经验来设计测试用例

白盒测试技术

路径覆盖 :<-> 求测试用例能够覆盖程序中所有可能执行的路径

软件测试与开发文档之间的对应关系

单元测试的依据 :-> 详细设计文档描述了每个程序单元的内部逻辑、输入输出、算法等细节

模块测试的依据 :-> 概要设计描述模块之间的接口和交互

验收测试或系统测试的依据#card

需求分析,描述的是用户对系统功能和性能的期望

用户需求,描述的是系统应完成什么,

[[设计工程概述]]

[[用户界面设计]]

[[处理流程设计概述]]

[[流程设计概述]]

[[流程设计工具]]

[[结构化设计]]

[[面向对象设计]]

[[设计类分类]]

[[面向对象设计原则]]

交互图

用于系统的动态方面进行建模

顺序图

序列图主要用来更直观的表现各个对象交互的时间顺序,将体现的重点放在以时间为参照,各个对象发送、接收消息,处理消息,返回消息的 时间流程顺序,也称为时序图。

协作图

协作图是 一种类图,强调参与交互的 各个对象的结构信息 和 组织。

状态图

流程图

书

32小时通关

芝士架构 红宝书 https://www.cheko.cc/

周志明写的《凤凰架构》https://icyfenix.cn/summary/

学习流程:

靠前模拟考试,考前第三周和第四周,希赛网考前的两次模考大赛

题型

[[软考/综合知识]] 2 小时 75 道选择题

有舍有得

选择题刷题笔记:题号

[[软考/案例分析]]:2小时,5题(1道必选+4道选2)题型为填空题,或问答题。

例分析的准备不需要太长,可以和论文一起准备,大概是在选择题把所有知识点过完了过后再开始准备案例分析就行,在2023年之前,案例分析基本上都是白给,考题没有任何难度,可以看下上面红宝书或者小册子里面的历年真题,题型非常的固定,而且非常的简单。

但是23年过后,也就是我考的这两次,案例分析的难度直线上升,甚至脱离教材,根本无迹可寻,唯一知道的,

一定会考一个Web的题目【微服务架构,大型网站架构,高并发,秒杀】什么的,

一定会有一个数据的题目【大数据架构,数据库,缓存一致性什么的】,

还有一个架构设计的题目什么的,反正大的方向就这几个,虽然难题很难,但是拿到基础分通过考试还是不难的,准备方向还是刷题+背诵。

而且还要看看书什么的,去年考大数据架构Lambda架构和Kappa架构,还有SYSML我是一脸懵逼,还有JWT的架构,Hibernate的架构,见都没见过。但是尽管如此,下午还是考了40多分的,所以还是有些基础题是能做的,问答题答了还是有分的~。

准备步骤:

1小册子或者红宝书上面的案例分析先看了做了刷了。

2做一下历年真题,尤其是近两次考试的真题,

3熟知 Web技术,大数据技术,数据库技术,缓存技术,云计算云原生架构技术等。

而且这次考试发现一个特点,就是谜底藏在谜面里,答案会在问题中提示。比如25年考到了redis备份相关,第一小题让你写出redis的备份过程,后续小题让你解释AOF和RDB备份的区别。那这里明显就知道第一小题就是要往AOF和RDB去靠拢。

这几年案例分析的变化很大,越来越注重实践和积累,比如 20 年考了 Docker 命令,今年还考了 Elastic Search 的分词类型。

第1题一般是软件架构评估,2-5题中固定会有一道题是嵌入式系统设计。除此之外,还会有以下题型:#card

软件系统建模(UML图填空、问答)

系统架构整体设计(表格填空、架构图填空、问答)

Web系统架构设计(表格填空、架构图填空、问答)

单个细节的方案详细设计(针对不同场景,进行高可用设计、性能设计、可扩展性设计等)(表格填空、图形填空、问答)

问答题的题目一般会这样问:

请说明什么是XXX,并指出它的作用与特点

请说明A和B两种设计模式的区别和联系

方案分析与选择类:#card

项目组最终使用了xxx技术方案,请分析在题目所述场景下采用xxx技术方案的原因

请分析N种技术方案的优势和劣势/适用场景,并确定使用哪个技术方案

请指出选用xxx技术方案存在的问题

[[软考/论文]]:2小时 4选1

底稿

论文有一定的格式,整体上摘要300字+正文2500字(背景500+技术方法选择500+展开论述,分三点1000字+结尾500)。

选题完成后,我就建议先把背景和结论先打出来,这里是要事先背诵好,控制在半个小时左右。然后打1000字的过程中就可以去想【技术方法选择500字】和【展开论述,分三点1000字】这两个部分,有80分钟左右,就比较充裕。

[[软考知识点]]

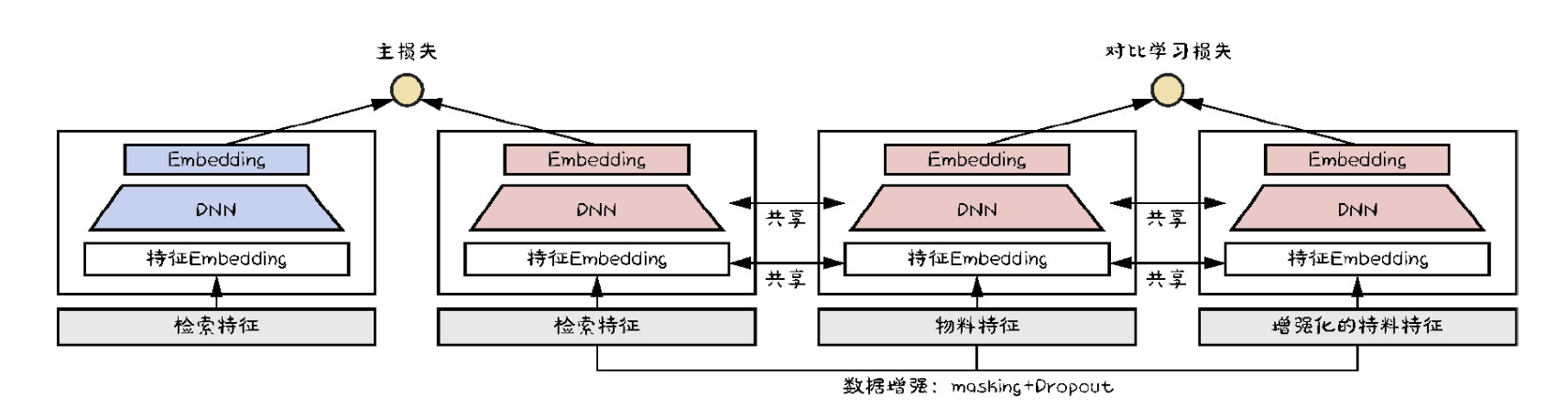

Multi-Scale Feature Engineering

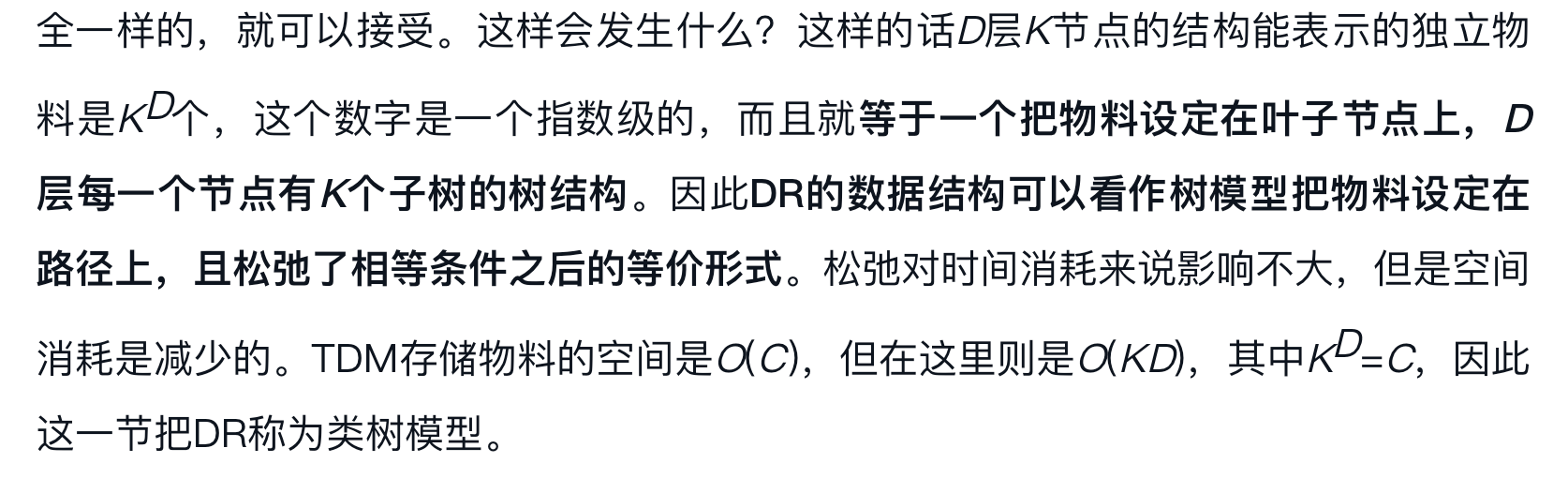

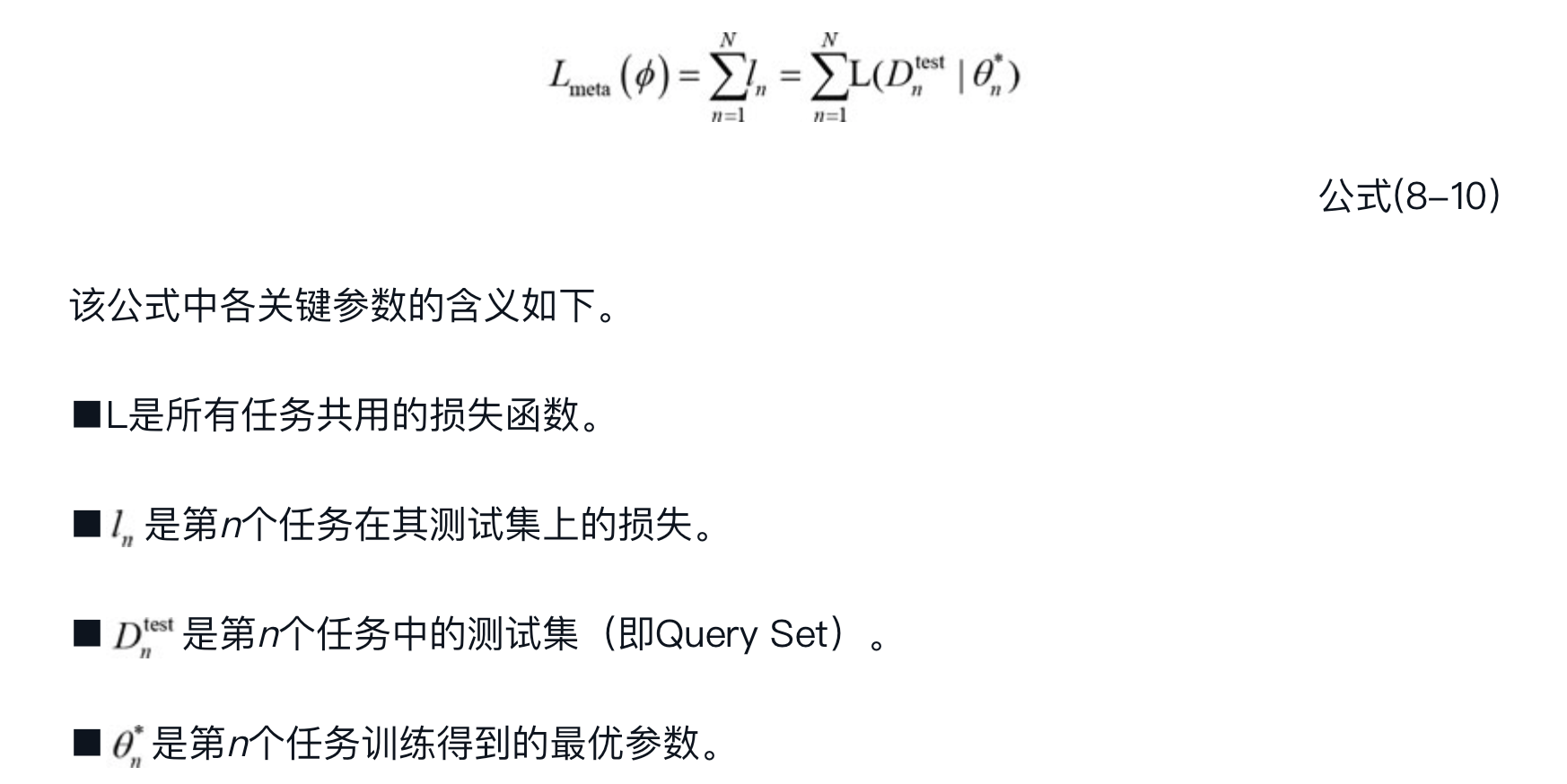

user static pathway #card

用户静态特征转化成 d_model 长度向量

$\mathbf{f}u=\left[\mathbf{e}{\text {uid }} ; \mathbf{e}{\text {gender }} ; \mathbf{e}{\text {age }} ; \cdots\right]$

$\mathbf{h}_u =\operatorname{Dense}\left(\operatorname{LeakyReLU}\left(\operatorname{Dense}\left(\mathbf{f}_u\right)\right)\right)$

short-term pathway #card

处理用户最近 20 次交互视频相关,建模即时偏好和当前行为模式

label 包括用户对每个视频的交互,包括点赞、关注、转发、不喜欢、评论、查看个人资料等

每个视频转化成 d_model 长度向量

$\mathbf{f}s=\left[\mathbf{e}{\text {vid }}^s ; \mathbf{e}{\text {aid }}^s ; \mathbf{e}{\text {tag }}^s ; \mathbf{e}{\text {ts }}^s ; \mathbf{e}{\text {playtime }}^s ; \mathbf{e}{\text {dur }}^s ; \mathbf{e}{\text {label }}^s\right]$,

$\mathbf{h}_s=\operatorname{Dense}\left(\operatorname{LeakyReLU}\left(\operatorname{Dense}\left(\mathbf{f}_s\right)\right)\right)$,

positive-feedback pathway #card

256 个有正反馈行为的视频序列

每个视频转化成 d_model 长度向量

$\mathbf{f}p=\left[\mathbf{e}{\text {vid }}^s ; \mathbf{e}{\text {aid }}^s ; \mathbf{e}{\text {tag }}^s ; \mathbf{e}{\text {ts }}^s ; \mathbf{e}{\text {playtime }}^s ; \mathbf{e}{\text {dur }}^s ; \mathbf{e}{\text {label }}^s\right]$,

$\mathbf{h}_p=\operatorname{Dense}\left(\operatorname{LeakyReLU}\left(\operatorname{Dense}\left(\mathbf{f}_p\right)\right)\right)$

lifelong pathway

处理 :-> 包含最多 10 万条视频的超长用户交互历史,两阶段分层压缩策略

[[@Twin v2:Scaling ultra-long user behavior sequence modeling for enhanced ctr prediction at kuaishou]]

Behavior Compression #card

使用多模态内容表示,在每个用户的交互序列上进行分层 K-means 聚类

每步聚类数量设置为 $\lfloor\sqrt[3]{|D|}\rfloor$, D 是当前数据中的项目数,动态调整聚类数量

当前聚类中的类少于阈值 M 时,聚类过程终止,使用最靠近聚类中心的 item 表示该类

Feature Aggregation 构建聚类的代表特征#card

稀疏类别特征 vid,aid 和 label

连续特征 tag、tx、playtime 和 duration

用户长期历史序列 L=2000,每个视频被对应聚类 item 的特征替代#card

The lifelong pathway compresses historical sequences through QFormer #card

+

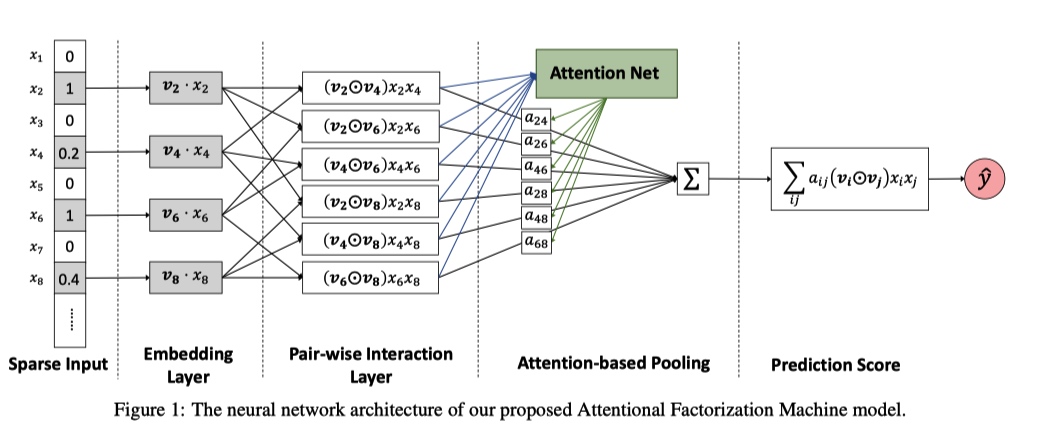

point-wise generation paradigm 点式生成范式

解码器输入 #card

learnable beginning-of-sequence token with the video’s semantic identifiers

$\mathcal{S}m=\left{s{[\mathrm{BOS}]}, s_m^1, s_m^2, \cdots, s_m^{L_t}\right}$

$\mathbf{d}_m^{(0)}=$ Emb_lookup $\left(\mathcal{S}_m\right)$

通过 Ldec 层 Transformer layer 处理序列 #card

Mixture of Experts (MoE) feed-forward network #card

top-k 路由策略

$\operatorname{MoE}(\mathbf{x})=\sum_{j=1}^k \operatorname{Gate}_j(\mathbf{x}) \cdot \operatorname{Expert}_j(\mathbf{x})$,

loss-free load balancing strategy

训练目标 #card

NTP 交叉熵损失

cross-entropy loss for next-token prediction on the semantic identifiers of target video m

$\mathcal{L}{\mathrm{NTP}}=-\sum{j=1}^{L_t-1} \log P\left(s_m^{j+1} \mid\left[s_{[\mathrm{BOS}]}, s_m^1, s_m^2, \cdots, s_m^j\right]\right)$

编码器输入 #card

$\mathbf{z}^{(1)}=\left[\mathbf{h}_u ; \mathbf{h}_s ; \mathbf{h}_p ; \mathbf{h}l\right]+\mathbf{e}{\mathrm{pos}}$

e_pos 代表可学习的 positional embedding

编码器 integrated representation 过程 #card

L enc 层

fully visible self-attention + feed-forward networks with RMS normalization

+ 最后生成 $\mathbf{z}_{\mathrm{enc}}=\mathbf{z}^{\left(L_{e n c}+1\right)} \in \mathbb{R}^{\left(1+L_s+L_p+N_q\right) \times d_{\text {model }}}$ 多尺度用户行为表示

链接: OneRec: 希望更多的人来研究端到端推荐 - 知乎

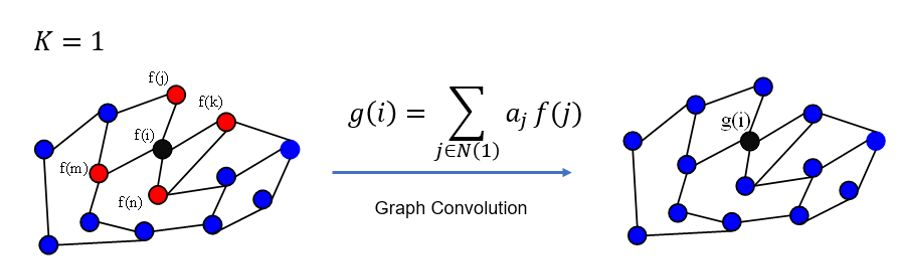

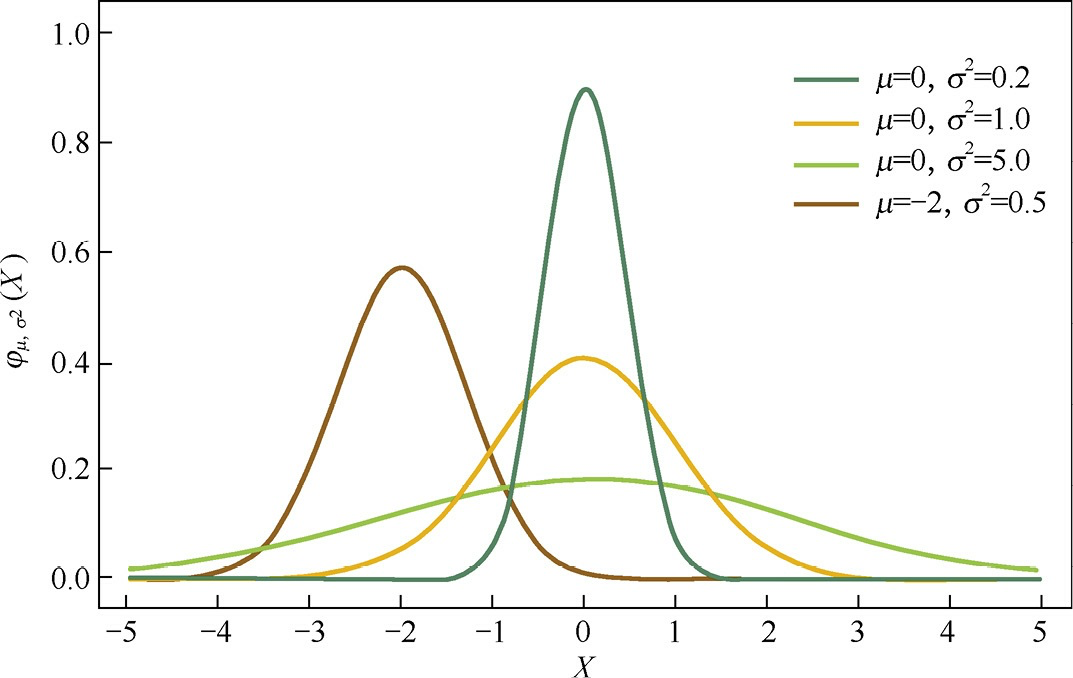

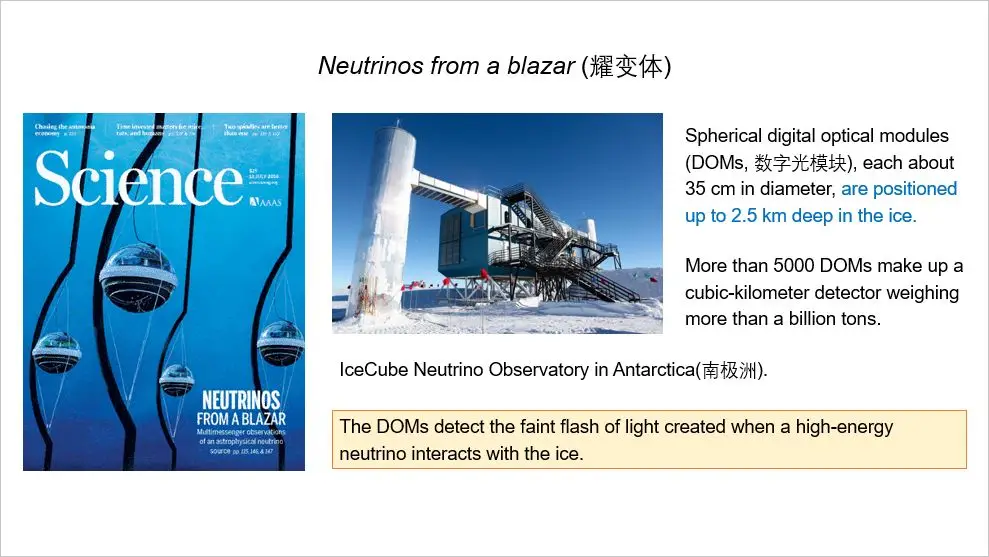

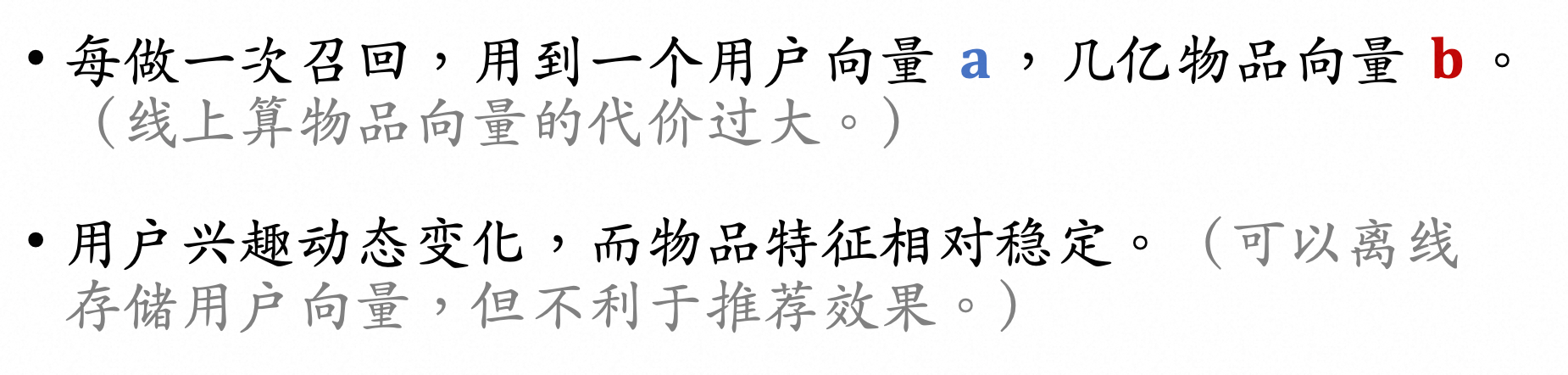

当前的推荐模型架构,广义scaling law最明显的仅在:#card

如果坚信广义的scaling law,模型算力投入越大,效果越好,我们要回答三个问题:#card

其实这条路还有很多事情可以做,希望有更多的同行进来一起走这条路,我们目前正在研究的主要是几个问题:

大方向:

端到端之后,RL特别有效。但什么是好的推荐结果,本身是一个没定义好的问题,#card

因此reward system是一个推荐领域非常值得研究的问题。

可能有些观点会认为learning2rank已经研究过这些了,不过我认为还有挺大的研究空间吧。

毕竟以前那些RL 做learning2rank的工作,只能影响重排,解空间太小了,对系统影响都很小。挺多结论在端到端系统上会变化。

更明显和solid的模型尺寸scaling law。#card

这个我们重构完模型结构设计后有一些进展,看起来还比较promising,估计很快OneRecV2出来就有更清晰的scaling law了。

顺利的话,还挺期待的。这样我们就有机会画出一条线,横轴是公司需要投入的计算成本金额,纵轴是提升的业务数据。大伙儿去申请机器就变得容易了:)

怎么把推荐行为模态和其他多模态在一个LLM基座上对齐。#card

这个还是挺关键的,如果能对齐的话推荐模型就可以在文本空间进行推理思考, 做深度检索,才会让模型达到一个新的高度。

这本身也是我们做OneRec的终极目标。我们有一些思路,看到了眉目,目前可以告诉大家推荐行为模态和LLM肯定是能实现对齐的。但当下进展太小了,就不拿出来贻笑大方了。

还是open到底,把一些更细节一点的迭代也share出来吧,如果大家做得更快就太好了,我们直接用。估计V2就一起和大家见面了,还有一些可能比较小但是作用较大的事也在迭代:

现在的tokenizer其实很简单,我们做了一套端到端的tokenizer方案,目前看也是有提升的。#card

现在生成的模型结构里,除了没办法做target item的attention之外,target item本身的feature也没办法加进去,比如视频的作者信息。#card

我们在做一个item rag,用生成token的前缀去检索相关的item list然后做feature总结。

user rag就不太需要做了,本身新模型结构里能把序列长度拉到上万没啥成本。更长的部分准备用压缩和sparse att的方法。

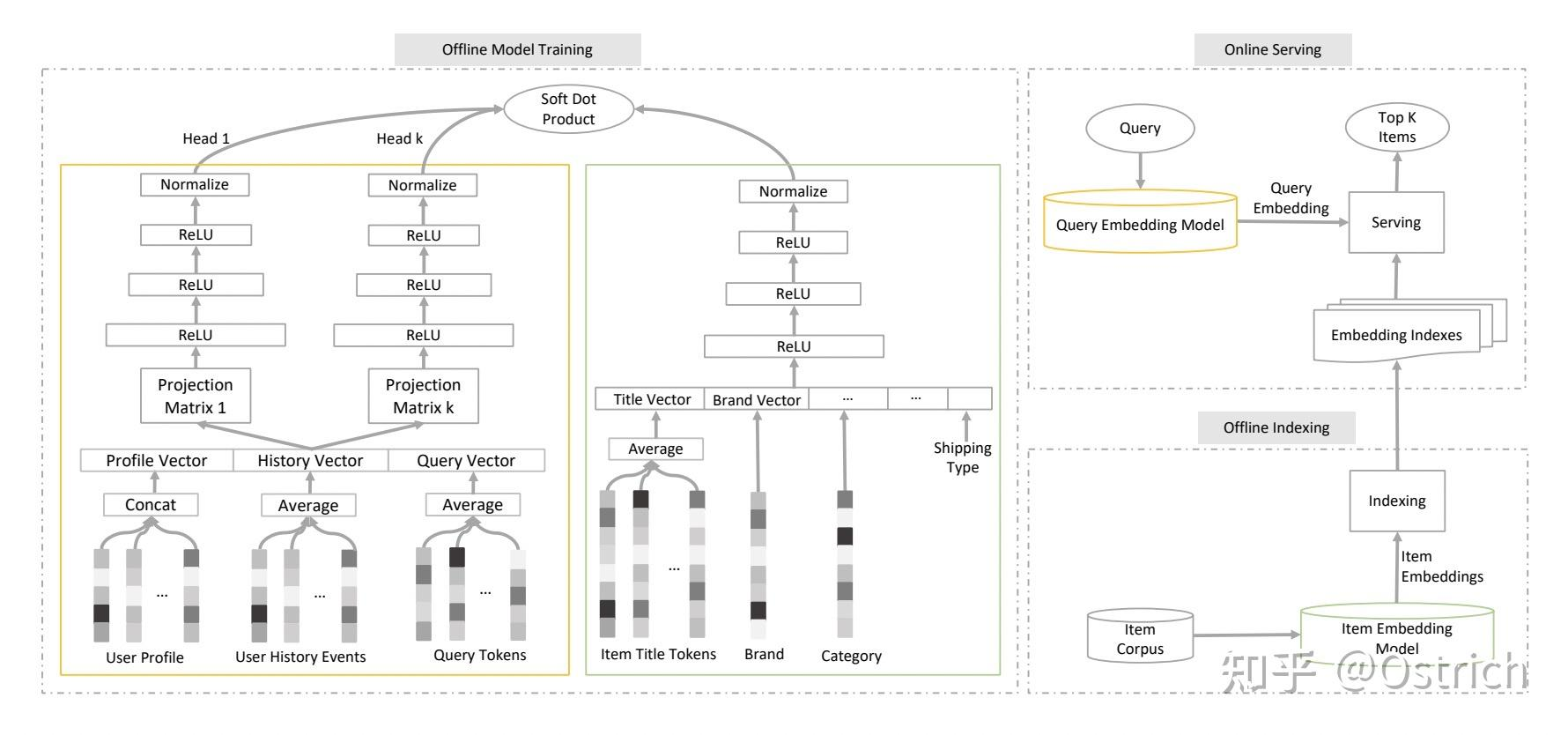

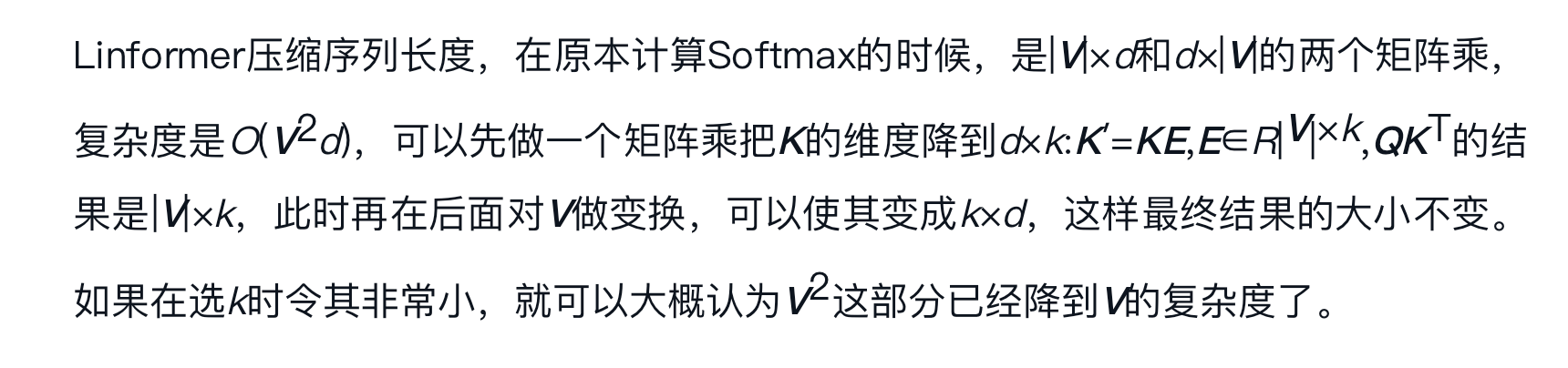

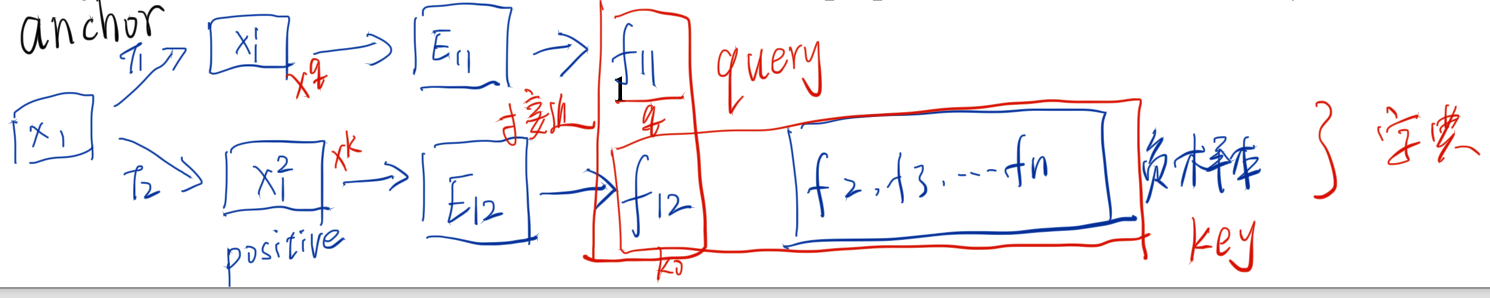

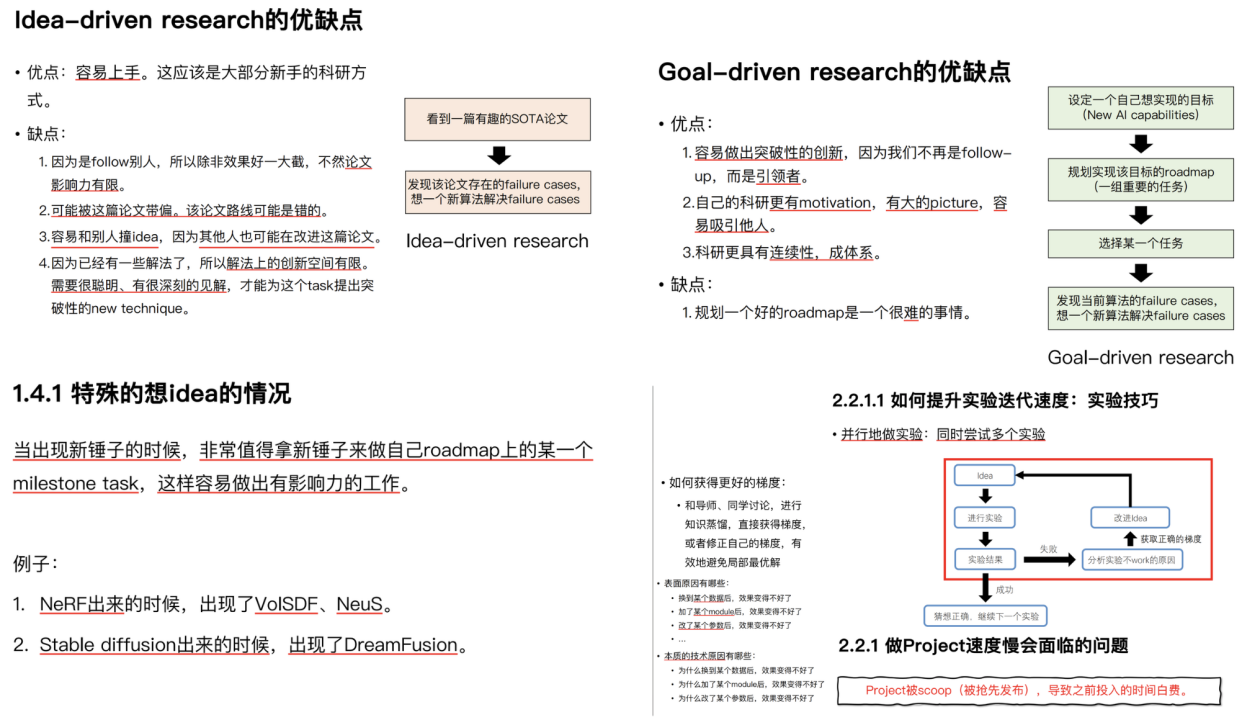

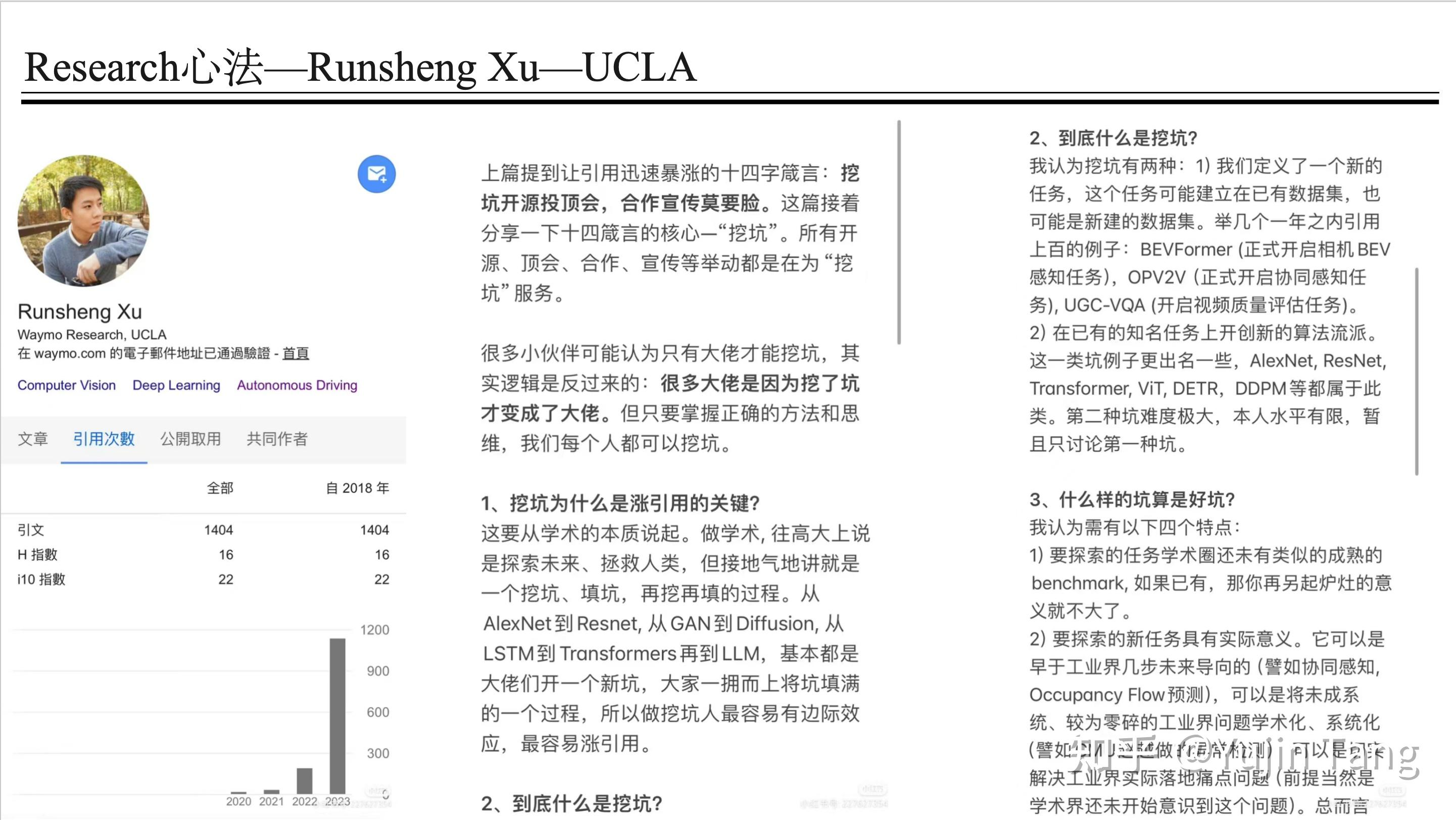

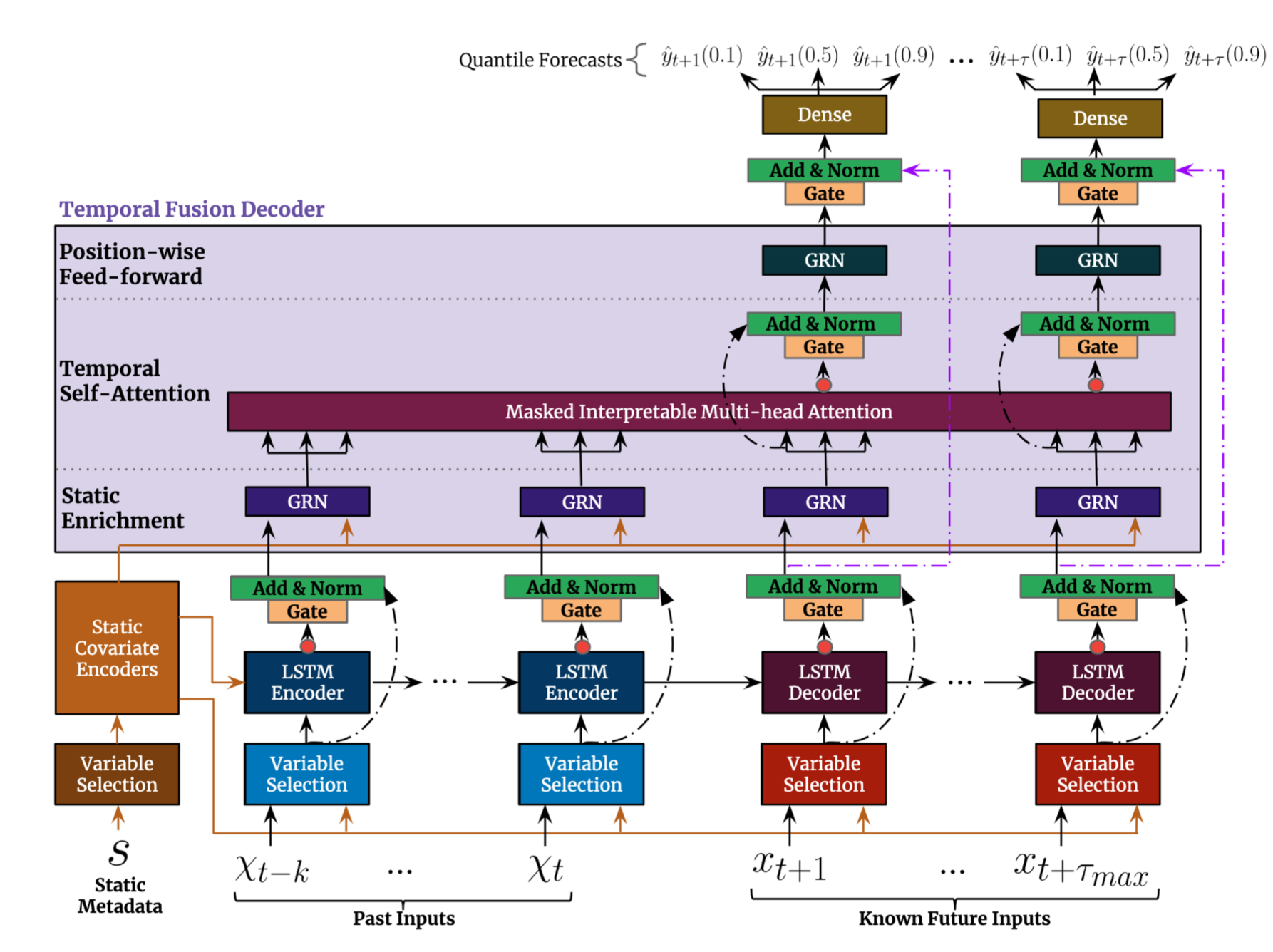

Figure 2:Comparison between a cascaded recommender system and the OneRec.

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc1MDU5OTc0MjM0M18wLnBuZyI6eyJjb25maWciOnt9LCJlbGVtZW50cyI6W3sibGVmdCI6MTQ4NS45NjA2MTExMTAyOTg3LCJ0b3AiOjY3NS4zNjY0NTU4MjAxNDE5LCJ3aWR0aCI6MzUwLjA3ODc3Nzc3OTQwMjU3LCJoZWlnaHQiOjk4LjczMjMwMTQxNTMzNDUyLCJhbmdsZSI6MCwiY0lkIjoxfV19fQ==

分词器示意图

occlusion:: eyIuLi9hc3NldHMvaW1hZ2VfMTc1MDU5OTk0MzE4NV8wLnBuZyI6eyJjb25maWciOnsiaGlkZUFsbFRlc3RPbmUiOnRydWV9LCJlbGVtZW50cyI6W3sibGVmdCI6NDQ4LjkyMzgxODYxNjM2MiwidG9wIjoyNzIuMDIxMTM0NTEzNzUxNCwid2lkdGgiOjY4My43MDIyMzAwNjA5MTg2LCJoZWlnaHQiOjUwLjIxNTQ2NzA4NDI0NTIzLCJhbmdsZSI6MCwiY0lkIjoxfSx7ImxlZnQiOjEzMTEuMTUzNzU2NjA4Nzc4NiwidG9wIjo0NDQuMTk0Mzk5MjAxNjI3MzMsIndpZHRoIjo2NzUuNzQ0Nzk5OTIzNzE3NywiaGVpZ2h0IjozNzUuNTM3Mzg3MTQyNzI5MywiYW5nbGUiOjAsImNJZCI6MX1dfX0=

为每个视频引入了多模态输入:字幕、标签、ASR(语音转文本)、OCR(图像转文本)、封面图片以及 5 个均匀采样的帧。

miniCPM-V-8B 处理生成 $N_M=1280 \text { token vectors } \mathbf{M} \in \mathbb{R}^{N_M \times d_t} \quad\left(d_t=512\right) .$

使用 [[QFormer]] 对面的矩阵进行压缩 $N_{\widetilde{M}}=4 \text { learnable query tokens } \mathbf{Q}^{(1)} \in \mathbb{R}^{N_{\widetilde{M}} \times d_t}$

\begin{aligned}

& \mathbf{Q}^{(i+1)}=\operatorname{Cross} \operatorname{Attn}\left(\mathbf{Q}^{(i)}, \mathbf{M}, \mathbf{M}\right), \

& \mathbf{Q}^{(i+1)}=\operatorname{FFN}\left(\operatorname{RMSNorm}\left(\mathbf{Q}^{(i+1)}\right), \quad \text { for } i \in\left{1,2, \ldots, N_c\right},\right.

\end{aligned}

$$

构建 Item Pair 方法

Item-to-Item Loss and Caption Loss #card

item 间 [[contrastive loss]] 对比学习 loss,将相似的 item 表征进行对齐

字幕 Caption Loss 使用 [[LLaMA3]] 作为解码器进行下一个词(video captions)预测,保持内容理解能力,减少幻觉

[[RQ-Kmeans]] offers enhanced reconstruction quality, better codebook utilization, and improved balance compared to the widely used [[RQ-VAE]] #card

最终一个视频被编码成 :-> Lt coarse-to-fine semantic identifiers $\left{S_m^1, S_m^2, \ldots, S_m^{L_t}\right}$

前文提到,我们估算用一个10B的模型去服务推荐系统,毛利也能满足平台经营需求。而实际上大部分推荐主场景的模型尺寸应该在0.1~0.01B附近。这个GAP背后,最关键的就是推荐系统的算力利用效率极低,从MFU就能体现出来。算力利用效率低下的核心原因是:#card

业务迭代会增加各个模块,如召回/粗排/精排/重排的逻辑复杂度。

大部分成熟的推荐系统都不是单目标的,以短视频场景为例,#card

会有用户体验相关的:互动/观看时长/VV,

社区生态相关的:作品时效性/分阶段作者曝光占比/

社区自治的比如营销感控制/负面情绪控制,

创作相关的:发布作品活跃度/开播活跃度等。

在实际推荐系统的发展过程中,大部分的业务迭代流程是:#card

a. 根据业务意志or判断定下A/B量化目标

b. 在召回/粗排/精排/重排等各个模块施加干预

c. 哪个地方干预提升的A/B多,哪个模块就做对应的改动。

长久以往,推荐系统变得越来越复杂,每个模块都充满了各种奇怪和不可维护的逻辑。经常会出现一个launch review上线的时候有增益,过段时间下线它,又取得了一次收益,”双赢“!。

另一方面,由于如此多的业务目标,慢慢的一个模块内也会开始出现组织分工问题,大家会开始在一个环节内并联增加或者串联增加模块。

比如一个粗排模块,可能会有并行多个粗排模型,它们在不同的人手里维护,为不同的业务目标服务。

前后可能也有多个粗排阶段,这个逻辑排一次,另一个逻辑再排一次。在这么复杂的系统下,如果看机器的OpEx成本,其实大部分钱和系统Latency空间都没花在模型计算上,大部分的金钱成本和latency资源都花在了通信和存储上。

如果把这些考虑进去,大部分公司推荐系统的MFU恐怕连1%都达不到。

非端到端系统中各个模块的解空间限制下,单模块模型结构的设计也会越来越复杂。

即使我们只考虑单一模块,以推荐系统里算力最集中的精排为例,这些模型自己的MFU也不高。#card

一年前我从业务领域回来接手模型团队,看到我手的精排模型在A10上MFU只有个位数,心情挺复杂的。

这个模型和推荐同行比应该不算落后,不谦虚的说可能还比较先进。

但是一个在A10上都只能达到个位数MFU的模型在这个时代是极其落后的,意味着推荐落后于算力发展的红利,要知道LLM在H00上训练MFU都能到40-50%(不考虑fp8的情况)。#card

这背后的原因也很简单,在互联网增速放缓后大家都在降本增效的背景下,总想着算力成本不增长的情况下提升模型效果。

而算法同学一般算不清楚每年单位算力的成本会下降多少,只能约束自己计算FLOPs不要涨太多。

那我们的模型,就只能变成各种奇思妙想的结合体,模型结构极其复杂,各种模块堆叠,到最后,模型图都很难画出来,一个团队可能只有少数几个人知道完整的模型长啥样。

复杂的模型结构会让硬件花费大量的时间去做kernel调度,产生大量的非计算耗时,外加模型本身计算FLOPs不够大,自然MFU就低了。一个用不好算力的模型,不会是一个好模型。

如果我们去做一个端到端的推荐系统,一个系统只有一个模块就完成推荐结果的运算。我们就有机会把模型做简单,把模型做大,并且系统复杂度劣化的速度急剧减慢:#card

端到端系统下,没有链路一致性的问题,模型的影响被极致放大,好坏都赖自己。迭代过程中模型本身的作用和受关注度被放大,更有可能帮助模型迭代走向正轨。

简化的系统下,latency和计算成本资源都集中给模型,我们有机会把模型做得更大,MFU更高,形成良性迭代循环。

单模块的系统,不会出现链路不一致的寻租空间,大家更难在系统里增加一些能实现“双赢”(上线有收益,下线再拿一次收益)的变更,系统劣化速度就会减慢。

事实上,端到端的系统还有两个优势:#card

我们更有可能做出符合scaling law的模型,这个放在后面讨论。

同时,端到端的系统,强化学习才有可能发挥真正的作用,推荐的业务迭代会变得更简单。

业务团队只需要定义清楚“什么是好的推荐结果”,并不断的迭代这个好的标准就行了,让强化学习来指导这个端到端的推荐系统。

非算法同学不再需要理解召回/粗排/精排,以及各个模块的工作机制,深入链路里施加干预,能进一步保持系统的干净优雅。

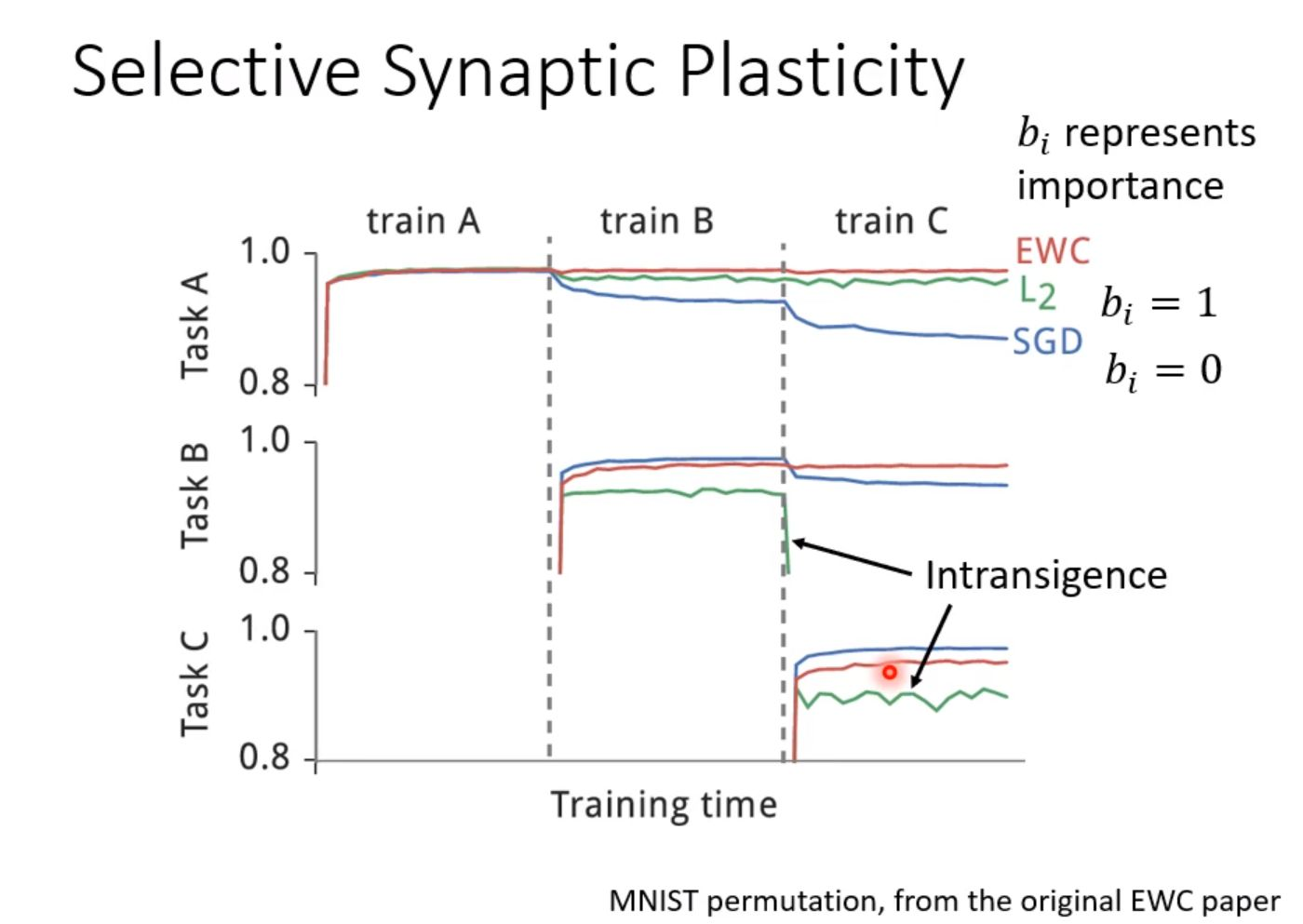

先思考为什么推荐模型,如精排模型,没有明显的scaling law。我想主要是三个问题:

推荐模型在非常长的时间内,都被定义为解决一个判别问题,即已知推荐结果item的情况下,预测用户接受的概率 P(xtr|item,user).#card